Hervorragende Software und praktische Tutorials

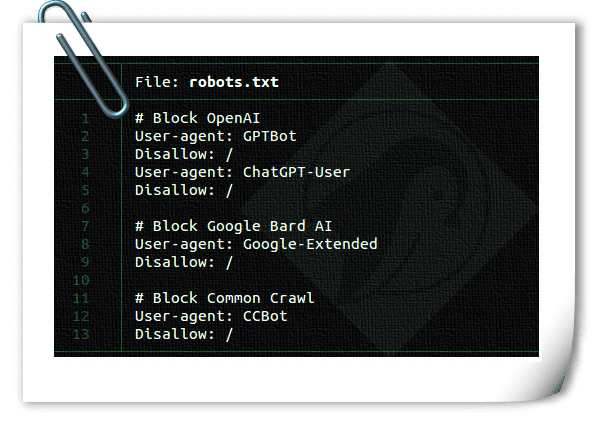

So blockieren Sie KI-Crawler mit robots.txt

Wie blockiere ich KI-Crawler? Egal, ob Sie Content-Ersteller oder Blogger sind – Sie verdienen Ihren Lebensunterhalt mit der Erstellung einzigartiger, hochwertiger Inhalte. Ist Ihnen schon aufgefallen, dass generative KI-Plattformen wie OpenAI oder CCBot Ihre Inhalte nutzen, um ihre Algorithmen ohne Ihre Zustimmung zu trainieren? Keine Sorge! Mit einer robots.txt-Datei können Sie den Zugriff dieser KI-Crawler auf Ihre Website oder Ihren Blog blockieren. Was ist robots.txt?