Hervorragende Software und praktische Tutorials

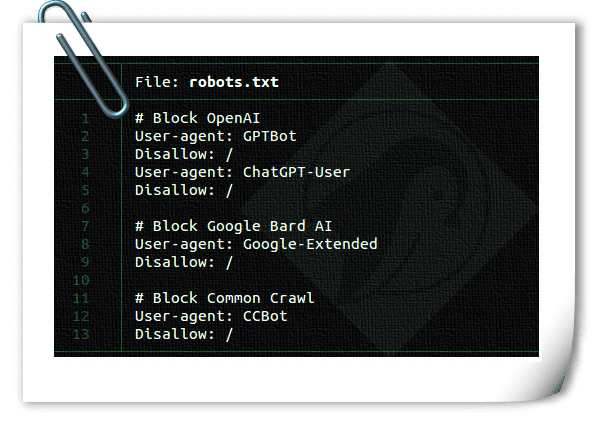

WieStoppen von AI Scraping BotsOb Content-Ersteller oder Blogger – Sie verdienen Ihren Lebensunterhalt mit der Erstellung einzigartiger, hochwertiger Inhalte. Ist Ihnen schon aufgefallen, dass generative KI-Plattformen wie OpenAI oder CCBot Ihre Inhalte nutzen, um ihre Algorithmen ohne Ihre Zustimmung zu trainieren? Keine Sorge! Sie können RoboterDie TXT-Datei blockiert den Zugriff dieser KI-Crawler auf Ihre Website oder Ihr Blog.

Was ist eine robots.txt-Datei?

Robots.txt ist eine Textdatei, die Robotern (z. B. Suchmaschinen-Robots) Anweisungen zum Crawlen und Indexieren der Seiten ihrer Website gibt. Sie können gute oder schlechte Roboter, die Ihrer robots.txt-Datei folgen, blockieren/zulassen. Die Syntax zum Blockieren eines einzelnen Roboters mithilfe eines User-Agents lautet wie folgt:

Benutzeragent: {BOT-NAME-HERE} nicht zulassen: /

So gestatten Sie bestimmten Robotern das Crawlen Ihrer Site mithilfe eines User-Agents:

Benutzeragent: {BOT-NAME-HERE} Zulassen: /

Wo soll die robots.txt-Datei abgelegt werden?

Laden Sie die Datei in den Stammordner Ihrer Website hoch. Die URL sieht dann folgendermaßen aus:

https://example.com/robots.txt https://blog.example.com/robots.txt

Weitere Informationen zu robots.txt finden Sie in den folgenden Ressourcen:

- Von GoogleEinführung in robots.txt.

- Was ist robots.txt? | So erstellen Sie eine robots.txt-DateiIn CloudflareArbeiten.

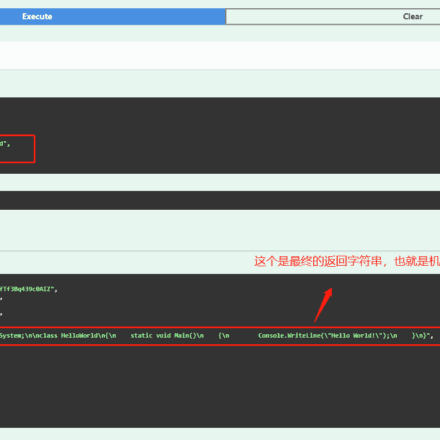

So blockieren Sie KI-Crawler mithilfe der Datei robots.txt

Die Syntax ist dieselbe:

Benutzeragent: {AI-Ccrawlers-Bot-Name-Here} nicht zulassen: /

Blockieren Sie OpenAI mithilfe einer robots.txt-Datei

Fügen Sie der robots.txt die folgenden vier Zeilen hinzu:

Benutzeragent: GPTBot Disallow: / Benutzeragent: ChatGPT-User Disallow: /

Beachten Sie, dass OpenAI zwei separate Benutzeragenten für Web-Crawling und -Browsing mit jeweils eigenem CIDR- und IP-Bereich verwendet. Um die unten aufgeführten Firewall-Regeln zu konfigurieren, benötigen Sie fundierte Kenntnisse der Netzwerkkonzepte und Linux-Root-Zugriff. Sollten Sie diese Kenntnisse nicht haben, sollten Sie die Dienste eines Linux-Systemadministrators in Anspruch nehmen, um den Zugriff über ständig wechselnde IP-Adressbereiche zu verhindern. Dies kann zu einem Katz-und-Maus-Spiel werden.

1:ChatGPT-BenutzerVon ChatGPTPluginsverwenden

Hier ist eine Liste der von OpenAI-Crawlern und -Fetchern verwendeten Benutzeragenten:, einschließlich CIDR- oder IP-Adressbereichen, zum Blockieren von Plugin-KI-Bots, die Sie mit Ihrer Webserver-Firewall verwenden können. Sie können den Befehl ufw oder iptables auf Ihrem Webserver verwenden, um23.98.142.176/28 .Hier ist beispielsweise eine Firewall-Regel zum Blockieren eines CIDR- oder IP-Bereichs mithilfe von UFW:

sudo ufw deny proto tcp von 23.98.142.176/28 zu jedem Port 80 sudo ufw deny proto tcp von 23.98.142.176/28 zu jedem Port 443

2:GPTBotWird von ChatGPT verwendet

Die folgenden Benutzeragenten werden von OpenAI-Crawlern und -Fetchern verwendet:Liste, einschließlichCIDROder IP-Adressbereiche zum Blockieren von KI-Bots, die Sie mit Ihrer Webserver-Firewall verwenden können. Auch diese Bereiche können Sie mit den Befehlen ufw oder iptables blockieren. Hier ist ein Shell-Skript zum Blockieren dieser CIDR-Bereiche:

#!/bin/bash # Zweck: Blockieren Sie OpenAI ChatGPT Bot CIDR # Getestet auf: Debian und Ubuntu Linux # Autor: Vivek Gite {https://www.cyberciti.biz} unter GPL v2.x+ # ------------------------------------------------------------------ file="/tmp/out.txt.$$" wget -q -O "$file" https://openai.com/gptbot-ranges.txt 2>/dev/null while IFS= read -r cidr do sudo ufw deny proto tcp from $cidr to any port 80 sudo ufw deny proto tcp from $cidr to any port 443 done < "$-Datei" [ -f "$-Datei" ] && rm -f "$-Datei"

Blockieren Sie Google AI (APIs zur KI-Generierung von Bard und Vertex)

Fügen Sie Ihrer robots.txt die folgenden zwei Zeilen hinzu:

User-Agent: Google-Extended Disallow: /

Weitere Informationen finden Sie in der folgenden Liste der von Google-Crawlern und -Extraktoren verwendeten Benutzeragenten. Google stellt jedoch keine CIDRs, IP-Adressbereiche oder Autonomous System Information (ASN) zum Blockieren von KI-Bots bereit, die Sie mit Ihrer Webserver-Firewall verwenden können.

Blockieren von Commoncrawl (CCBot) mithilfe der Datei robots.txt

Fügen Sie Ihrer robots.txt die folgenden zwei Zeilen hinzu:

Benutzeragent: CCBot Disallow: /

Obwohl Common Crawl einGemeinnützige Stiftung, aber jeder nutzt Daten, um seine KI über seinen Bot namens CCbot zu trainieren. Es ist auch wichtig, diese zu blockieren. Genau wie Google stellen sie jedoch keine CIDR, IP-Adressbereiche oder Autonomous System Information (ASN) zur Verfügung, um KI-Bots zu blockieren, die Sie mit Ihrer Webserver-Firewall verwenden können.

Blockieren Sie Perplexity AI mithilfe einer robots.txt-Datei

Ein weiterer Dienst, der alle Ihre Inhalte mithilfe generativer künstlicher Intelligenz neu schreibt. Sie können ihn wie folgt blockieren:

Benutzeragent: PerplexityBot Disallow: /

Sie veröffentlichten auchIP-Adressbereich, können Sie es mit einer WAF- oder Webserver-Firewall blockieren.

Können KI-Bots meine robots.txt-Datei ignorieren?

Namhafte Unternehmen wie Google und OpenAI halten sich in der Regel an die robots.txt-Protokolle. Einige schlecht konzipierte KI-Bots ignorieren Ihre robots.txt-Datei jedoch.

Kann die AWS- oder Cloudflare-WAF-Technologie zum Blockieren von KI-Bots verwendet werden?

Cloudflare gab kürzlich bekanntwurde eine neue Firewall-Regel eingeführt, die KI-Bots blockiert. Suchmaschinen und andere Bots können Ihre Website/Ihren Blog jedoch weiterhin über die WAF-Regeln nutzen. Wichtig ist, dass WAF-Produkte ein umfassendes Verständnis der Funktionsweise von Bots erfordern und mit Sorgfalt implementiert werden müssen. Andernfalls kann es dazu führen, dass auch andere Benutzer blockiert werden. So blockieren Sie KI-Bots mit Cloudflare WAF:

Ich evaluiere die Cloudflare-Lösung, aber meine ersten Tests zeigen, dass sie mindestens 3,311 TP3T Nutzer blockiert. 3,311 TP3T ist die CSR-Rate (Challenge Resolution Rate), also die Anzahl der Nutzer, die das von Cloudflare bereitgestellte CAPTCHA lösen. Das ist eine hohe CSR-Rate. Ich muss noch weitere Tests durchführen. Ich werde diesen Blogbeitrag aktualisieren, sobald ich Cloudflare nutze.

Kann ich den Zugriff auf Code und Dokumente blockieren, die auf GitHub und anderen Cloud-Hosting-Sites gehostet werden?

Nein, ich weiß nicht, ob das möglich ist.

Ich habe Bedenken hinsichtlich der Nutzung von GitHub, einem Produkt von Microsoft und dem größten Investor in OpenAI. Microsoft könnte Ihre Daten nutzen, um KI über aktualisierte Nutzungsbedingungen und andere Schlupflöcher zu trainieren. Am besten hosten Sie oder Ihr Unternehmen den Git-Server unabhängig, um zu verhindern, dass Ihre Daten und Ihr Code für das Training verwendet werden. Große Unternehmen wie Apple verbieten die interne Nutzung von ChatGPT und ähnlichen Produkten, da sie befürchten, dass dies zu Code- und sensiblen Datenlecks führen könnte.

Wenn KI zum Wohle der Menschheit eingesetzt wird, ist es dann ethisch vertretbar, KI-Roboter daran zu hindern, Trainingsdaten zu erhalten?

Ich bin skeptisch, was den Einsatz von OpenAI, Google Bard, Microsoft Bing oder anderer KI zum Wohle der Menschheit angeht. Es scheint nur ein Versuch zu sein, Geld zu verdienen, während generative KI Bürojobs ersetzt. Wenn Sie jedoch Informationen darüber haben, wie meine Daten zur Heilung von Krebs (oder Ähnlichem) eingesetzt werden könnten, teilen Sie diese gerne im Kommentarbereich mit.

Ich persönlich bin der Meinung, dass ich derzeit nicht von OpenAI/Google/Bing AI oder irgendeiner anderen KI profitiere. Ich habe über 20 Jahre hart gearbeitet und muss meine Arbeit vor der direkten Profitgier dieser großen Tech-Unternehmen schützen. Sie müssen mir nicht zustimmen. Sie können Ihren Code und andere Inhalte der KI überlassen. Denken Sie daran: Es ist optional. Der einzige Grund, warum sie jetzt robots.txt-Kontrolle anbieten, ist, dass mehrere Buchautoren und Unternehmen sie verklagen. Darüber hinaus wurden KI-Tools zur Erstellung von Spam-Websites und E-Books eingesetzt. Nachfolgend finden Sie ausgewählte Lektüre:

- Sarah Silverman verklagt OpenAI und Meta

- KI-Bildersteller stehen in Großbritannien und den USA vor rechtlichen Herausforderungen

- Stack Overflow ist ein Opfer von ChatGPT: Der Datenverkehr ging im März um 14% zurück

- Autor verwendet ChatGPT, um Kindle-Bücher zu spammen

- ChatGPT in Italien wegen Datenschutzbedenken verboten

- KI-Spam verbreitet sich bereits im Internet, und es gibt deutliche Anzeichen dafür

- Experten warnen: KI könnte zum Aussterben führen

- Künstliche Intelligenz wird zur Generierung ganzer Spam-Websites eingesetzt

- Das Unternehmen plant, menschliche Mitarbeiter aufzugeben und künstliche Intelligenz im ChatGPT-Stil einzuführen

- Die geheime Liste von Websites, die ChatGPT und andere KIs intelligent klingen lassen

Es stimmt, dass KI bereits einen Großteil Ihrer Daten nutzt, aber alles, was Sie in Zukunft erstellen, kann durch diese Technologien geschützt werden.

Zusammenfassen

Mit der zunehmenden Verbreitung generativer KI beginnen Content-Ersteller, KI-Unternehmen zu kritisieren, weil sie Daten unberechtigt zum Trainieren ihrer Modelle verwenden. Sie profitieren vom Code, den Texten, Bildern und Videos, die von Millionen kleiner, unabhängiger Entwickler erstellt wurden, und berauben diese gleichzeitig ihrer Einnahmequellen. Manche mögen keine Einwände haben, aber ich weiß, dass ein solch plötzlicher Schritt viele Menschen in den Ruin treiben würde. Daher sollten Website-Betreiber und Content-Ersteller unerwünschte KI-Crawler problemlos blockieren können. Der Prozess sollte unkompliziert sein.

Ich werde diese Seite aktualisieren, da weitere Bots über robots.txt und mithilfe von Cloud-Lösungen von Drittanbietern wie Cloudflare blockiert werden können.

Andere Open-Source-Projekte zum Blockieren von Bots

- Nginx Bad Bot und User Agent Blocker

- Fail2BanScannen Sie Protokolldateien wie /var/log/auth.log und sperren Sie IP-Adressen, die zu viele fehlgeschlagene Anmeldeversuche machen.