Hervorragende Software und praktische Tutorials

SEO-Optimierung

SEO-Optimierung Google SEOWie geht das? Mit BaiduSuchmaschinenoptimierung (SEO)Wie groß ist der Unterschied? Im Wesentlichen nicht viel, aber im Detail gibt es einige Unterschiede.Google SEO ist sehr wichtig. Vor einigen Tagen stellte mir ein Freund aus der SEO-Abteilung eines großen inländischen E-Commerce-Unternehmens eine sehr interessante Frage zum Google-Ranking. Sie lässt sich nicht in ein oder zwei Sätzen erklären, deshalb habe ich einen Beitrag verfasst, der anderen SEOs hilfreich sein könnte.

TDK-Optimierung

TDKTitel,Beschreibung,SchlüsselwörterEin allgemeiner Begriff für die drei. NatürlichTitelist am nützlichsten und es lohnt sich sehr, es zu optimieren;SchlüsselwörterDa es in der Vergangenheit von SEO-Leuten überstrapaziert wurde, ist eine Optimierung für Suchmaschinen nutzlos, daher werde ich hier nicht näher darauf eingehen.BeschreibungDie Beschreibung wird direkt in der Sucheinführung angezeigt, sodass Benutzer sehr effektiv entscheiden können, ob sie klicken sollen.

Titeloptimierung

TitelDie Separatoren sind in der Regel,,_,-usw., darunter_Es ist freundlicher zu Baidu,-Es ist benutzerfreundlicher für Google. Das vierte Zeichen ist ein Leerzeichen. Es kann auf englischen Websites verwendet werden, wird auf chinesischen Websites jedoch selten verwendet.TitelDie Länge beträgt in der Regel etwa 30 chinesische Zeichen auf dem PC und 20 chinesische Zeichen auf dem Handy. Wenn diese Länge überschritten wird, wird der Text durch Auslassungspunkte gekürzt.

Aufgrund unserer Geschäftsbeziehungen konzentrieren wir uns stärker auf die Suchmaschinenoptimierung für Baidu. Hier sind daher einige Vorschläge zur Suchmaschinenoptimierung für Baidu:

TitelFormat:

- Titelseite:

WebsitenameoderName der Website_Dienstleistungseinführung oder Produkteinführung bereitstellen - Kanalseite:

Kanalname_Websitename - Artikelseite:

Artikeltitel_Kanalname_Websitename

Wenn Ihr Artikeltitel nicht sehr lang ist, können Sie auch hinzufügenSchlüsselwörterGehen Sie hinein, alsArtikeltitel_Schlüsselwörter_Websitename

Empfohlene Vorgehensweise:

- Jede Webseite sollte einen eindeutigen Titel haben. Vermeiden Sie die Verwendung desselben Standardtitels für alle Seiten.

- Der Titel sollte eindeutig sein und die wichtigsten Inhalte dieser Webseite enthalten.

- Fassen Sie sich präzise und listen Sie keine Informationen auf, die für den Inhalt der Webseite irrelevant sind.

- Benutzer blättern normalerweise von links nach rechts und wichtige Inhalte sollten am Anfang des Titels platziert werden.

- Verwenden Sie eine Sprache, mit der Ihre Nutzer vertraut sind. Wenn Sie sowohl chinesische als auch englische Website-Namen haben, versuchen Sie, den Namen, mit dem Ihre Nutzer vertraut sind, als Titelbeschreibung zu verwenden.

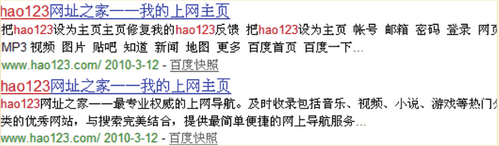

Beschreibungsoptimierung

BeschreibungEs ist kein Referenzfaktor für die Gewichtsberechnung. Das Vorhandensein oder Fehlen dieses Tags hat keinen Einfluss auf die Gewichtung der Webseite. Es dient lediglich als Auswahlziel für Suchergebniszusammenfassungen. Seine Länge beträgt etwa 78 chinesische Zeichen auf der PC-Seite und 50 auf der mobilen Seite. Bei Überschreitung wird es auf Auslassungspunkte gekürzt.

Baidu empfiehlt:

- Beschreibungen eignen sich am besten für Website-Startseiten, Kanalseiten, Produktparameterseiten usw., die keine langen Textabsätze enthalten, die als Zusammenfassungen verwendet werden können.

- Beschreiben Sie die Seite genau und überladen Sie sie nicht mit Schlüsselwörtern.

- Erstellen Sie für jede Seite eine andere Beschreibung, um zu vermeiden, dass Sie für alle Seiten dieselbe Beschreibung verwenden.

- Angemessene Länge, nicht zu lang oder zu kurz

Nachfolgend finden Sie zwei von Baidu empfohlene Beispiele zum Vergleich. Das erste Beispiel verwendet keine Meta-Beschreibung, das zweite hingegen schon. Es ist ersichtlich, dass die Zusammenfassung des ersten Ergebnisses für Nutzer grundsätzlich keinen Bezugswert hat, während die Zusammenfassung des zweiten Ergebnisses lesbarer ist und Nutzern ein besseres Verständnis des Website-Inhalts ermöglicht.

Optimierung des Seiteninhalts

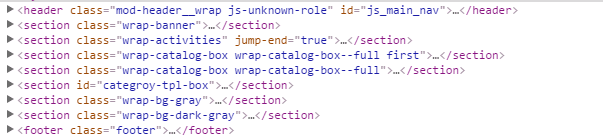

Verwenden der HTML5-Struktur

Wenn die Bedingungen es zulassen (z. B. mobile Endgeräte, kompatibel mit IE9+, wenn IE8+, führen Sie es für IE8 einhtml5.jsEs ist an der Zeit, über die Verwendung semantischer HTML5-Tags nachzudenken.Kopfzeile,Fußzeile,Abschnitt,beiseite,Navigation,ArtikelWarten Sie, hier machen wir einen Screenshot, um das Gesamtlayout zu sehen

Eindeutiger H1-Titel

Jede Seite sollte einen eindeutigen h1-Titel haben, aber nicht jeder h1-Titel ist der Name der Website. (In HTML5 kann der h1-Titel jedoch mehrfach vorkommen, und jedes Tag mit einer Strukturübersicht kann einen eigenen, unabhängigen h1-Titel haben, wie zum Beispiel:Kopfzeile,Fußzeile,Abschnitt,beiseite,Artikel)

Der H1-Titel der Homepage ist der Site-Name, und der H1-Titel der internen Seite ist der Titel jeder internen Seite. Beispielsweise verwendet die Kategorieseite den Kategorienamen und die Detailseite den Titel der Detailseite als H1-Titel.

<!-- Titelseite -->

<h1 Klasse="Seite-tt">Tencent-Klassenzimmer</h1>

<!-- Kategorieseite -->

<h1 Klasse="Seite-tt">Online-Schulungsvideo-Tutorial zur Front-End-Entwicklung</h1>

<!-- Detailseite -->

<h1 Klasse="Seite-tt">html5+CSS3</h1>IMG-EinstellungenaltEigentum

imgErforderlichaltAttribute, wenn Breite und Höhe fest sind, legen Sie bitte gleichzeitig die festen Werte fest

<img src="" alt="seo优化实战" width="200" height="100" />nofollow

Für Links, die nicht verfolgt und gecrawlt werden müssen, setzen SienofollowEs kann in Blogkommentaren, Forenbeiträgen, auf Websites sozialer Netzwerke, in Message Boards usw. verwendet werden. Es kann auch für Werbelinks, Datenschutzrichtlinien, Benutzerbedingungen, Anmeldungen usw. verwendet werden. Der folgende Code gibt an, dass der Link nicht verfolgt und gecrawlt werden muss, wodurch Spider am Crawlen und Übertragen von Gewichten gehindert werden können.

<ein href="http://example.com" relativ="nofollow">Kein Follow-Link</A>Text

Inhaltliche Überlegungen:

- Naturschreiben

- Hochwertiger Originalinhalt

- Schreibtechniken, die Leser anziehen

- Verkaufsargumente hervorheben

- Vertrauen stärken

- Zu weiterem Verhalten führen

Überlegungen zur Benutzererfahrung:

- Das Layout ist sinnvoll, klar, schön und die Schriftarten und der Hintergrund sind gut lesbar

- Der eigentliche Inhalt steht an der wichtigsten Stelle der Seite und ist für den Nutzer auf einen Blick erkennbar

- Inhaltliche Inhalte und Werbung lassen sich klar voneinander unterscheiden

- Der erste Bildschirm enthält umfangreiche Inhalte, sodass Sie nicht nach unten scrollen müssen, um sie anzuzeigen.

- Die Anzahl der Anzeigen sollte nicht zu groß sein und ihre Platzierung sollte den Nutzer nicht beim Lesen behindern.

- Wenn Bilder und Videos den Benutzern helfen können, den Inhalt der Seite zu verstehen, versuchen Sie, Bilder und Videos usw. zu erstellen.

- Vermeiden Sie zu viele Pop-ups

URL-Optimierung

URL-Designprinzipien:

- Je kürzer, desto besser

- Vermeiden Sie zu viele Parameter

- Halten Sie die Verzeichnisebenen so klein wie möglich

- Verwenden Sie aussagekräftige Datei- und Verzeichnisnamen

- Schlüsselwörter in die URL einschließen (außer Chinesisch)

- Alle Kleinbuchstaben

- Verwendung von Bindestrichen

-Statt_ - Verzeichnisformat statt Dateiformat

Statische URL

Mit den aktuellen Crawling-Funktionen der Suchmaschinen ist es nicht notwendig, die URL statisch zu machen, aber im Hinblick auf die einfache Einbindung, das Benutzererlebnis und die soziale Teilung sind statische und kurze URLs vorteilhafter.

URL statisch oder nicht?

Datenbankbasierte Websites müssen ihre URLs statisch halten. Das war schon immer eine grundlegende Voraussetzung für SEO und ist selbstverständlich. Leider gibt es mittlerweile keine Websites mehr, die nicht datenbankbasiert sind.

In den letzten Jahren hat sich die SEO-Branche einstimmig darauf geeinigt, dass zwei bis drei Fragezeichen in einer URL kein Problem darstellen, da Suchmaschinen diese in der Regel indexieren können, insbesondere bei Domains mit hoher Autorität. Auch mehr Fragezeichen stellen kein Problem dar. Es wird jedoch generell empfohlen, die URL ohnehin statisch zu gestalten.

Im September 2008 veröffentlichte das Google Webmaster Blog einen Beitrag, der dynamische und statische URLs diskutierte und diese Ansicht widerlegte. Darin empfahl Google ausdrücklich, dynamische URLs nicht statisch zu gestalten, sondern lange dynamische URLs mit Fragezeichenparametern beizubehalten. Google Blackboard und das chinesische Webmaster Blog haben den Beitrag übersetzt und erneut veröffentlicht. Sie können ihn sich ansehen.

Den Kommentaren und Blogs nach zu urteilen, die ich gelesen habe, halten es tatsächlich ziemlich viele Leute für sinnvoll und sind bereit, das zu tun, was Google sagt.

Dies ist ein relativ seltener SEO-Vorschlag von Google und einer, dem ich überhaupt nicht zustimme.

Der Beitrag von Google enthält mehrere wichtige Punkte.

Erstens ist Google durchaus in der Lage, dynamische URLs zu crawlen, und egal wie viele Fragezeichen vorhanden sind, stellt dies kein Problem dar. Dies ist grundsätzlich zuverlässig. Was aber, wenn die URL mehr als zehn oder zwanzig Fragezeichen und Parameter enthält? Wie wird Google das sehen? Selbst wenn die URL crawlbar ist, wird sie gecrawlt? Wie werden andere Suchmaschinen damit umgehen?

Zweitens sind dynamische URLs für Google-Spider hilfreicher, um die Bedeutung von URLs zu verstehen und sie zu identifizieren, da die Parameter in den URLs suggestiv sind. Google gab beispielsweise folgendes Beispiel:

http://www.example.com/article/bin/answer.foo?language=en&answer=3&sid=98971298178906&query=URL

Die Parameter in der URL helfen Google, die URL und den Inhalt der Webseite zu verstehen. Beispielsweise steht der Parameter nach „language“ für die Eingabesprache, der Parameter nach „answer“ für die Artikelnummer und der Parameter nach „sid“ für die Sitzungs-ID. Weitere häufig verwendete Parameter sind beispielsweise der Parameter nach „color“ für die Farbe, der Parameter nach „size“ für die Größe usw. Mithilfe dieser Parameter kann Google die Webseite leichter verstehen.

Bei statischen URLs ist die Bedeutung dieser Parameter meist unklar. Beispiel:

http://www.example.com/shoes/red/7/12/men/index.html

Dadurch kann Google möglicherweise nicht mehr erkennen, welche Seriennummer das Produkt hat, welche Größe es hat usw.

Drittens können bei der statischen URL leicht Fehler passieren, was noch kontraproduktiver ist. Ändert man beispielsweise die Reihenfolge der Parameter in einer dynamischen URL, ist die resultierende Seite tatsächlich dieselbe. Beispielsweise handelt es sich bei diesen beiden URLs wahrscheinlich um dieselbe Seite:

http://www.example.com/article/bin/answer.foo?language=en&answer=3

http://www.example.com/article/bin/answer.foo?answer=3&language=en

Durch die Beibehaltung der dynamischen URL erkennt Google leichter, dass es sich um dieselbe Webseite handelt. Nach der Erstellung der statischen URL ist es für Google nicht mehr so einfach zu erkennen, ob es sich bei den beiden URLs um dieselbe Seite handelt. Dies kann zu doppelten Inhalten führen:

http://www.example.com/shoes/men/7/red/index.html

http://www.example.com/shoes/red/7/men/index.html

Ein weiterer häufiger Fehler ist die Sitzungs-ID, die auch statisch in der URL codiert sein kann:

http://www.example.com/article/bin/answer.foo/en/3/98971298178906/URL

Dadurch wird eine große Anzahl von Seiten mit unterschiedlichen URLs, aber demselben Inhalt generiert.

Daher empfiehlt Google, URLs nicht statisch zu gestalten.

Ich empfehle dennoch die Statifizierung. Die Gründe dafür sind:

Zunächst einmal stammen die Ratschläge von Google selbst und berücksichtigen keine anderen Suchmaschinen. Nur weil Google problemlos dynamische URLs crawlen kann, heißt das nicht, dass Yahoo, Baidu, Microsoft usw. ebenfalls problemlos crawlen können. Insbesondere bei chinesischen Websites ist Google nicht der Chef. Tatsächlich zögert Baidu bis heute, im Jahr 2021, URLs mit mehreren Fragezeichen zu crawlen.

Zweitens basieren die von Google genannten Nachteile der Statik auf der Annahme, dass die Statikierung fehlerhaft durchgeführt wird. Das Problem ist, dass eine korrekte Statikierung erforderlich ist. Es ist unsinnig, von einer fehlerhaften Ausführung auszugehen. Wie viele Personen geben die Sitzungs-ID bei der Statikisierung der URL ein?

Drittens: Googles Vorschlag ist in der Regel zu dessen Gunsten, nicht aber zu Gunsten des Nutzers. URLs mit Fragezeichen-Parametern mögen Google zwar helfen, den Inhalt zu verstehen, erschweren es Nutzern aber offensichtlich sehr, die Website-Struktur und den allgemeinen Inhalt auf einen Blick zu erfassen. Welche dieser beiden URLs ist klarer, leichter lesbar und wird eher angeklickt?

http://www.example.com/product/men/shoes/index.html

Offensichtlich das Zweite.

Darüber hinaus sind lange dynamische URLs nicht gut im Gedächtnis haften und nicht gut zum Kopieren in E-Mails, auf Social-Networking-Sites usw. geeignet.

Kurz gesagt: Obwohl Google eindeutig empfiehlt, dynamische URLs beizubehalten, empfehle ich dennoch, das Gegenteil zu tun und URLs so weit wie möglich statisch zu gestalten.

URL-Normalisierung

1. Einheitliche Verbindung

http://www.Domänenname.com

http://Domänenname.com

http://www.Domänenname.com/Index.html

http://Domänenname.com/Index.htmlBei den oben genannten vier handelt es sich tatsächlich um Homepages. Obwohl sie für Besucher keine Probleme bereiten, sind es für Suchmaschinen lediglich vier URLs mit identischem Inhalt, was als Betrug missverstanden werden kann. Wenn Suchmaschinen URLs standardisieren möchten, müssen sie aus diesen Optionen die beste Variante auswählen. Die gewählte URL entspricht jedoch möglicherweise nicht Ihren Wünschen. Daher ist es am besten, die URL selbst zu standardisieren.

2. 301-Weiterleitung

Der erste Fall ist, wenn sich die URL ändert. Sie müssen die alte Adresse per 301 auf die neue Adresse verweisen lassen, sonst ist die gesamte vorherige Einschlussgewichtung vergebens.

Das zweite ist etwasCMSSystem ist es sehr wahrscheinlich, dass mehrere Pfade demselben Artikel entsprechen.DrupalDer Standardpfad istKnoten/NIDWenn das Pfad-Token aktiviert ist, können Sie den Pfad jedoch selbst anpassen. Auf diese Weise gibt es zwei Pfade, die demselben Artikel entsprechen. Sie können also 301 aktivieren und schließlich auf einen Pfad umleiten.

3. kanonisch

Dieses Tag gibt die Einzigartigkeit der Seite an (dieses Tag wurde zuvor von Baidu nicht unterstützt, wird jetzt aber unterstützt). Es wird bei der Übergabe von Parametern verwendet, beispielsweise:

//:ke.qq.com/download/app.html

//:ke.qq.com/download/app.html?from=123

//:ke.qq.com/download/app.html?from=456Die drei oben genannten Seiten repräsentieren drei Seiten, aber die letzten beiden dienen nur dazu, zu zeigen, woher sie kommen. Um sicherzustellen, dass diese drei die gleiche Seite sind,KopfHinzufügenkanonischEtikett.

<link rel="cononical" href="//:ke.qq.com/download/download/app.html" />Roboter

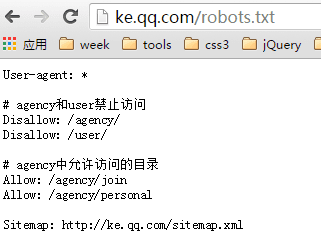

robots.txt

Wenn ein Suchmaschinen-Spider eine Website besucht, besucht er zuerstRoboterDie .txt-Datei robots.txt wird verwendet, um Suchmaschinen-Spider anzuweisen, das Crawlen bestimmter Inhalte der Website zu verbieten oder nur das Crawlen dieser Inhalte zuzulassen, und wird im Stammverzeichnis der Site abgelegt.

Nehmen Sie als Beispiel die robots.txt-Datei von Tencent Classroom:

- Der Benutzeragent gibt an, für welchen Spider die folgenden Regeln gelten.

*Zeigt alle #Kennzeichnet Kommentare- Disallow gibt an, dass das Crawlen von Dateien oder Verzeichnissen verboten ist. Jede Zeile muss separat geschrieben werden.

- „Zulassen“ gibt die Dateien oder Verzeichnisse an, die gecrawlt werden dürfen. Jede Zeile muss separat geschrieben werden.

- Sitemap bedeutet Site-XML-Map. Beachten Sie das große S.

Das Folgende bedeutet, dass allen Suchmaschinen-Spidern das Crawlen von Inhalten untersagt ist

Benutzer-Agent: *

Nicht zulassen: /Das Folgende ermöglicht allen Suchmaschinen-Spidern das Crawlen beliebiger Inhalte

Benutzer-Agent: *

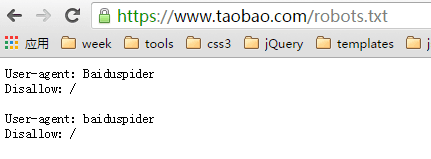

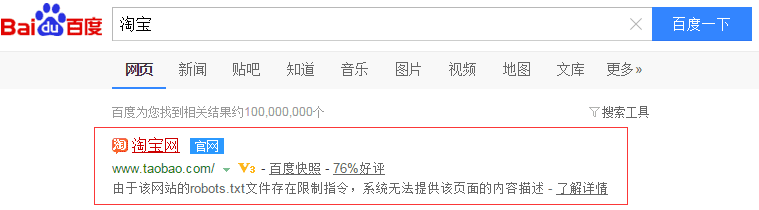

Nicht zulassen:Hinweis: URLs, die nicht von Robots gecrawlt werden dürfen, können dennoch indexiert werden und in den Suchergebnissen erscheinen. Solange ein eingehender Link auf diese URL verweist, erkennt die Suchmaschine deren Existenz. Obwohl der Seiteninhalt nicht gecrawlt wird, verfügt die Indexbibliothek dennoch über Informationen zu dieser URL. Nehmen wir Taobao als Beispiel:

Verbieten Sie das Crawlen der Baidu-Suchmaschine

Baidu-Suchergebnisse

So verwenden Sie robots.txt und seine Details

In China scheinen Website-Administratoren der robots.txt-Datei nicht viel Aufmerksamkeit zu schenken. Auf Wunsch einiger Freunde möchte ich heute in diesem Artikel kurz auf das Schreiben der robots.txt-Datei eingehen.

Grundlegende Einführung in robots.txt

Robots.txt ist eine reine Textdatei, in der Website-Administratoren Teile der Website angeben können, auf die Roboter nicht zugreifen sollen, oder festlegen können, dass Suchmaschinen nur bestimmte Inhalte indizieren.

Wenn ein Suchroboter (manchmal auch Suchspider genannt) eine Website besucht, prüft er zunächst, ob im Stammverzeichnis der Website eine robots.txt-Datei vorhanden ist. Ist dies der Fall, bestimmt der Suchroboter den Zugriffsumfang anhand des Inhalts der Datei. Ist die Datei nicht vorhanden, durchsucht der Suchroboter den Link.

Darüber hinaus muss robots.txt im Stammverzeichnis einer Site abgelegt werden und der Dateiname muss vollständig in Kleinbuchstaben geschrieben sein.

Robots.txt-Schreibsyntax

Schauen wir uns zunächst ein Beispiel für eine robots.txt-Datei an: https://www.example.com/robots.txt

Besuchen Sie die oben angegebene Adresse. Wir können den spezifischen Inhalt von robots.txt wie folgt sehen:

# Robots.txt-Datei von https://www.example.com

# Alle Roboter durchsuchen die Domäne

Benutzeragent: *

Nicht zulassen:

Der obige Text bedeutet, dass alle Suchroboter auf alle Dateien unter der Site https://uzbox.com zugreifen dürfen.

Spezifische Syntaxanalyse: Der Text nach # enthält erklärende Informationen. Auf „User-Agent:“ folgt der Name des Suchroboters. Folgt ein *, bezieht sich dies auf alle Suchroboter. Auf „Disallow:“ folgt das Dateiverzeichnis, auf das kein Zugriff erlaubt ist.

Nachfolgend werde ich einige spezifische Verwendungsmöglichkeiten von robots.txt auflisten:

Allen Robotern den Zugriff erlauben

Benutzeragent: *

Nicht zulassen:

Oder Sie können eine leere Datei "/robots.txt" erstellen

Blockieren Sie den Zugriff aller Suchmaschinen auf Teile der Site

Benutzeragent: *

Nicht zulassen: /

Blockieren Sie den Zugriff aller Suchmaschinen auf bestimmte Bereiche der Site (Verzeichnisse 01, 02 und 03 im folgenden Beispiel).

Benutzeragent: *

Nicht zulassen: /01/

Nicht zulassen: /02/

Nicht zulassen: /03/

Blockieren Sie den Zugriff auf eine Suchmaschine (BadBot im Beispiel unten).

Benutzeragent: BadBot

Nicht zulassen: /

Nur Zugriff von einer bestimmten Suchmaschine zulassen (Crawler im Beispiel unten)

Benutzeragent: Crawler

Nicht zulassen:

Benutzeragent: *

Nicht zulassen: /

Darüber hinaus halte ich es für notwendig, dies zu erweitern und Robots-Meta einzuführen:

Der Robots-META-Tag dient hauptsächlich der Analyse bestimmter Seiten. Wie andere META-Tags (z. B. verwendete Sprache, Seitenbeschreibung, Schlüsselwörter usw.) wird auch der Robots-META-Tag im <head> </head> der Seite platziert und dient insbesondere dazu, Suchmaschinen mitzuteilen, wie Robots den Inhalt der Seite crawlen.

So schreiben Sie den Robots-META-Tag:

Im Robots-META-Tag gibt es keine Groß-/Kleinschreibung. name="Robots" steht für alle Suchmaschinen und kann für eine bestimmte Suchmaschine als name="BaiduSpider" geschrieben werden. InhaltIn diesem Abschnitt gibt es vier Befehlsoptionen: index, noindex, follow, nofollow. Die Befehle sind durch "," getrennt.

Die INDEX-Direktive weist den Suchroboter an, die Seite zu crawlen.

Die FOLLOW-Anweisung gibt an, dass der Suchroboter weiterhin die Links auf der Seite durchsuchen kann.

Die Standardwerte für das Robots-Meta-Tag sind INDEX und FOLLOW, mit Ausnahme von inktomi, bei dem der Standardwert INDEX, NOFOLLOW ist.

Somit gibt es vier Kombinationen:

<META NAME="ROBOTS" CONTENT="INDEX,FOLLOW">

<META NAME="ROBOTS" CONTENT="NOINDEX,FOLLOW">

<META NAME="ROBOTS" CONTENT="INDEX,NOFOLLOW">

<META NAME="ROBOTS" CONTENT="NOINDEX,NOFOLLOW">

In

<META NAME="ROBOTS" CONTENT="INDEX,FOLLOW"> kann geschrieben werden als <META NAME="ROBOTS" CONTENT="ALL">;

<META NAME="ROBOTS" CONTENT="NOINDEX,NOFOLLOW"> kann geschrieben werden als <META NAME="ROBOTS" CONTENT="NONE">

Derzeit scheinen die meisten Suchmaschinen-Robots die Regeln der robots.txt einzuhalten. Was das Robots-META-Tag betrifft, gibt es zwar noch nicht viele, die es unterstützen, aber die Zahl nimmt stetig zu. Beispielsweise unterstützt die bekannte Suchmaschine GOOGLE es vollständig und hat zudem eine Richtlinie hinzugefügt:Archiv" können Sie einschränken, ob GOOGLE Schnappschüsse von Webseiten speichert. Beispiel:

<META NAME="googlebot" CONTENT="index,follow,noarchive">

Dies bedeutet, dass die Seiten der Site gecrawlt und den Links auf den Seiten gefolgt werden, jedoch kein Snapshot der Seite auf Google gespeichert wird.

So verwenden Sie robots.txt

Die robots.txt-Datei schränkt Suchmaschinen-Robots (sogenannte Bots) ein, die das Web crawlen. Diese Bots sind automatisiert und prüfen vor dem Besuch einer Webseite, ob eine robots.txt-Datei vorhanden ist, die sie am Aufruf einer bestimmten Seite hindert. Wenn Sie bestimmte Inhalte Ihrer Website vor Suchmaschinen schützen möchten, ist robots.txt ein einfaches und effektives Tool. Hier finden Sie eine Kurzanleitung zur Verwendung.

So platzieren Sie eine Robots.txt-Datei

Die robots.txt-Datei selbst ist eine Textdatei. Sie muss sich im Stammverzeichnis der Domain befinden und den Namen „robots.txt“ tragen. Eine robots.txt-Datei in einem Unterverzeichnis funktioniert nicht, da Robots nur im Stammverzeichnis der Domain nach dieser Datei suchen. Beispielsweise ist http://www.example.com/robots.txt ein gültiger Speicherort, http://www.example.com/mysite/robots.txt jedoch nicht.

Hier ist ein Beispiel für robots.txt:

Benutzeragent: *

Nicht zulassen: /cgi-bin/

Nicht zulassen: /tmp/

Nicht zulassen: /~name/

Verwenden Sie robots.txt-Dateien, um ganze Websites zu blockieren oder zu entfernen

Um Ihre Site aus den Suchmaschinen zu entfernen und zu verhindern, dass Robots Ihre Site in Zukunft crawlen, platzieren Sie die folgende robots.txt-Datei im Stammverzeichnis Ihres Servers:

Benutzeragent: *

Nicht zulassen: /

Um nur Ihre Site aus Google zu entfernen und zu verhindern, dass in Zukunft nur Googlebot Ihre Site crawlt, platzieren Sie die folgende robots.txt-Datei im Stammverzeichnis Ihres Servers:

Benutzeragent: Googlebot

Nicht zulassen: /

Jeder Port sollte eine eigene robots.txt-Datei haben. Insbesondere wenn Sie Inhalte über HTTP und HTTPS hosten, benötigt jedes Protokoll eine eigene robots.txt-Datei. Um beispielsweise alle HTTP-Seiten, nicht aber alle HTTP-Seiten, vom Googlebot indexieren zu lassen, verwenden Sie die folgende robots.txt-Datei.

Für das HTTP-Protokoll (http://www.example.com/robots.txt):

Benutzeragent: *

Erlauben: /

Für das https-Protokoll (https://www.example.com/robots.txt):

Benutzeragent: *

Nicht zulassen: /

Erlauben Sie allen Robotern den Zugriff auf Ihre Seiten

Benutzeragent: *

Nicht zulassen:

(Alternative Methode: Erstellen Sie eine leere Datei „/robots.txt“ oder verwenden Sie robots.txt nicht.)

Blockieren oder Entfernen von Seiten mithilfe einer robots.txt-Datei

Mit einer robots.txt-Datei können Sie verhindern, dass der Googlebot Seiten Ihrer Website crawlt. Wenn Sie beispielsweise manuell eine robots.txt-Datei erstellen, um den Googlebot daran zu hindern, alle Seiten in einem bestimmten Verzeichnis (z. B. „privat“) zu crawlen, können Sie den folgenden robots.txt-Eintrag verwenden:

Benutzeragent: Googlebot

Nicht zulassen: /privat

Um zu verhindern, dass der Googlebot alle Dateien eines bestimmten Dateityps (z. B. .gif) crawlt, verwenden Sie den folgenden robots.txt-Eintrag:

Benutzeragent: Googlebot

Nicht zulassen: /*.gif$

Um zu verhindern, dass Googlebot alle URLs crawlt, die ein ? enthalten (insbesondere URLs, die mit Ihrem Domänennamen beginnen, gefolgt von einer beliebigen Zeichenfolge, gefolgt von einem Fragezeichen, gefolgt von einer weiteren beliebigen Zeichenfolge), verwenden Sie den folgenden Eintrag:

Benutzeragent: Googlebot

Nicht zulassen: /*?

Obwohl wir den Inhalt von Seiten, die durch robots.txt blockiert sind, weder crawlen noch indexieren, können wir die URLs dennoch crawlen und indexieren, wenn wir sie an anderer Stelle im Web finden. Infolgedessen können die Seiten-URL und andere öffentlich verfügbare Informationen, wie z. B. Ankertexte in Links, die auf die Website verweisen, in den Google-Suchergebnissen erscheinen. Der Inhalt Ihrer Seite wird jedoch nicht gecrawlt, indexiert oder angezeigt.

Google bietet in den Webmaster-Tools ein Robots.txt-Analysetool an. Es kann die Robots.txt-Datei auf die gleiche Weise lesen wie der Googlebot und Ergebnisse für Google-User-Agents (wie den Googlebot) bereitstellen. Wir empfehlen Ihnen dringend, dieses Tool zu verwenden. Bevor Sie eine Robots.txt-Datei erstellen, sollten Sie überlegen, welche Inhalte von Nutzern durchsucht werden können und welche nicht. So können Suchmaschinen durch die richtige Verwendung der Robots.txt-Datei Nutzer auf Ihre Website leiten und gleichzeitig sicherstellen, dass keine privaten Informationen enthalten sind.

Mythos 1: Alle Dateien meiner Website müssen von Suchspidern gecrawlt werden, daher ist es nicht notwendig, eine robots.txt-Datei hinzuzufügen. Ohne diese Datei können alle Suchspider auf alle Seiten der Website zugreifen, die standardmäßig nicht passwortgeschützt sind.

Versucht ein Nutzer, auf eine nicht existierende URL zuzugreifen, meldet der Server einen 404-Fehler (Datei nicht gefunden). Auch der Such-Spider, eine nicht existierende robots.txt-Datei zu finden, meldet einen 404-Fehler. Fügen Sie Ihrer Website daher eine robots.txt-Datei hinzu.

Irrtum 2: Wenn Sie alle Dateien in der robots.txt-Datei so einstellen, dass sie von Such-Spidern gecrawlt werden, kann dies die Aufnahmerate der Website erhöhen.

Selbst wenn Programmskripte, Stylesheets und andere Dateien der Website von Spidern eingebunden werden, erhöht dies nicht die Einbindungsrate der Website, sondern verschwendet lediglich Serverressourcen. Daher ist es notwendig, in der Datei robots.txt festzulegen, dass diese Dateien von Suchspidern nicht indexiert werden.

Die konkreten Dateien, die ausgeschlossen werden müssen, werden im Artikel „Tipps zur Verwendung von robots.txt“ ausführlich vorgestellt.

Mythos 3: Such-Spider verschwenden zu viele Serverressourcen beim Crawlen von Webseiten. Die robots.txt-Datei verhindert, dass Such-Spider alle Webseiten crawlen.

In diesem Fall wird die gesamte Website nicht von den Suchmaschinen indiziert.

Tipps zur Verwendung von robots.txt

1. Jedes Mal, wenn ein Benutzer versucht, auf eine nicht existierende URL zuzugreifen, meldet der Server einen 404-Fehler (Datei nicht gefunden). Jedes Mal, wenn ein Such-Spider nach einer nicht existierenden robots.txt-Datei sucht, meldet der Server ebenfalls einen 404-Fehler. Fügen Sie Ihrer Website daher eine robots.txt-Datei hinzu.

2. Webmaster müssen Spider-Programme von bestimmten Serververzeichnissen fernhalten, um die Serverleistung sicherzustellen. Beispielsweise speichern die meisten Webserver Programme im Verzeichnis „cgi-bin“. Daher empfiehlt es sich, „Disallow: /cgi-bin“ in die robots.txt-Datei einzufügen, um die Indexierung aller Programmdateien durch Spider zu verhindern und so Serverressourcen zu sparen. Zu den Dateien, die auf allgemeinen Websites nicht von Spidern gecrawlt werden müssen, gehören: Hintergrundverwaltungsdateien, Programmskripte, Anhänge, Datenbankdateien, Kodierungsdateien, Stylesheet-Dateien, Vorlagendateien, Navigationsbilder, Hintergrundbilder usw.

Unten ist die robots.txt-Datei in VeryCMS:

Benutzeragent: *

Nicht zulassen: /admin/ Backend-Verwaltungsdateien

Nicht zulassen: /require/ Programmdateien

Nicht zulassen: /Anhang/

Nicht zulassen: /images/ Bilder

Nicht zulassen: /data/ Datenbankdateien

Nicht zulassen: /template/ Vorlagendateien

Nicht zulassen: /css/ Stylesheet-Dateien

Nicht zulassen: /lang/-codierte Dateien

Nicht zulassen: /script/-Skriptdateien

3. Wenn Ihre Website dynamische Seiten hat und Sie statische Kopien dieser dynamischen Seiten erstellt haben, um das Crawlen durch Suchspider zu erleichtern, müssen Sie dies in der Datei robots.txt festlegen, um zu verhindern, dass dynamische Seiten von Spidern indiziert werden, um sicherzustellen, dass diese Seiten nicht als Seiten mit doppeltem Inhalt angesehen werden.

4. Die robots.txt-Datei kann auch direkt einen Link zur Sitemap-Datei enthalten. So geht's:

Sitemap: sitemap.xml

Zu den Suchmaschinenunternehmen, die ihre Unterstützung hierfür zum Ausdruck gebracht haben, gehören Google, Yahoo, Ask und MSN. Chinesische Suchmaschinenunternehmen gehören offensichtlich nicht dazu. Der Vorteil besteht darin, dass Webmaster ihre Sitemap-Dateien nicht bei den Webmaster-Tools oder ähnlichen Webmaster-Bereichen der einzelnen Suchmaschinen einreichen müssen. Die Spider der Suchmaschine crawlen die robots.txt-Datei, lesen den darin enthaltenen Sitemap-Pfad und crawlen dann die verlinkten Webseiten.

5. Die korrekte Verwendung von robots.txt-Dateien kann auch Fehler beim Zugriff vermeiden. Beispielsweise dürfen Suchende nicht direkt auf die Warenkorbseite zugreifen. Da es keinen Grund für die Einbindung des Warenkorbs gibt, können Sie dies in der robots.txt-Datei festlegen, um zu verhindern, dass Suchende direkt auf die Warenkorbseite gelangen.

Meta-Roboter

Wenn Sie möchten, dass die URL überhaupt nicht in den Suchergebnissen erscheint, müssen Sie Meta-Robots einrichten

<meta name="robots" content="onindex,nofollow">Der obige Code bedeutet: Allen Suchmaschinen ist es untersagt, diese Seite zu indizieren und die Links auf dieser Seite zu verfolgen.

Natürlich gibt es auch andere Inhaltstypen, aber jeder Browser unterstützt unterschiedliche Typen, daher werden sie hier ignoriert.

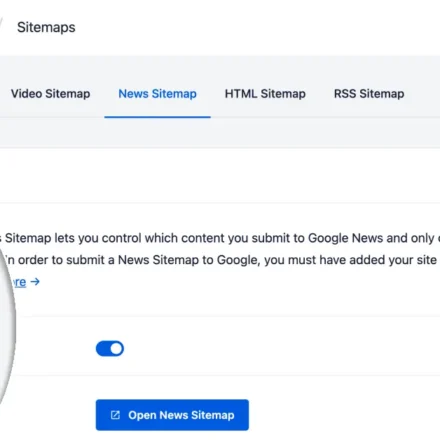

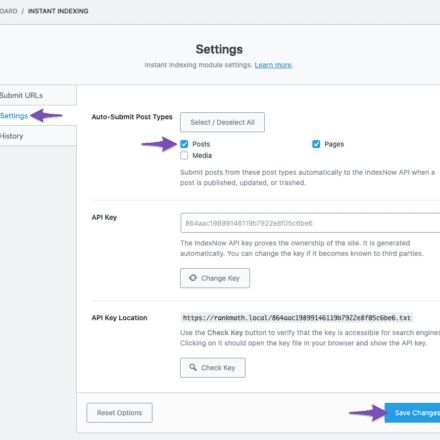

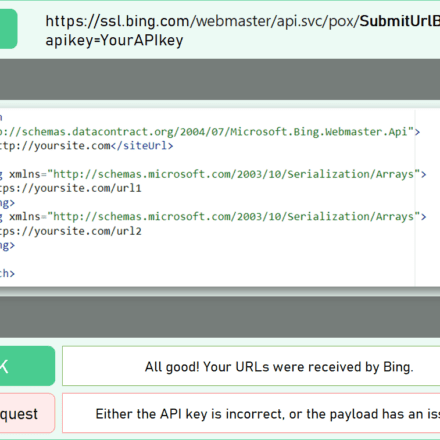

Sitemap

Es gibt zwei Formate für Sitemaps: HTML und XML.

Die HTML-Version ist eine normale HTML-Seitesitemap.htmlkönnen Benutzer direkt auf alle wichtigen Links der Site zugreifen und diese auflisten. Es wird empfohlen, nicht mehr als 100 Links aufzulisten.

Die XML-Version der Sitemap wurde 2005 von Google vorgeschlagen und besteht aus XML-Tags, kodiert alsutf-8listet alle URLs der Seite auf. Das Format ist wie folgt:

<?XML-Version="1.0" Codierung="UTF-8"?>

<URL-Satz XMLNs="http://www.sitemaps.org/schemas/sitemap/0.9">

<URL>

<Ort>//ke.qq.com

<letztermod>2015-12-28</letztermod>

<Änderungsfrequenz>stets</Änderungsfrequenz>

<Priorität>1.0</Priorität>

</URL>

...

</URL-Satz>InURL-Satz,URL,OrtDrei davon sind erforderliche Tags.letztermod,Änderungsfrequenz,PrioritätIst ein optionales Tag.

letztermodGibt den Zeitpunkt der letzten Aktualisierung der Seite an.

ÄnderungsfrequenzGibt die Häufigkeit der Dateiaktualisierung an. Folgende Werte sind verfügbar: immer, stündlich, täglich, wöchentlich, monatlich, jährlich und nie. „Immer“ bedeutet, dass sich der Seiteninhalt ständig ändert und bei jedem Seitenaufruf anders aussieht. „Nie“ bedeutet, dass er sich nie ändert.

PrioritätGibt die relative Wichtigkeit der URL an, der Wertebereich ist0.0-1.0,1.0Zeigt die wichtigsten, in der Regel auf der Homepage der Website verwendet, entsprechende0.0Die Standardwichtigkeit ist0.5(Beachten Sie, dass die Wichtigkeit hier das ist, was wir markiert haben. Das bedeutet nicht, dass die Suchmaschine wirklich entsprechend der von uns festgelegten Wichtigkeit rankt.)

sitemap.xmlDie Größe der Sitemap-Datei sollte 10 MB nicht überschreiten, und die Anzahl der URLs in jeder Sitemap-Datei sollte 50.000 nicht überschreiten. Wenn Ihre Sitemap-Datei sehr groß ist, können Sie sie in mehrere Dateien aufteilen. Wie unten gezeigt, gibt es zwei Dateien: eine für die Basisseite und eine für die Produktdetailseite.

<Sitemapindex XMLNS="http://www.sitemaps.org/schemas/sitemap/0.9">

<Sitemap><Ort>//ke.qq.com/sitemap-basic.xml28.12.2015, 02:10 Uhr

<Sitemap><Ort>//ke.qq.com/sitemap-product.xml28.12.2015, 02:10 Uhr

</Sitemapindex>SEO-Tools

- Baidu-Suchranking

- Baidu-Index

- Baidu Webmaster-Plattform

- Meta-SEO-Inspektor, Check-Tag, Google-Plugin

- SEO in China, verschiedene von Baidu gesammelte Daten, Google-Plugin

- prüfe meine Links, prüfe Links, Google-Plugin

- seo quake, Statistiken verschiedener Daten, Google-Plugin

Schließlich bezieht sich dieser Artikel aufBaidu SEO-Leitfaden 2.0 Und Zacs Buch „SEO Practical Code“ (Studenten, die sich für SEO interessieren, können ein Exemplar kaufen und es lesen).