優れたソフトウェアと実用的なチュートリアル

どうやってAIスクレイピングボットの阻止コンテンツクリエイターでもブロガーでも、あなたはユニークで高品質なコンテンツを作成することで生計を立てています。OpenAIやCCBotのような生成AIプラットフォームが、あなたの同意なしにあなたのコンテンツを使ってアルゴリズムを学習していることに気づいたことはありませんか?ご心配なく! ロボット.txt ファイルは、これらの AI クローラーが Web サイトやブログにアクセスするのをブロックします。

robots.txt ファイルとは何ですか?

robots.txt は、ロボット(検索エンジンロボットなど)にウェブサイトのページをクロールおよびインデックスする方法を指示するテキストファイルです。robots.txt ファイルに従って、良質なロボットと悪質なロボットをブロック/許可できます。ユーザーエージェントを使用して単一のロボットをブロックする構文は次のとおりです。

ユーザーエージェント: {BOT-NAME-HERE} 禁止: /

ユーザーエージェントを使用して特定のロボットがサイトをクロールできるようにする方法は次のとおりです。

ユーザーエージェント: {BOT-NAME-HERE} 許可: /

robots.txt ファイルをどこに配置すればよいですか?

ファイルをウェブサイトのルートフォルダにアップロードします。URLは次のようになります。

https://example.com/robots.txt https://blog.example.com/robots.txt

詳細については、robots.txt に関する次のリソースを参照してください。

- Googleからrobots.txt の紹介。

- robots.txtとは? | robots.txtファイルの作成方法Cloudflareで仕事。

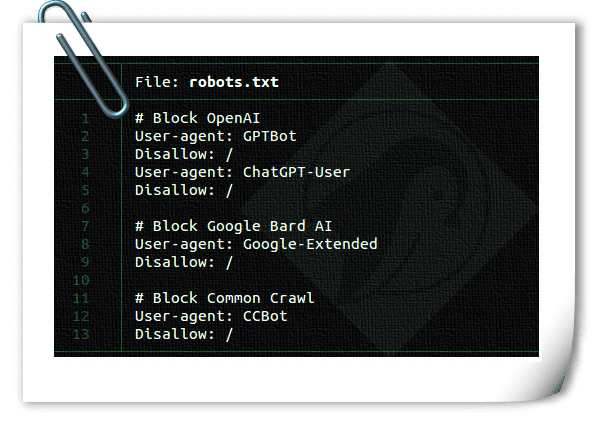

robots.txtファイルを使ってAIクローラーをブロックする方法

構文は同じです:

ユーザーエージェント: {AI-Ccrawlers-Bot-Name-Here} 禁止: /

robots.txt ファイルを使用して OpenAI をブロックする

robots.txt に次の 4 行を追加します。

ユーザーエージェント: GPTBot 禁止: / ユーザーエージェント: ChatGPT-User 禁止: /

OpenAIには、ウェブクロール用とブラウジング用の2つのユーザーエージェントがあり、それぞれに独自のCIDRとIP範囲が割り当てられています。下記のファイアウォールルールを設定するには、ネットワークの概念とLinuxのルートレベルアクセスに関する十分な知識が必要です。これらのスキルが不足している場合は、Linuxシステム管理者に依頼して、常に変化するIPアドレス範囲からのアクセスを防ぐことを検討してください。これは、いたちごっこのような状況になる可能性があります。

1:ChatGPTユーザーChatGPTによるプラグイン使用

OpenAI クローラーとフェッチャーで使用されるユーザー エージェントのリストは次のとおりです。CIDRまたはIPアドレス範囲を含む、Webサーバーのファイアウォールで使用できるプラグインAIボットをブロックするための設定。Webサーバーでufwコマンドまたはiptablesコマンドを使用してブロックできます。23.98.142.176/28 .たとえば、UFW を使用して CIDR または IP 範囲をブロックするファイアウォール ルールは次のとおりです。

sudo ufw deny proto tcp 23.98.142.176/28 から任意のポート 80 への接続を拒否 sudo ufw deny proto tcp 23.98.142.176/28 から任意のポート 443 への接続を拒否

2:GPTボットChatGPTで使用

OpenAI クローラーおよびフェッチャーで使用されるユーザー エージェントは次のとおりです。リスト(含む)CIDRあるいは、WebサーバーのファイアウォールでAIボットをブロックするためのIPアドレス範囲も設定できます。これらの範囲も、ufwコマンドまたはiptablesコマンドを使用してブロックできます。これらのCIDR範囲をブロックするシェルスクリプトを以下に示します。

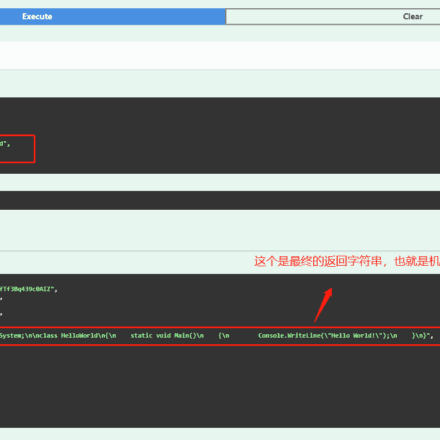

#!/bin/bash # 目的: OpenAI ChatGPT ボット CIDR をブロック # テスト環境: Debian および Ubuntu Linux # 作成者: Vivek Gite {https://www.cyberciti.biz} GPL v2.x+ に基づく # ------------------------------------------------------------------ file="/tmp/out.txt.$$" wget -q -O "$file" https://openai.com/gptbot-ranges.txt 2>/dev/null while IFS= read -r cidr do sudo ufw deny proto tcp from $cidr to any port 80 sudo ufw deny proto tcp from $cidr to any port 443 done < "$ファイル" [ -f "$ファイル" ] && rm -f "$ファイル"

Google AI(Bard および Vertex AI 生成 API)をブロックする

robots.txt に次の 2 行を追加します。

ユーザーエージェント: Google 拡張 禁止: /

詳細については、Google のクローラとエクストラクタが使用するユーザーエージェントのリストをご覧ください。ただし、Google は、ウェブサーバーのファイアウォールで AI ボットをブロックするための CIDR、IP アドレス範囲、または自律システム情報(ASN)を提供していません。

robots.txt ファイルを使用して commoncrawl (CCBot) をブロックする

robots.txt に次の 2 行を追加します。

ユーザーエージェント: CCBot 許可しない: /

コモンクロールは非営利団体ですが、各社はCCbotと呼ばれるボットを通じてAIを学習させるためにデータを使用しています。これらをブロックすることも重要です。しかし、Googleと同様に、WebサーバーのファイアウォールでAIボットをブロックするためのCIDR、IPアドレス範囲、自律システム情報(ASN)は提供されていません。

robots.txt ファイルを使用して Perplexity AI をブロックする

生成型人工知能(GAI)を用いて、あなたのコンテンツをすべて取得し、書き換えるサービスです。以下の手順でブロックできます。

ユーザーエージェント: PerplexityBot 許可しない: /

彼らはまた、IPアドレス範囲WAF または Web サーバー ファイアウォールを使用してブロックできます。

AI ボットは robots.txt ファイルを無視できますか?

GoogleやOpenAIのような有名企業は通常、robots.txtプロトコルに準拠しています。しかし、設計が不十分なAIボットの中には、robots.txtを無視するものもあります。

AWS または Cloudflare WAF テクノロジーを使用して AI ボットをブロックできますか?

Cloudflareは最近発表したCloudflareは、AIボットをブロックする新しいファイアウォールルールを導入しました。ただし、検索エンジンやその他のボットは、WAFルールを介して引き続きウェブサイトやブログを利用できます。WAF製品を使用するには、ボットの動作を十分に理解する必要があり、慎重に導入する必要があることを覚えておくことが重要です。そうしないと、他のユーザーもブロックされてしまう可能性があります。Cloudflare WAFでAIボットをブロックする方法は次のとおりです。

なお、私はCloudflareソリューションを評価中ですが、初期テストでは少なくとも3.31%のユーザーがブロックされていることがわかりました。3.31%とは、CSR(Challenge Resolution Rate:チャレンジ解決率)率、つまりCloudflareが提供するCAPTCHAを解読したユーザーの数です。これは高いCSR率です。さらにテストを行う必要があります。Cloudflareを使い始めたら、このブログ記事を更新します。

GitHub やその他のクラウド ホスティング サイトでホストされているコードやドキュメントへのアクセスをブロックできますか?

いいえ、それが可能かどうかは分かりません。

Microsoftの製品であり、OpenAIの最大の投資家でもあるGitHubの使用には懸念があります。利用規約の更新やその他の抜け穴を利用して、あなたのデータがAIの学習に利用される可能性があります。データやコードが学習に利用されるのを防ぐには、会社または個人でgitサーバーを独自にホストするのが最善です。Appleなどの大企業は、ChatGPTなどの製品の社内利用を禁止しています。これは、コードや機密データの漏洩につながる懸念があるためです。

AI が人類の利益のために使用される場合、AI ロボットがトレーニング データを取得するのを妨げることは倫理的でしょうか?

OpenAI、Google Bard、Microsoft Bing、その他あらゆるAIを人類の利益のために使うことには懐疑的です。生成型AIがホワイトカラーの仕事を代替する一方で、金儲けをするための策略にしか思えません。しかし、私のデータががん治療(あるいはそれに類するもの)にどのように活用できるかについて何か情報をお持ちでしたら、ぜひコメント欄で共有してください。

私の個人的な意見としては、OpenAI/Google/Bing AI、あるいはいかなるAIからも今のところ恩恵を受けていません。20年以上も懸命に働いてきたので、これらの巨大テクノロジー企業による直接的な利益追求から自分の仕事を守る必要があります。皆さんは私の意見に賛同する必要はありません。コードやその他の情報をAIに渡すことは可能です。ただし、これはあくまで任意であることを忘れないでください。現在、AIがrobots.txtによる制御を提供しているのは、複数の書籍著者や企業が訴訟を起こしているためです。これらの問題に加えて、AIツールはスパムサイトや電子書籍の作成にも利用されています。参考文献については以下をご覧ください。

- サラ・シルバーマンがOpenAIとMetaを提訴

- AI画像作成者が英国と米国で法的課題に直面

- Stack OverflowはChatGPTの犠牲者となった:3月のトラフィックは14%減少

- 著者はChatGPTを使ってKindle本にスパムを送る

- ChatGPT、プライバシーの懸念からイタリアで禁止

- AIスパムはすでにインターネット上に広がっており、その明らかな兆候がある。

- 専門家はAIが絶滅につながる可能性があると警告

- 人工知能はスパムウェブサイト全体を生成するために使用されている

- 同社は人間の従業員を廃止し、ChatGPTスタイルの人工知能を導入する予定だ

- ChatGPTやその他のAIが賢く聞こえる秘密のウェブサイトリスト

AI がすでにあなたのデータの多くを使用しているのは事実ですが、将来あなたが作成するあらゆるものはこれらのテクノロジーによって保護される可能性があります。

まとめ

生成AIの普及に伴い、コンテンツクリエイターはAI企業がモデルの学習に無断でデータを使用していることに疑問を呈し始めています。企業は、何百万もの小規模な独立系クリエイターが作成したコード、テキスト、画像、動画から利益を得ている一方で、彼らの収入源を奪っています。異論を唱えない人もいるかもしれませんが、このような突然の措置は多くの人々に壊滅的な打撃を与えることは承知しています。そのため、ウェブサイト運営者やコンテンツクリエイターは、不要なAIクローラーを簡単にブロックできる必要があります。そのプロセスはシンプルであるべきです。

robots.txt や Cloudflare などのサードパーティが提供するクラウド ソリューションを使用することで、さらに多くのボットをブロックできるようになるため、このページを更新します。

ボットをブロックする他のオープンソースプロジェクト

- Nginx の不正ボットとユーザーエージェントブロッカー

- フェイル 2 バン/var/log/auth.log などのログ ファイルをスキャンし、ログイン試行の失敗回数が多すぎる IP アドレスを禁止します。