優れたソフトウェアと実用的なチュートリアル

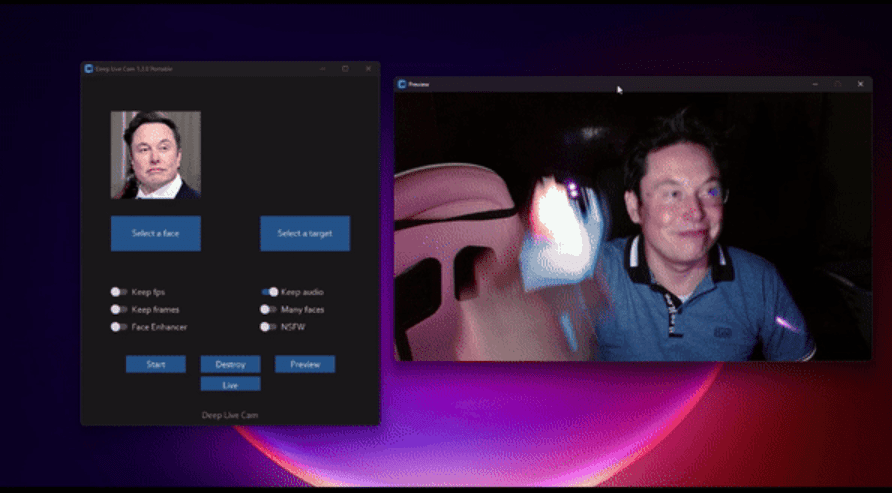

AIによる顔を変えるライブ放送ツール

警告:このツールを違法行為に使用しないでください。これにより生じるいかなる結果についても、ご自身の責任となります。

Deep Live Camは、写真や動画の顔を、指定した写真の顔に簡単に置き換えることができる顔変換ツールです。CPU/GPU/Mac環境で実行できます。Deep Live Camは、AIによるリアルタイム顔変換ツールで、ビデオ通話やライブブロードキャストでユーザーの顔を瞬時に置き換えることができます。この技術は、高度なディープラーニングアルゴリズムと顔認識技術を駆使し、リアルなリアルタイム「ディープフェイク」効果を生成し、ユーザーがビデオ通話で別人になりすますことを可能にします。

このツールはオープンソースであることから、広く利用され、議論されてきました。バーチャルキャラクターやメディア制作といった特定のクリエイティブなシナリオでは正当な用途がある一方で、個人情報の盗難や詐欺といった潜在的なリスクに関して、プライバシーや倫理上の問題も生じています。悪用を防ぐため、開発者はユーザーのプライバシーを保護するためのコンテンツレビューメカニズムの導入に取り組んできました。

ディープライブカメラAIの核心的な価値は、その幅広い応用シナリオにあります。アーティストはAIを活用してカスタムキャラクターにアニメーション効果を加えたり、キャラクターを衣装デザインのモデルとして利用したりできます。さらに、映画やテレビのポストプロダクション、バーチャルキャスター、教育プレゼンテーションなどの分野にも応用でき、コンテンツ制作の可能性を大きく広げます。

ディープライブカメラAIの核心的な価値は、その幅広い応用シナリオにあります。アーティストはAIを活用してカスタムキャラクターにアニメーション効果を加えたり、キャラクターを衣装デザインのモデルとして利用したりできます。さらに、映画やテレビのポストプロダクション、バーチャルキャスター、教育プレゼンテーションなどの分野にも応用でき、コンテンツ制作の可能性を大きく広げます。

GitHub プロジェクトページ:https://github.com/hacksider/Deep-Live-Cam

ディープライブカム無料申請

このソフトウェアは、AIメディア業界に有益な貢献をすることを目的としています。カスタムキャラクターのアニメーション化や衣装モデルとしての使用といったタスクにおいて、アーティストを支援するように設計されています。

非倫理的なアプリケーションの潜在的なリスクを認識しており、予防措置を講じることに尽力しています。プログラムに組み込まれたチェック機能により、不適切なメディア(ヌード、グラフィックコンテンツ、戦争映像などのセンシティブな素材など)が処理されるのを防ぎます。法的および倫理的基準を遵守し、責任を持ってプロジェクトの開発を継続します。法律で義務付けられている場合、プロジェクトを中止したり、透かしを追加したりする場合があります。

ユーザーは責任を持って、合法的に本ソフトウェアを使用する必要があります。実在の人物の顔を使用する場合は、本人の同意を得てください。また、オンラインで共有する際には、出力結果にディープフェイクであることを明記してください。当社はエンドユーザーの行為について一切責任を負いません。

インストール前の準備

NカードCUDAがインストールされている必要があります

ダウンロードアドレス:https://developer.nvidia.com/cuda-downloads/

AMDグラフィックカードAMD HIP SDKがインストールされている必要があります

ダウンロード

- https://pan.quark.cn/s/f5f86d769394

- https://drive.uc.cn/s/eab589fe1a1d4

- https://pan.baidu.com/s/1c65OrFR18AuHOvTH56Yu7Q?pwd=6666

Microsoft 共通ランタイムライブラリコレクション 2024.08.14

- https://pan.quark.cn/s/e4bcf05899c9

- https://pan.baidu.com/share/init?surl=hlSdsPD-H1FgD2IFanLJWA&pwd=6666

ランタイム ライブラリもインストールできます。ゲームソフトウェアランタイムコレクション(2024.10.01)統合ゲーム拡張ランタイム

ディープライブカメラの設置

Windows マシンに Nvidia グラフィック カードがインストールされている場合は、直接ダウンロードして、ダウンロード後すぐに使用できます。

ダウンロードして解凍し、実行するだけです。このバージョンは自己解凍形式のアーカイブとして提供されるため、複雑なインストール手順は不要です。

主な特徴

- 簡単なセットアップ: 面倒なインストール手順は不要です。ダウンロードして解凍し、すぐに実行するだけです。

- 最適化されたパフォーマンス: 互換性のある NVIDIA GPU でスムーズなリアルタイム効果を体験できます。

- ユーザーフレンドリーなインターフェース: 直感的なデザインにより、あらゆるスキルレベルのユーザーが簡単に使用できます。

システム要件

NVIDIA GPU: 6GB 以上のビデオ メモリが必要 (最高のパフォーマンスを得るには新しいモデルを推奨します)。

CUDA ツールキット 11.8。

オペレーティング システム: Windows 10 または Windows 11。

メモリ: 16 GB 推奨。

注: このバージョンは GitHub のバージョンと同じ機能を備えていますが、より簡素化されたユーザー エクスペリエンスを提供します。

Deep Live Cam統合パッケージをダウンロード

パッケージ版をダウンロードしてください。NカードとAカードの両方に対応した統合パッケージを用意しています。グラフィックカードのビデオメモリが8GB未満の場合は、ダウンロードしないでください。

https://pan.quark.cn/s/bad0d6cd6f0d

統合パッケージをダウンロードしてインストールする

以下はCPUインストールとGPUインストールをサポートするインストール統合パッケージです。

ファイルパッケージのサイズは6.46GBです。パッケージには、Pythonとその依存パッケージ、ffmpeg、vsc環境のインストールスクリプトが既に含まれています。

https://pan.baidu.com/s/1OzvIzV80rDMZALzUGazHpA?pwd=iaim

CPU を実行するか GPU を実行するかに応じて、対応する .bat スタートアップ ファイルをダブルクリックします。

起動すると、アプリケーションインターフェースがポップアップ表示されます。左側で真似したい顔の写真を選択し、右側で変換したい写真を選択して、「開始」(写真を変換)をクリックするか、右側で写真をアップロードせずに直接「ライブ」をクリックします。リアルタイムの顔交換。

Deep Live Camの手動インストール

Deep-Live-Cam を手動でインストールする場合、CPU を使用すると少し遅くなる可能性があるので、GPU バージョンを使用することをお勧めします。

Deep-Live-Camのインストールは比較的簡単ですが、Python 3.10、pip、git、ffmpegなどの特定のコンピュータ環境設定が必要です。GitHubリポジトリのクローンを作成し、モデルファイルをダウンロードして配置し、依存関係をインストールするだけでインストールが完了します。このソフトウェアは、CPU、CUDA(Nvidia GPU)、CoreML(Apple Silicon)、DirectML(Windows)、OpenVINO(Intel)など、複数の実行プロバイダをサポートしています。ユーザーは、自身のハードウェア状況に応じて適切な実行ソリューションを選択できます。

前提条件

- パイソン(3.10を推奨)

- ピップ

- ギット

- ffmpeg

- Visual Studio 2022 ランタイム (Windows)

Visual Studio 2022 ランタイム (Windows) Visual Studio 2022 の Visual C++ 再頒布可能パッケージで必要なバージョンを選択してください

https://learn.microsoft.com/en-us/cpp/windows/latest-supported-vc-redist

64 ビット版のインストール パッケージをここから直接ダウンロードしてください: https://aka.ms/vs/17/release/vc_redist.x64.exe

Visual Studio 2022 Professional Edition のインストールチュートリアル

インターネットは科学的に利用する必要があります。PyTorchのダウンロードが遅い、または利用できない場合は、別のプロキシノードを試してもう一度お試しください。

手動インストール手順

手動インストールは、細かい作業を好む上級者向けです。初心者の方は、パッケージ版を直接使用することをお勧めします。

Gitを使用してDeep-Live-Camプロジェクトをクローンする

GitHub リポジトリのクローンを作成すると、Deep-Live-Cam プロジェクトのコードがローカル コンピューターにダウンロードされます。

git クローン https://github.com/hacksider/Deep-Live-Cam.git

プロジェクトディレクトリを入力して、そのディレクトリ内で後続のコマンドを実行できるようにします。

cd ディープライブカメラ

依存関係をインストールする

新しい Conda 環境 deeplivecam を作成し、Python バージョン 3.10 を指定して、プロジェクトの依存関係を分離します。

conda create -n deeplivecam python=3.10 -y

作成したConda環境をアクティブ化してPythonを実行し、依存関係をインストールします。

conda で deeplivecam を有効化

requirements.txt ファイルにリストされているプロジェクトの依存関係をインストールします。

pip インストール -r 要件.txt

モデルをダウンロードする

2 つのモデルをプロジェクト ルート ディレクトリの /models フォルダーにダウンロードします。ダウンロード リンク:

- inswapper_128_fp16.onnx:https://huggingface.co/hacksider/deep-live-cam/resolve/main/inswapper128fp16.onnx

- 注意: inswapper_128_fp16.onnx で問題が発生した場合は、次の代替バージョンを使用してください。https://github.com/facefusion/facefusion-assets/releases/download/models/inswapper_128_fp16.onnx

- GFPGANv1.4:https://huggingface.co/hacksider/deep-live-cam/resolve/main/GFPGANv1.4.pth

- これらのファイルを「models」フォルダに配置します。

GPUバージョンの使い方

GPUを使用する手順

特定のバージョンを指定する必要があるため、インストールされている onnxruntime と onnxruntime-gpu をアンインストールします。

pip アンインストール onnxruntime onnxruntime-gpu

プロジェクトのCUDAバージョンとの互換性を確保するために、指定されたバージョンのonnxruntime-gpuをインストールします。

onnxruntime-gpu==1.16.3 を pip でインストールします

CUDAを使用してプロジェクトのメインスクリプトrun.pyを実行し、GPUアクセラレーションを使用する

python python run.py --実行プロバイダ cuda

CPUバージョンの使い方

開始するには、次のコマンドを実行するだけです。

Python 実行.py

使用シナリオ

- アンカーフェイススワップ

- プライバシー保護のためのビデオ顔交換