精品軟體與實用教程

Windows 上安裝io.net 連接新裝置的逐步教學

io.net Cloud 是最先進的去中心化運算網絡,讓機器學習工程師以相當集中式服務成本的一小部分存取分散式雲端叢集。

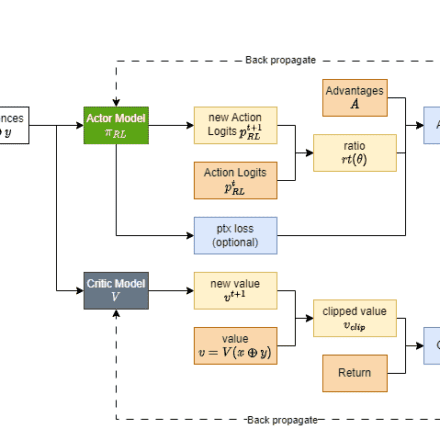

現代機器學習模型經常利用平行和分散式計算。利用跨多個系統的多核心的強大功能來優化效能或擴展到更大的資料集和模型至關重要。訓練和推理過程不僅僅是在單一裝置上運行的簡單任務,而且通常涉及協同工作的GPU 協調網路。

不幸的是,由於公有雲需要更多GPU,取得分散式運算資源面臨一些挑戰。其中最突出的一些是:

- 可用性有限:使用AWS、GCP 或Azure 等雲端服務存取硬體通常需要數週時間,而且流行的GPU 模型通常不可用。

- 糟糕的選擇: 用戶在GPU 硬體、位置、安全等級、延遲和其他選項方面幾乎沒有選擇。

- 高成本:獲得良好的GPU 非常昂貴,專案每月很容易花費數十萬美元用於訓練和推理。

io.net 透過聚合未充分利用的來源(例如獨立資料中心、加密礦工以及Filecoin、Render 等加密項目)的GPU 來解決這個問題。這些資源結合在去中心化實體基礎設施網路(DePIN) 中,使工程師能夠在可存取、可自訂、經濟高效且易於實施的系統中獲得大量運算能力。

io.net 文件:https://developers.io.net/docs/overview

安裝io.net 連接新設備教學

首先前往cloud.io.net 使用Google信箱或X帳號登入io.net

1. 從下拉式選單導覽至WORKER

2. 連接新設備

點擊“連接新裝置”

3. 選擇供應商

選擇您希望將硬體分組到的供應商

4. 為您的裝置命名

為您的裝置新增唯一的名稱,理想格式類似以下內容:My-Test-Device

5. 選擇作業系統“OS”

點擊“Windows”字段

6. 設備類型

如果您選擇GPU Worker 且您的裝置沒有GPU,則設定將會失敗

7. Docker 和Nvidia 驅動程式安裝

請按照我們的Docker、Cuda 和Nvidia 驅動程式安裝文件中的步驟進行操作

8.執行Docker命令

在終端機中運行此命令並確保docker 桌面正在後台運行

9.等待連接

在等待新裝置連線時,請繼續點擊刷新。

Windows 上的Docker 安裝

首先,您需要啟用虛擬化BIOS。

要檢查它是否已啟用,請轉到任務管理器效能,以便您在此處看到:

如果未啟用,請依照下列步驟操作:

- 若要在BIOS 或UEFI 設定中啟用虛擬化技術,您需要在啟動過程中存取電腦的BIOS 或UEFI 設定選單。具體步驟可能會有所不同,具體取決於電腦的製造商和型號,但以下是啟用虛擬化的一般步驟。

- 透過以管理員身分開啟PowerShell 來安裝WSL 2。為此,請在“開始”功能表中搜尋“PowerShell”,右鍵單擊“Windows PowerShell”,然後選擇“以管理員身份執行”。

- 執行以下命令在Windows 10/11 中啟用WSL 功能:

dism.exe /online /enable-feature /featurename:Microsoft-Windows-Subsystem-Linux /all /norestart

- 然後,透過執行以下命令,在同一PowerShell 視窗中啟用虛擬機器平台功能:

dism.exe /online /enable-feature /featurename:VirtualMachinePlatform /all /norestart

- 然後將WSL 2 設定為預設版本(有時可能需要重新啟動電腦):

wsl --set-default-version 2

下載Docker:

造訪docker 網站:https ://www.docker.com/products/docker-desktop/ 並點選“download for Windows”:

運行安裝過程,安裝完成後重新啟動機器:

啟動docker桌面,在docker中選擇wsl2進行整合:

透過開啟CMD 並鍵入以下內容來驗證安裝

docker --version

然後您將收到以下輸出

Docker version 24.0.6, build ed223bc

就是這樣。您已安裝並準備好docker。

Windows 上的Nvidia 驅動程式安裝

- 要檢查您是否擁有正確的驅動程序,請在Windows PC 上打開命令行(Windows 鍵+ R,鍵入cmd)並輸入以下內容:nvidia-smi 。如果您遇到以下錯誤訊息:

C:\Users>nvidia-smi 'nvidia-smi' is not recognized as an internal or external command, operable program or batch file.

這表示您沒有安裝NVIDIA 驅動程式。要安裝它們,請按照以下步驟操作:

- 造訪Nvidia 網站:https://www.nvidia.com/download/index.aspx並輸入您的GPU 名稱,然後按一下搜尋:

- 點選適合您的GPU 和Windows 版本的NVIDIA 驅動程式的「下載」按鈕。

- 下載完成後,開始安裝,選擇第一個選項,然後按一下「同意並繼續」。

- 安裝完成後,必須重新啟動電腦。重新啟動電腦以確保新的NVIDIA 驅動程式完全整合到您的系統中。

- 電腦重新啟動後,開啟命令提示字元(Windows 鍵+ R,鍵入cmd)並鍵入下列命令:

nvidia-smi

- 您應該會看到這樣的結果:

就是這樣。您已安裝並準備正確的NVIDIA 驅動程式。

下載CUDA 工具包(可選)

- 造訪NVIDIA CUDA 工具包下載頁面:https://developer.nvidia.com/cuda-downloads

- 選擇您的作業系統(例如Windows)。

- 選擇您的體系結構(對於64 位元Windows,通常為x86_64)。

- 下載exe 本機安裝程式。下載檔案後,執行安裝程式:

- 並遵循安裝過程。

- 然後,驗證安裝過程。開啟命令提示字元(Windows 鍵+ R,鍵入cmd)並鍵入以下命令:

nvcc --version

- 您應該得到以下答案:

nvcc: NVIDIA (R) Cuda compiler driver Copyright (c) 2005-2022 NVIDIA Corporation Built on Wed_Sep_21_10:41:10_Pacific_Daylight_Time_2022 Cuda compilation tools, release 111.889. cuda_11.8.r11.8/compiler.31833905_0

就是這樣。您已安裝並準備好CUDA 工具包。

請注意,我們現在正在安裝一個20GB 大小的容器,它包含ML 應用程式所需的所有套件,一切都發生在容器內,沒有任何內容從容器傳輸到檔案系統

故障指南

支援GPU 的Docker 平台故障排除指南

驗證Linux 和Windows 上的docker 設定

- 若要驗證您的設定是否正常運行,請執行:

docker run --gpus all nvidia/cuda:11.0.3-base-ubuntu18.04 nvidia-smi

- 輸出應該與nvidia-smi 類似。

- 此命令檢查Docker 是否正確利用您的GPU。

停止平台

Windows(使用PowerShell):

docker ps -a -q | ForEach { docker rm $\_ }Windows 上的正常運作時間不穩定?

若要確保路由器上的DHCP 租用時間設定為超過24 小時,請造訪Windows 作業系統中的群組原則編輯器。按以下順序啟用指定設定:

- 導覽至群組原則編輯器中的「電腦配置」。

- 在「電腦配置」中,找到「管理範本」部分。

- 在「管理範本」部分中,導覽至「系統」。

- 在“系統”選單中,選擇“電源管理”。

- 最後,存取「電源管理」中的「睡眠設定」小節。

- 在「睡眠設定」子選單中,啟動「連接待機期間允許網路連接(使用電池)」和「連接待機期間允許網路連線(插入電源)」選項。

- 請確保對這些配置進行相應調整以獲得所需的結果。

為了平台的正常運行,需要在防火牆上公開哪些連接埠:(Linux 和Windows)

TCP: 443 25061 5432 80

UDP: 80 443 41641 3478

如何驗證程式已成功啟動?

在powershell(windows) 或終端(linux) 上執行以下命令時,您應該始終執行2 個docker 容器:

docker ps

如果在網站上執行docker run -d ... 指令後沒有容器或只有1 個容器在執行:

停止平台(查看上面的命令指南)並再次使用網站命令重新啟動平台

如果這仍然不起作用- 請聯繫我們的Discord 社區尋求幫助:https://discord.com/invite/kqFzFK7fg2

io.net支援的設備

| Manufacturer | GPU Model |

|---|---|

| NVIDIA | A10 |

| NVIDIA | A100 80G PCIe NVLink |

| NVIDIA | A100 80GB PCIe |

| NVIDIA | A100-PCIE-40GB |

| NVIDIA | A100-SXM4-40GB |

| NVIDIA | A40 |

| NVIDIA | A40 PCIe |

| NVIDIA | A40-8Q |

| NVIDIA | GeForce RTX 3050 Laptop |

| NVIDIA | GeForce RTX 3050 Ti Laptop |

| NVIDIA | GeForce RTX 3060 |

| NVIDIA | GeForce RTX 3060 Laptop |

| NVIDIA | GeForce RTX 3060 Ti |

| NVIDIA | GeForce RTX 3070 |

| NVIDIA | GeForce RTX 3070 Laptop |

| NVIDIA | GeForce RTX 3070 Ti |

| NVIDIA | GeForce RTX 3070 Ti Laptop |

| NVIDIA | GeForce RTX 3080 |

| NVIDIA | GeForce RTX 3080 Laptop |

| NVIDIA | GeForce RTX 3080 Ti |

| NVIDIA | GeForce RTX 3080 Ti Laptop |

| NVIDIA | GeForce RTX 3090 |

| NVIDIA | GeForce RTX 3090 Ti |

| NVIDIA | GeForce RTX 4060 |

| NVIDIA | GeForce RTX 4060 Laptop |

| NVIDIA | GeForce RTX 4060 Ti |

| NVIDIA | GeForce RTX 4070 |

| NVIDIA | GeForce RTX 4070 Laptop |

| NVIDIA | GeForce RTX 4070 SUPER |

| NVIDIA | GeForce RTX 4070 Ti |

| NVIDIA | GeForce RTX 4070 Ti SUPER |

| NVIDIA | GeForce RTX 4080 |

| NVIDIA | GeForce RTX 4080 SUPER |

| NVIDIA | GeForce RTX 4090 |

| NVIDIA | GeForce RTX 4090 Laptop |

| NVIDIA | H100 80G PCIe |

| NVIDIA | H100 PCIe |

| NVIDIA | L40 |

| NVIDIA | Quadro RTX 4000 |

| NVIDIA | RTX 4000 SFF Ada Generation |

| NVIDIA | RTX 5000 |

| NVIDIA | RTX 5000 Ada Generation |

| NVIDIA | RTX 6000 Ada Generation |

| NVIDIA | RTX 8000 |

| NVIDIA | RTX A4000 |

| NVIDIA | RTX A5000 |

| NVIDIA | RTX A6000 |

| NVIDIA | Tesla P100 PCIe |

| NVIDIA | Tesla T4 |

| NVIDIA | Tesla V100-SXM2-16GB |

| NVIDIA | Tesla V100-SXM2-32GB |

CPU

| Manufacturer | CPU Model |

|---|---|

| Apple | M1 Pro |

| Apple | M1 |

| Apple | M1 Max |

| Apple | M2 |

| Apple | M2 Max |

| Apple | M2 Pro |

| Apple | M3 |

| Apple | M3 Max |

| Apple | M3 Pro |

| AMD | QEMU Virtual CPU version 2.5+ |