精品軟體與實用教程

如何阻止AI 爬蟲機器人?無論你是內容創作者還是部落格作者,都是以產生獨特、高品質的內容為生。您是否注意到OpenAI 或CCBot 等生成式AI 平台會在未經您同意的情況下使用您的內容來訓練其演算法?不用擔心!您可以使用 robots.txt 檔案阻止這些AI 爬蟲造訪您的網站或部落格。

什麼是robots.txt 檔案?

robots.txt只不過是一個文字文件,指導機器人(例如搜尋引擎機器人)如何抓取其網站上的頁面並為其建立索引。您可以阻止/允許追蹤您的robots.txt 檔案的好機器人或壞機器人。使用用戶代理阻止單一機器人的語法如下:

user-agent: {BOT-NAME-HERE} disallow: /

以下是如何允許特定機器人使用用戶代理程式抓取您的網站:

User-agent: {BOT-NAME-HERE} Allow: /

將robots.txt 檔案放置在哪裡?

將文件上傳到您網站的根資料夾。所以該URL 將如下所示:

https://example.com/robots.txt https://blog.example.com/robots.txt

有關詳細信息,請參閱以下有關robots.txt 的資源:

- 來自Google 的robots.txt 簡介。

- 什麼是robots.txt? | robots.txt 檔案如何在Cloudflare 中工作。

如何使用robots.txt 檔案阻止AI 爬蟲機器人

語法相同:

user-agent: {AI-Ccrawlers-Bot-Name-Here} disallow: /

使用robots.txt 檔案阻止OpenAI

將以下四行加入robots.txt 中:

User-agent: GPTBot Disallow: / User-agent: ChatGPT-User Disallow: /

請注意,OpenAI 有兩個獨立的使用者代理程式用於網路爬行和瀏覽,每個代理程式都有自己的CIDR 和IP 範圍。要設定下面列出的防火牆規則,您需要對網路概念和Linux 根級存取有深入的了解。如果您缺乏這些技能,請考慮使用Linux 系統管理員的服務來防止來自不斷變化的IP 位址範圍的存取。這可能會變成一場貓捉老鼠的遊戲。

1:ChatGPT-User由ChatGPT 中的外掛使用

以下是OpenAI 爬蟲和獲取器使用的用戶代理列表,包括CIDR 或IP 位址範圍,用於阻止您可以與Web 伺服器防火牆一起使用的插件AI 機器人。您可以在Web 伺服器上使用ufw 指令或iptables 指令來封鎖23.98.142.176/28 。例如,以下是使用UFW 阻止CIDR 或IP 範圍的防火牆規則:

sudo ufw deny proto tcp from 23.98.142.176/28 to any port 80 sudo ufw deny proto tcp from 23.98.142.176/28 to any port 443

2:GPTBot由ChatGPT 使用

以下是OpenAI 爬蟲和獲取器使用的用戶代理列表,包括CIDR或IP 位址範圍,用於封鎖您可以與Web 伺服器防火牆一起使用的AI 機器人。同樣,您可以使用ufw 指令或iptables 指令來阻止這些範圍。以下是封鎖這些CIDR 範圍的shell 腳本:

#!/bin/bash # Purpose: Block OpenAI ChatGPT bot CIDR # Tested on: Debian and Ubuntu Linux # Author: Vivek Gite {https://www.cyberciti.biz} under GPL v2.x+ 1hTP5T--------------------------------14 -O "$file" https://openai.com/gptbot-ranges.txt 2>/dev/null while IFS= read -r cidr do sudo ufw deny proto tcp from $cidr to any port 80 sudo ufw deny proto tcp from $cidr to any port 80 sudo ufw deny protocpn from 14Tcidr to any port 80 sudo ufw deny proto tcpn from 14Tcidr to any port 80 sudo ufw deny proto tcpn from 14Tcidr to any port 40 < "$file" [ -f "$file" ] && rm -f "$file"

阻止Google AI(Bard 和Vertex AI 產生API)

將以下兩行加入您的robots.txt :

User-agent: Google-Extended Disallow: /

有關詳細信息,請參閱以下Google 抓取工具和提取程序使用的用戶代理的列表。但是,Google 不提供CIDR、IP 位址範圍或自治系統資訊(ASN) 來阻止您可以與Web 伺服器防火牆一起使用的AI 機器人。

使用robots.txt 檔案阻止commoncrawl (CCBot)

將以下兩行加入您的robots.txt :

User-agent: CCBot Disallow: /

儘管Common Crawl 是一個非營利基金會,但每個人都透過其名為CCbot 的機器人使用數據來訓練他們的人工智慧。阻止它們也很重要。然而,就像Google 一樣,他們不提供CIDR、IP 位址範圍或自治系統資訊(ASN) 來阻止您可以與Web 伺服器防火牆一起使用的AI 機器人。

使用robots.txt 檔案阻止Perplexity AI

另一項服務可以獲得您的所有內容並使用生成人工智慧重寫它。您可以按如下方式阻止它:

User-agent: PerplexityBot Disallow: /

他們也發布了IP 位址範圍,您可以使用WAF 或Web 伺服器防火牆進行封鎖。

AI 機器人可以忽略我的robots.txt 檔案嗎?

Google 和OpenAI 等知名公司通常遵守robots.txt 協議。但一些設計不佳的人工智慧機器人會忽略你的robots.txt。

是否可以使用AWS 或Cloudflare WAF 技術來阻止AI 機器人?

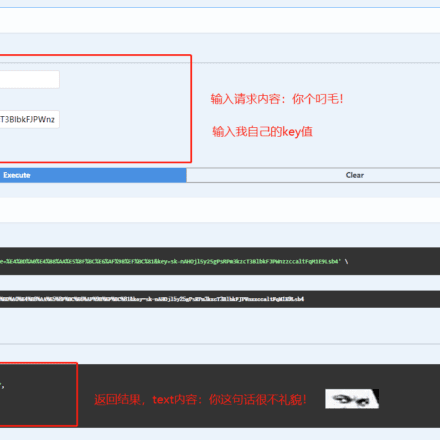

Cloudflare 最近宣布,他們推出了一項新的防火牆規則,可以阻止AI 機器人。但是,搜尋引擎和其他機器人仍然可以透過其WAF 規則使用您的網站/部落格。重要的是要記住,WAF 產品需要徹底了解機器人的運作方式,並且必須謹慎實施。否則,也可能導致其他用戶被封鎖。以下是使用 Cloudflare WAF 阻止AI 機器人的方法:

請注意,我正在評估Cloudflare 解決方案,但我的初步測試顯示它阻止了至少3.31% 的用戶。 3.31% 是CSR(挑戰解率)率,也就是解決Cloudflare 提供的驗證碼的人。這是很高的企業社會責任率。我需要做更多測試。當我開始使用Cloudflare 時,我會更新這篇部落格文章。

我可以阻止對GitHub 和其他雲端託管網站上託管的程式碼和文件的存取嗎?

不,我不知道這是否可能。

我對使用GitHub 感到擔憂,它是微軟的產品,也是OpenAI 的最大投資者。他們可能會使用您的資料透過服務條款更新和其他漏洞來訓練人工智慧。最好是您的公司或您獨立託管git 伺服器,以防止您的資料和程式碼被用於培訓。蘋果等大公司禁止內部使用ChatGPT 和類似產品,因為他們擔心這可能會導致程式碼和敏感資料外洩。

當人工智慧被用來造福人類時,阻止人工智慧機器人取得訓練資料是否道德?

我對使用OpenAI、Google Bard、Microsoft Bing 或任何其他人工智慧來造福人類持懷疑態度。這似乎只是一個賺錢的計劃,而生成式人工智慧取代了白領工作。但是,如果您有任何關於如何利用我的數據來治愈癌症(或類似的東西)的信息,請隨時在評論部分分享。

我個人的想法是,我現在沒有從OpenAI/Google/Bing AI 或任何人工智慧中受益。我努力工作了20 多年,我需要保護我的工作免受這些大型科技公司的直接獲利。你不必同意我的觀點。你可以把你的程式碼和其他東西交給人工智慧。請記住,這是可選的。他們現在提供robots.txt 控制的唯一原因是因為多個圖書作者和公司正在法庭上起訴他們。除了這些問題之外,人工智慧工具也被用來創建垃圾郵件網站和電子書。請參考以下精選讀物:

- Sarah Silverman 起訴OpenAI 和Meta

- AI圖像創作者面臨英國和美國的法律挑戰

- Stack Overflow 是ChatGPT 的傷亡:3 月流量下降14%

- 作者使用ChatGPT 向Kindle 圖書發送垃圾郵件

- ChatGPT 因隱私問題在義大利被禁止

- AI 垃圾郵件已經在網路上氾濫,並且有明顯的跡象

- 專家警告人工智慧可能導致滅絕

- 人工智慧被用來產生整個垃圾郵件網站

- 公司計劃拋棄人類員工,轉而採用ChatGPT 式人工智慧

- 讓ChatGPT 等AI 聽起來很聰明的網站秘密列表

確實,人工智慧已經使用了您的大部分數據,但您將來創建的任何內容都可以透過這些技術得到保護。

加起來

隨著生成式人工智慧變得越來越流行,內容創作者開始質疑人工智慧公司未經許可使用資料來訓練他們的模型。他們從數百萬小型獨立創作者創建的代碼、文字、圖像和影片中獲利,同時剝奪了他們的收入來源。有些人可能不會反對,但我知道這樣突然的舉動會摧毀很多人。因此,網站營運商和內容創作者應該能夠輕鬆阻止不必要的人工智慧爬蟲。這個過程應該很簡單。

我將更新此頁面,因為將可以透過robots.txt 並使用Cloudflare 等第三方提供的雲端解決方案來阻止更多機器人。

其他阻止機器人的開源項目

- Nginx Bad Bot 和用戶代理攔截器

- Fail2Ban掃描/var/log/auth.log 等日誌文件,並禁止進行過多失敗登入嘗試的IP 位址。