우수한 소프트웨어와 실용적인 튜토리얼

AI 얼굴변환 라이브 방송 도구

경고: 이 도구를 불법적인 활동에 사용하지 마십시오. 이로 인해 발생하는 모든 결과에 대한 책임은 전적으로 귀하에게 있습니다.

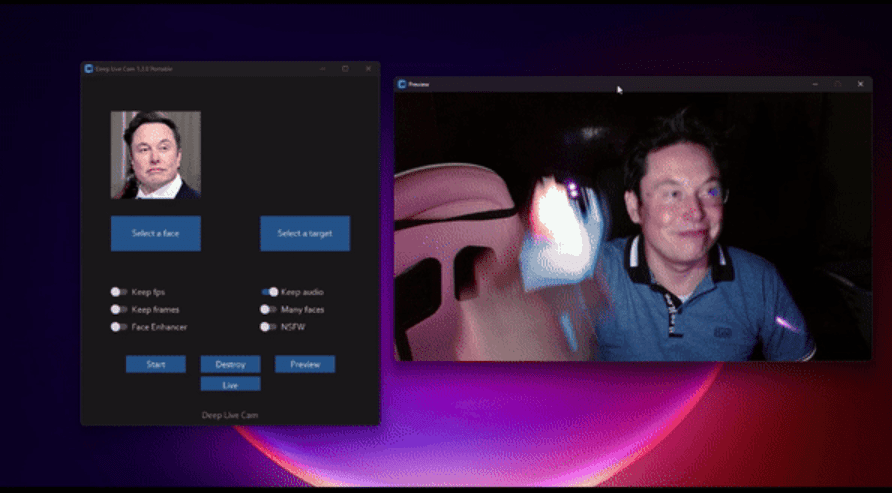

Deep Live Cam은 사진/동영상 속 얼굴을 사용자가 지정한 사진 속 얼굴로 바꿔주는 간편한 얼굴 변환 도구입니다. CPU/GPU/Mac 환경에서 실행 가능합니다. Deep Live Cam AI는 화상 통화나 라이브 방송에서 사용자의 얼굴을 즉시 바꿔주는 실시간 얼굴 변환 도구입니다. 이 기술은 고급 딥러닝 알고리즘과 얼굴 인식 기술을 사용하여 사실적인 실시간 "딥페이크" 효과를 생성하여 사용자가 화상 통화에서 다른 사람의 얼굴을 연기할 수 있도록 합니다.

이 도구는 오픈 소스라는 특성으로 인해 널리 사용되고 논의되어 왔습니다. 가상 캐릭터나 미디어 제작과 같은 특정 창작 환경에서는 합법적으로 사용될 수 있지만, 특히 신원 도용 및 사기와 같은 잠재적 위험과 관련하여 개인정보 보호 및 윤리적 문제를 야기합니다. 남용을 방지하기 위해 개발자들은 사용자 개인정보를 보호하는 콘텐츠 검토 메커니즘을 도입하려고 노력해 왔습니다.

딥라이브캠AI의 핵심 가치는 광범위한 적용 분야에 있습니다. 아티스트는 AI를 활용하여 맞춤형 캐릭터에 애니메이션 효과를 추가하거나, 캐릭터를 의상 디자인의 모델로 활용할 수 있습니다. 또한, 영화 및 TV 후반 작업, 가상 앵커, 교육 프레젠테이션 등 다양한 분야에 적용되어 콘텐츠 제작의 가능성을 크게 확대할 수 있습니다.

딥라이브캠AI의 핵심 가치는 광범위한 적용 분야에 있습니다. 아티스트는 AI를 활용하여 맞춤형 캐릭터에 애니메이션 효과를 추가하거나, 캐릭터를 의상 디자인의 모델로 활용할 수 있습니다. 또한, 영화 및 TV 후반 작업, 가상 앵커, 교육 프레젠테이션 등 다양한 분야에 적용되어 콘텐츠 제작의 가능성을 크게 확대할 수 있습니다.

GitHub 프로젝트 페이지:https://github.com/hacksider/Deep-Live-Cam

딥 라이브 캠 무료 청구

이 소프트웨어는 AI 미디어 산업에 기여하는 것을 목표로 합니다. 아티스트들이 맞춤형 캐릭터를 애니메이션으로 제작하거나 의상 모델로 활용하는 등의 작업을 지원할 수 있도록 설계되었습니다.

저희는 비윤리적인 애플리케이션의 잠재적 위험을 인지하고 있으며 예방 조치를 취하기 위해 최선을 다하고 있습니다. 내장된 검사 기능을 통해 프로그램이 부적절한 미디어(나체, 노골적인 콘텐츠, 전쟁 영상과 같은 민감한 자료 등)를 처리하는 것을 방지합니다. 저희는 법적 및 윤리적 기준을 준수하며 책임감 있게 프로젝트를 계속 개발해 나갈 것입니다. 법에 따라 필요한 경우 프로젝트를 중단하거나 워터마크를 추가할 수 있습니다.

사용자는 소프트웨어를 책임감 있고 합법적으로 사용해야 합니다. 실제 얼굴을 사용하는 경우, 사용자의 동의를 구하고 온라인에 공유할 때 모든 결과물이 딥페이크임을 명확하게 표시해 주십시오. 당사는 최종 사용자의 행동에 대해 책임을 지지 않습니다.

설치 전 준비

N카드 CUDA가 설치되어 있어야 합니다

다운로드 주소:https://developer.nvidia.com/cuda-downloads/

AMD 그래픽 카드 AMD HIP SDK가 설치되어 있어야 합니다.

다운로드

- https://pan.quark.cn/s/f5f86d769394

- https://drive.uc.cn/s/eab589fe1a1d4

- https://pan.baidu.com/s/1c65OrFR18AuHOvTH56Yu7Q?pwd=6666

Microsoft 공통 런타임 라이브러리 컬렉션 2024.08.14

- https://pan.quark.cn/s/e4bcf05899c9

- https://pan.baidu.com/share/init?surl=hlSdsPD-H1FgD2IFanLJWA&pwd=6666

런타임 라이브러리도 다음과 같이 설치할 수 있습니다.게임 소프트웨어 런타임 컬렉션(2024.10.01) 통합 게임 강화 런타임

딥 라이브 캠 설치

Windows 컴퓨터에 Nvidia 그래픽 카드가 설치되어 있는 경우 직접 다운로드하여 다운로드 후 바로 사용할 수 있습니다.

다운로드 후 압축을 풀고 실행하세요. 이 버전은 자동 압축 해제 방식으로 제공되어 복잡한 설치 과정이 필요하지 않습니다.

주요 특징

- 간편한 설치: 지루한 설치 단계에 작별 인사를 전하고, 바로 다운로드하고 압축을 풀고 실행하기만 하면 됩니다.

- 최적화된 성능: 호환되는 NVIDIA GPU에서 매끄러운 실시간 효과를 경험해보세요.

- 사용자 친화적인 인터페이스: 직관적인 디자인으로 모든 수준의 사용자가 쉽게 사용할 수 있습니다.

시스템 요구 사항

NVIDIA GPU: 6GB 이상의 비디오 메모리가 필요합니다(최상의 성능을 위해서는 최신 모델을 권장합니다).

CUDA 툴킷 11.8.

운영체제: Windows 10 또는 Windows 11.

메모리: 16GB 권장.

참고: 이 버전은 GitHub 버전과 동일한 기능을 제공하지만, 더 간소화된 사용자 경험을 제공합니다.

Deep Live Cam 통합 패키지 다운로드

패키지된 것을 다운로드하세요. N 카드와 A 카드 모두에 맞는 통합 패키지를 만들었습니다. 그래픽 카드의 비디오 메모리가 8GB 미만이면 다운로드하지 마세요!

https://pan.quark.cn/s/bad0d6cd6f0d

통합 패키지를 다운로드하고 설치하세요

다음은 CPU 설치와 GPU 설치를 지원하는 설치 통합 패키지입니다.

파일 패키지 크기는 6.46GB입니다. 이 패키지에는 Python과 종속 패키지, ffmpeg, vsc 환경 설치 스크립트가 이미 포함되어 있습니다.

https://pan.baidu.com/s/1OzvIzV80rDMZALzUGazHpA?pwd=iaim

CPU나 GPU 중 무엇을 실행할지에 따라 해당 .bat 시작 파일을 두 번 클릭합니다.

실행 후 앱 인터페이스가 나타납니다. 왼쪽에서 모방하려는 얼굴 사진을 선택하고, 오른쪽에서 변환할 사진을 선택한 후, 시작(사진 변환)을 클릭하거나, 오른쪽에서 사진을 업로드하지 않고 바로 라이브 방송을 클릭하세요.실시간 얼굴 바꾸기.

딥 라이브 캠 수동 설치

Deep-Live-Cam을 수동으로 설치하는 경우 CPU를 사용하면 다소 느리게 실행될 수 있으므로 GPU 버전을 사용하는 것이 좋습니다.

Deep-Live-Cam 설치는 비교적 간단하지만 Python 3.10, pip, git, ffmpeg 등 특정 컴퓨터 환경 설정이 필요합니다. 사용자는 GitHub 저장소를 복제하고, 모델 파일을 다운로드하여 배치하고, 종속성을 설치하여 설치를 완료할 수 있습니다. 이 소프트웨어는 CPU, CUDA(Nvidia GPU), CoreML(Apple Silicon), DirectML(Windows), OpenVINO(Intel) 등 다양한 실행 공급자를 지원합니다. 사용자는 자신의 하드웨어 조건에 따라 적합한 실행 솔루션을 선택할 수 있습니다.

필수 조건

- 파이썬(3.10을 권장합니다)

- 씨

- git

- ffmpeg

- Visual Studio 2022 런타임(Windows)

Visual Studio 2022 런타임(Windows) Visual Studio 2022용 Visual C++ 재배포 가능 패키지에서 필요한 버전을 선택하세요.

https://learn.microsoft.com/en-us/cpp/windows/latest-supported-vc-redist

64비트 버전 설치 패키지를 여기에서 직접 다운로드하세요: https://aka.ms/vs/17/release/vc_redist.x64.exe

Visual Studio 2022 Professional Edition 설치 튜토리얼

인터넷을 과학적으로 사용해야 합니다. PyTorch 다운로드가 느리거나 다운로드할 수 없는 문제가 발생하면 다른 프록시 노드를 사용하여 다시 시도해 보세요.

수동 설치 단계

수동 설치는 직접 조작하는 것을 좋아하는 전문가에게 적합합니다. 초보자는 패키지에 포함된 제품을 직접 사용하는 것이 좋습니다.

Git을 사용하여 Deep-Live-Cam 프로젝트 복제

GitHub 저장소를 복제하면 Deep-Live-Cam 프로젝트 코드가 로컬 컴퓨터에 다운로드됩니다.

git 클론 https://github.com/hacksider/Deep-Live-Cam.git

이후 해당 디렉토리에서 명령을 실행할 수 있도록 프로젝트 디렉토리를 입력하세요.

cd 딥라이브캠

종속성 설치

새로운 Conda 환경 deeplivecam을 만들고 Python 버전 3.10을 지정하여 프로젝트의 종속성을 분리합니다.

conda create -n deeplivecam python=3.10 -y

방금 생성한 Conda 환경을 활성화하여 Python을 실행하고 종속성을 설치하세요.

conda가 deeplivecam을 활성화합니다

requirements.txt 파일에 나열된 프로젝트의 종속성을 설치합니다.

pip install -r requirements.txt

모델을 다운로드하세요

두 모델을 프로젝트 루트 디렉토리의 /models 폴더에 다운로드하세요. 다운로드 링크:

- inswapper_128_fp16.onnx:https://huggingface.co/hacksider/deep-live-cam/resolve/main/inswapper128fp16.onnx

- 참고: inswapper_128_fp16.onnx에 문제가 발생하면 다음 대체 버전을 사용하세요.https://github.com/facefusion/facefusion-assets/releases/download/models/inswapper_128_fp16.onnx

- GFPGANv1.4:https://huggingface.co/hacksider/deep-live-cam/resolve/main/GFPGANv1.4.pth

- 이 파일을 "모델" 폴더에 넣으세요.

GPU 버전 사용 방법

GPU 사용 단계

특정 버전을 지정해야 하므로 설치된 onnxruntime 및 onnxruntime-gpu를 제거하세요.

pip uninstall onnxruntime onnxruntime-gpu

프로젝트의 CUDA 버전과의 호환성을 보장하기 위해 지정된 버전의 onnxruntime-gpu를 설치하세요.

pip install onnxruntime-gpu==1.16.3

CUDA를 사용하여 프로젝트의 메인 스크립트 run.py를 실행하고 GPU 가속을 사용합니다.

파이썬 파이썬 run.py --실행-제공자 cuda

CPU 버전 사용 방법

시작하려면 다음 명령을 실행하세요.

파이썬 run.py

사용 시나리오

- 앵커 페이스 스왑

- 개인 정보 보호를 위한 비디오 얼굴 교환