Dieser Artikel beschreibt hauptsächlich die Verwendung Amazonas Einfaches Hosting des SageMaker Notebook-Maschinenlerndienstes Stabile Diffusion WebUIDie bildorientierte, leichtgewichtige AIGC-Anwendung ist sofort einsatzbereit und kann mit nur einem Klick bereitgestellt werden. Dank der Amazon CloudFormation Infrastructure-as-Code-Dienste können die zugrundeliegende Umgebung, das KI-Modell und die Front-End-Stable-Diffusion-WebUI schnell bereitgestellt werden. So können Benutzer in 15 bis 20 Minuten eine Reihe von Text-zu-Bild- und Bild-zu-Bild-KI-Anwendungen implementieren. Diese Lösung eignet sich für Unternehmenskunden, um vorläufige Untersuchungen und eine schnelle Überprüfung der AIGC-Bildrichtung durchzuführen, sowie für kleine Teams, um schnell leichtgewichtige KI-Anwendungen zu erstellen.Wenn Sie das praktische Experiment schnell ausprobieren möchten, können Sie den QR-Code am Ende des Artikels scannen, ein Amazon Web Services-Konto registrieren, Cloud-Ressourcen im Wert von 200 $ kostenlos erhalten und den unendlichen Charme der KI-Malerei erkunden.Offizielle Website von Amazon Web Services:https://www.amazonaws.cn

Offizielle Website von Amazon Cloud Overseas:https://aws.amazon.com/cn/

Diese Lösung bietet derzeit Bilderzeugung basierend auf Stable Diffusion 1.5, basierend auf DreamBooth Bildtraining und -begründung; technischer Support für Skripte und Erweiterungen wird derzeit nicht angeboten. Leser können weiterhin auf die funktionale Iteration nachfolgender Lösungen achten.

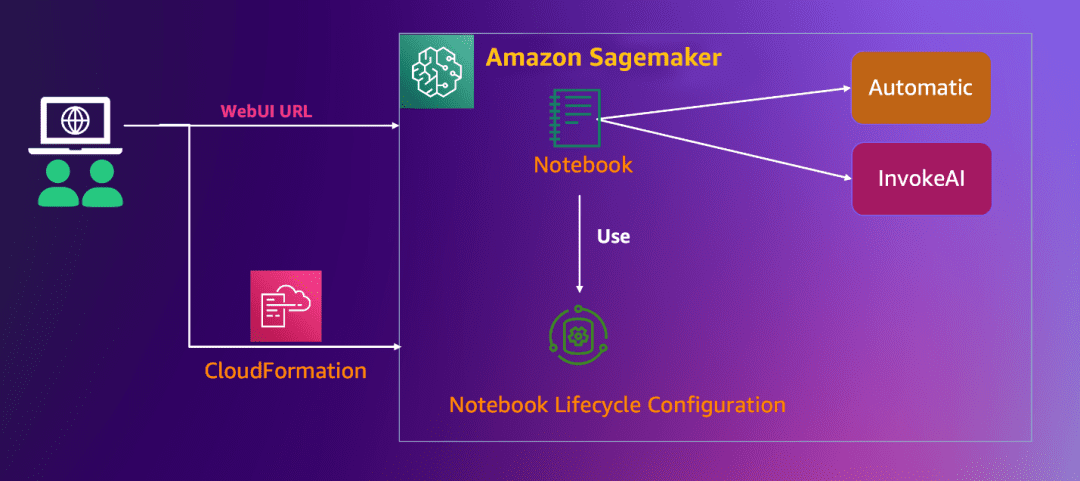

● Diese Lösung nutzt CloudFormation für die Ein-Klick-Bereitstellung. Mit nur wenigen Klicks können Sie schnell eine Reihe von AIGC-bildorientierten Webanwendungsumgebungen in Ihrem Amazon-Konto bereitstellen. Die interaktive Oberfläche ist einfach und benutzerfreundlich und ermöglicht Nutzern den schnellen Zugriff auf KI-Dienste wie Text-zu-Bild und Bild-zu-Bild. ● Die zugrunde liegende Ebene nutzt die Jupyter-Notebook-Instanz, die von der Amazon SageMaker Notebook Instance gehostet wird. Sie müssen sich nicht um den Aufbau der Basisumgebung (wie Speicher, Netzwerk usw.) und den Betrieb und die Wartung der zugrunde liegenden Infrastruktur kümmern.● Die Lösung verwendet den vollständig verwalteten Stable Diffusion AI-Modelldienst (1.5 Lightweight-Version, einschließlich zwei Schnittstellen: Stable Diffusion WebUI und InvokeAI), verfügt über eine gute Open-Source-Projekterfahrung und unterstützt die Installation von Plug-Ins entsprechend Ihren Anforderungen, um Nutzungsszenarien zu erweitern (wie ControlNet).

● Benutzer können ihre eigenen Bilddaten verwenden, um das Modell zu optimieren. Das Ausgabemodell kann auf der Grundlage automatisierter Pipeline-Tools schnell online im Inferenzknoten bereitgestellt werden, wodurch Bildinferenzaufrufe im großen Maßstab erleichtert werden.

● Diese Lösung ist vollständig Open Source und Benutzer können Modelle und Erweiterungen in SageMaker Notebook anpassen und entwickeln, um ihre eigenen Geschäftsanforderungen zu erfüllen.

3.1 Amazon SageMaker NotebookAmazon SageMaker Notebook-Instanzen sind Machine-Learning-(ML)-Compute-Instanzen, die Jupyter Notebook-Anwendungen ausführen. SageMaker verwaltet die Erstellung von Instanzen und zugehörigen Ressourcen. Verwenden Sie Jupyter Notebooks in Ihren Notebook-Instanzen, um Daten vorzubereiten und zu verarbeiten, Code zum Trainieren von Modellen zu schreiben, Modelle im SageMaker-Hosting bereitzustellen und Ihre Modelle zu testen oder zu validieren.3.2 Stabiles DiffusionsmodellStable Diffusion ist ein Text-zu-Bild-Modell, das von CompVis, Stability AI und LAION entwickelt wurde. Es wird mit einer großen Anzahl von 512×512 Bild-Text-Modellen aus dem LAION-5B-Subset trainiert. Benutzer können einfach einen Text eingeben, und Stable Diffusion wandelt ihn schnell in ein Bild um. Ebenso können Benutzer Bilder oder Videos einfügen und mit Text verarbeiten.3.3.1 Anwendungsbeispiel für Stable Diffusion WebUI+GinsengPrüfenStabile Diffusion-WebUI Es handelt sich um eine Browseroberfläche für Stable Diffusion. Sie bietet eine Vielzahl von Funktionen wie txt2img, img2img usw. Darüber hinaus enthält sie zahlreiche zusätzliche Upgrades, wie z. B. Verbesserungen bei der Modellfusion und Bildqualitätsverbesserungen. Durch die Anpassung verschiedener Parameter lassen sich unterschiedliche Effekte erzeugen, die Nutzer nach ihren Bedürfnissen und Vorlieben gestalten können. Sie unterstützt nicht nur die Bilderzeugung und die Verwendung verschiedener Modelle zur Erzielung der gewünschten Effekte, sondern trainiert auch eigene exklusive Modelle. Stable Diffusion WebUI:https://github.com/AUTOMATIC1111/stable-diffusion-webui

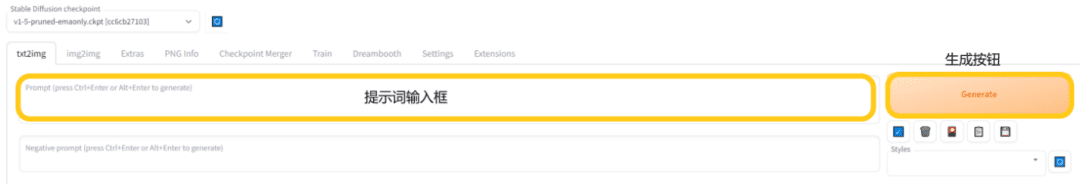

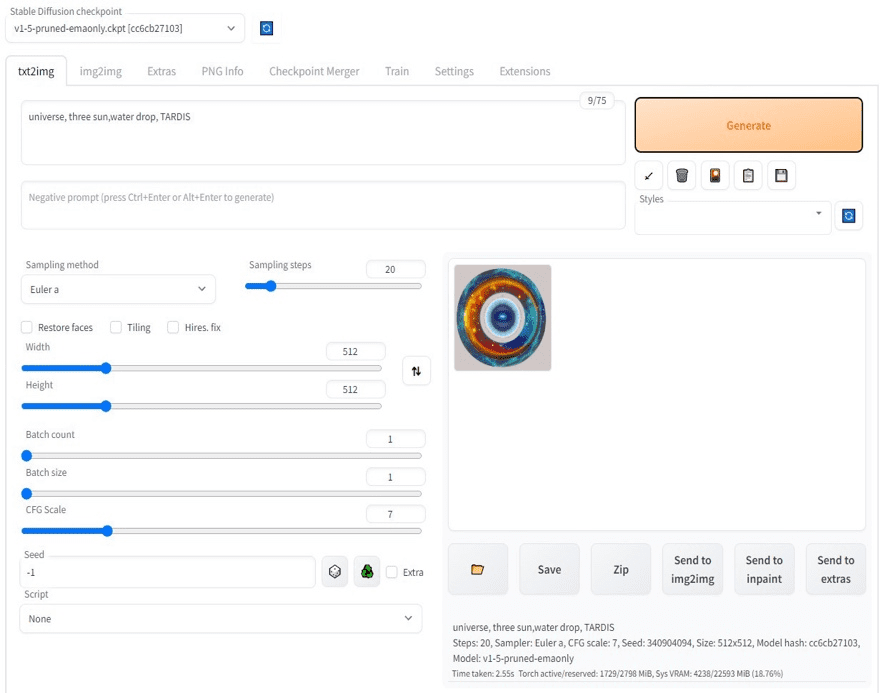

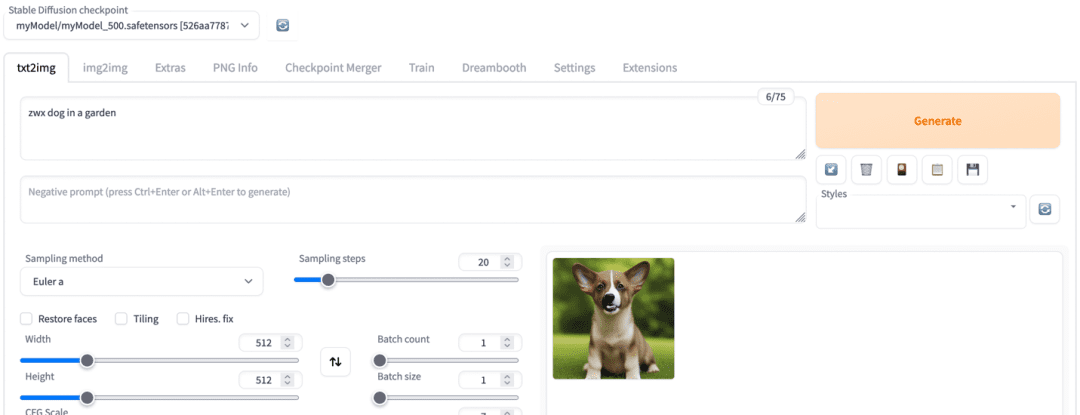

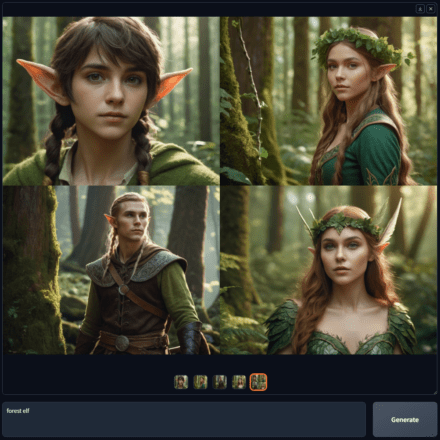

Am Beispiel der Text-zu-Bild-Generierung können Benutzer die Eingabeaufforderungswörter verwenden, um das gewünschte Bild in der „txt2img“-Oberfläche zu generieren. Die Schritte sind wie folgt:

● Klicken Sie auf „txt2img“, um die Textbild-Oberfläche aufzurufen

● Geben Sie das Eingabewort in das Eingabefeld für das Eingabewort ein

● Klicken Sie auf die Schaltfläche „Generieren“, um das Bild zu generieren

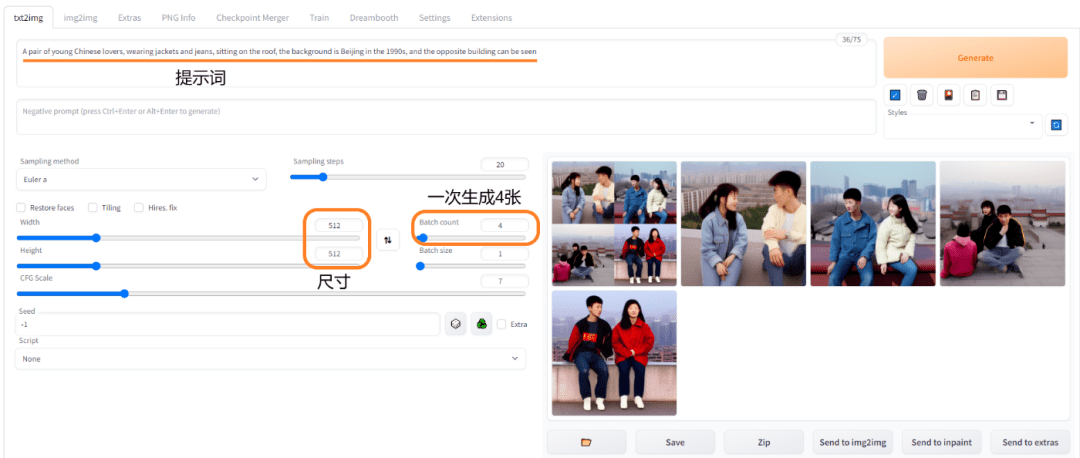

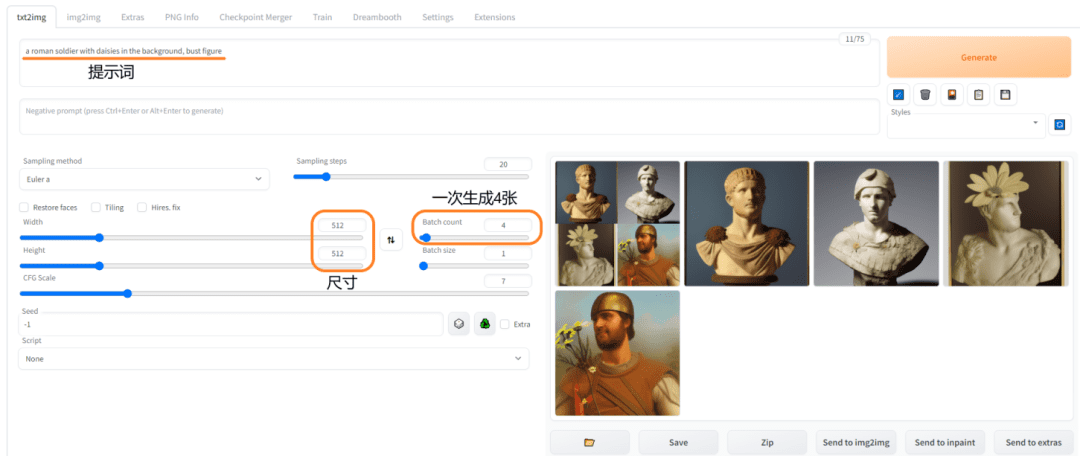

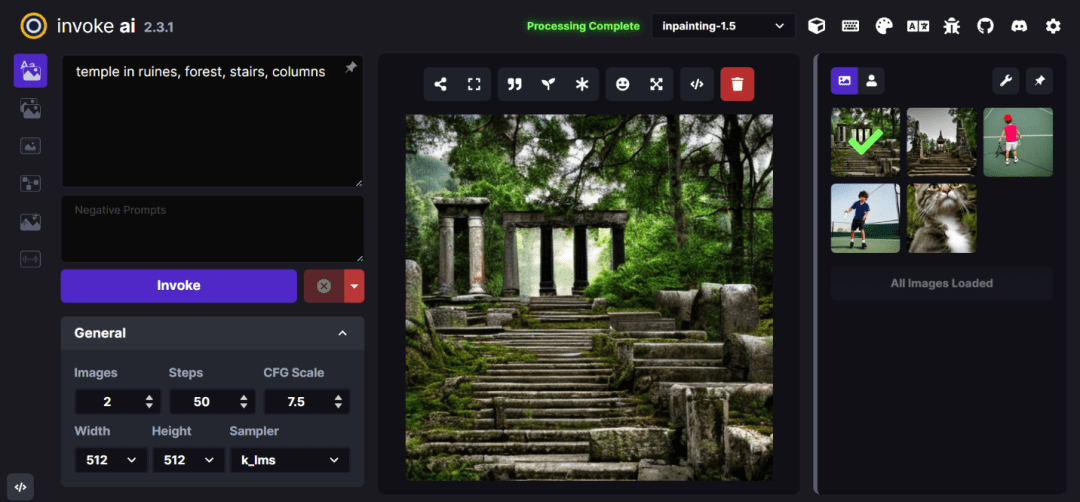

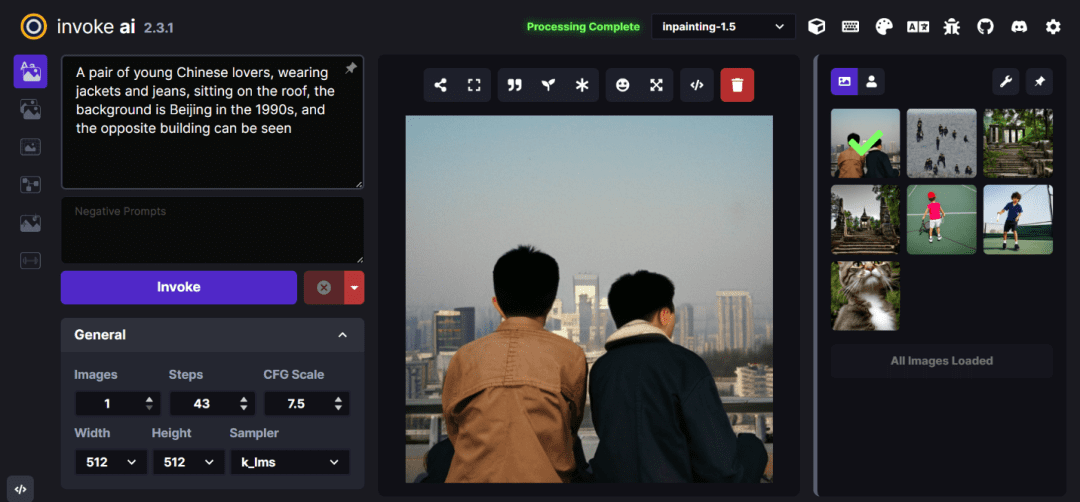

1. Erstellen Sie ein junges chinesisches Liebespaar in den 1990er Jahren, Größe 512 × 512, erstellen Sie jeweils 4 Bilder: Eingabeaufforderung: Ein junges chinesisches Liebespaar in Jacken und Jeans sitzt auf dem Dach, im Hintergrund ist Peking in den 1990er Jahren, und das gegenüberliegende Gebäude ist zu sehen2. Erstellen Sie eine Büste eines römischen Soldaten mit Gänseblümchen im Hintergrund, Größe 512×512, generieren Sie 4 Bilder gleichzeitig: Eingabeaufforderung: Ein römischer Soldat mit Gänseblümchen im Hintergrund, Büste3.3.2 Referenz zu Anwendungsbeispielen für InvokeAI+InvokeAI InvokeAI ist eine Implementierung von Stable Diffusion, einem Open-Source-Text-zu-Bild- und Bild-zu-Bild-Generator. Es bietet eine optimierte Pipeline mit verschiedenen neuen Funktionen und Optionen zur Unterstützung des Bildgenerierungsprozesses.https://github.com/invoke-ai/InvokeAI

Prompt: Tempel in Ruinen, Wald, Treppen, Säulen

Prompt: Ein junges chinesisches Liebespaar in Jacken und Jeans sitzt auf dem Dach, im Hintergrund das Peking der 1990er Jahre, das gegenüberliegende Gebäude ist zu sehen3.4 Lösungsbereitstellung3.4.1 Schritte zur Lösungsbereitstellung1. Melden Sie sich bei der Konsole an und ändern Sie die Region in der oberen rechten Ecke der Konsolenseite auf us-east-1.

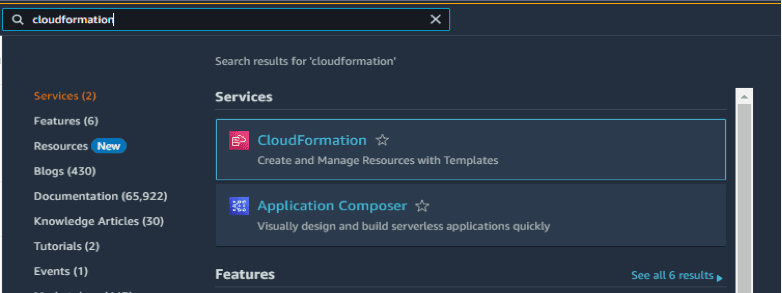

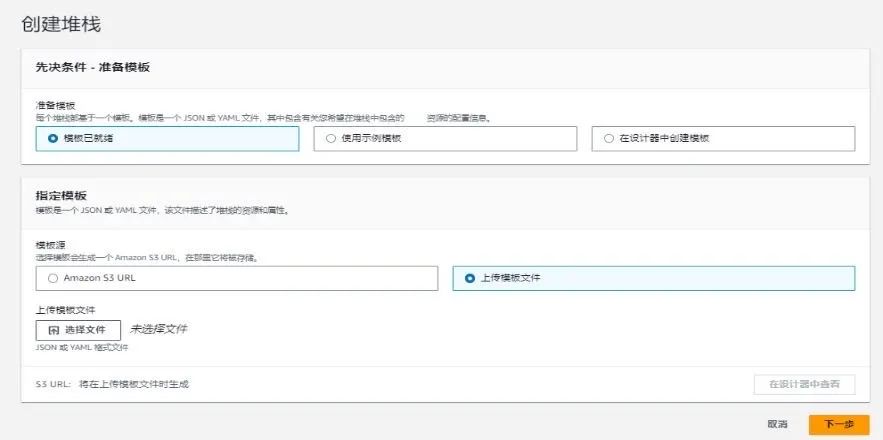

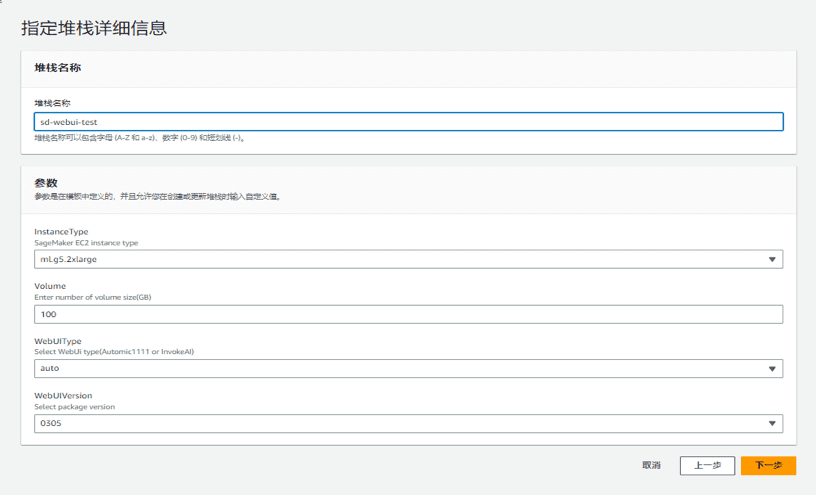

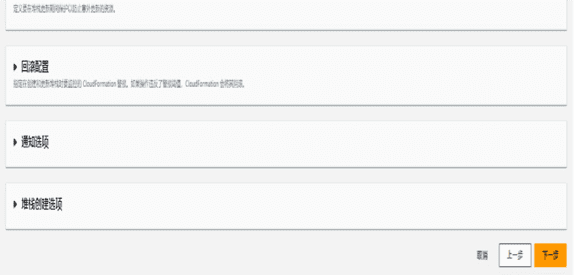

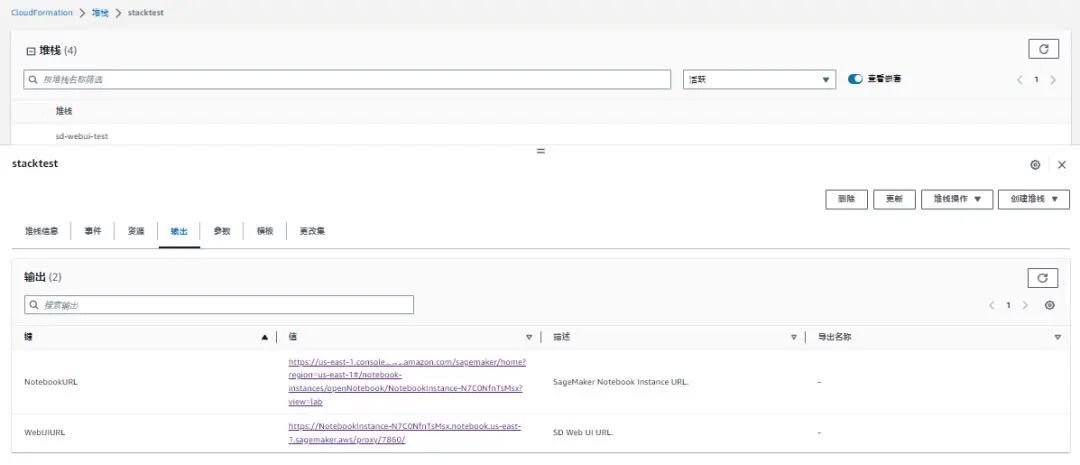

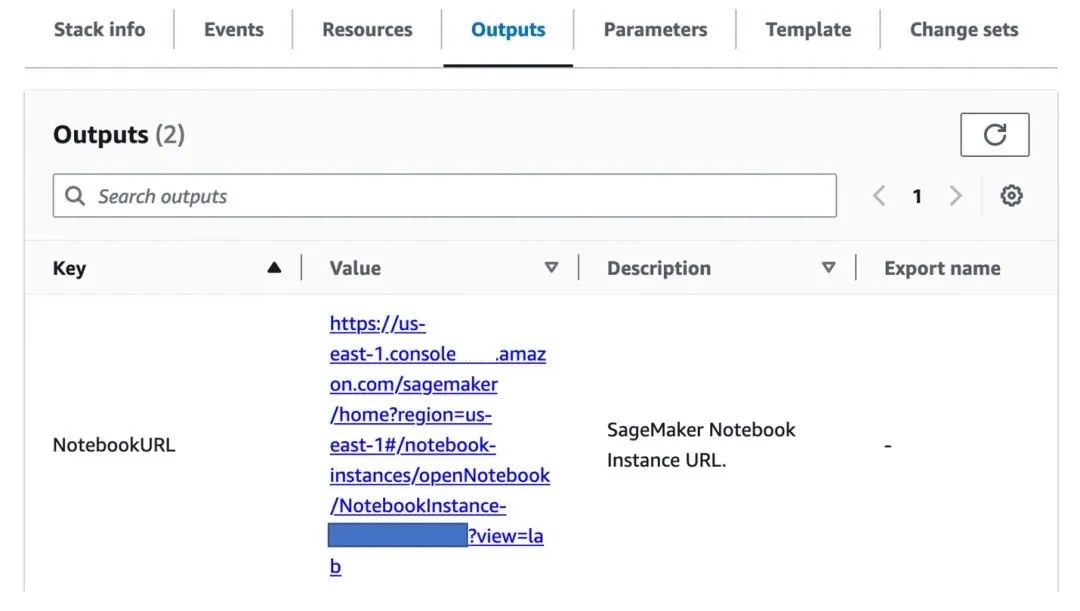

2. Geben Sie Cloudformation in das Service-Suchfeld ein und klicken Sie auf die Eingabetaste.3. Erstellen Sie einen Stapel - Verwenden Sie neue Ressourcen (Standard) - Laden Sie die Vorlagendatei hoch, die unter folgendem Link heruntergeladen werden kann: https://xiekl.s3.cn-northwest-1.amazonaws.com.cn/sd-webui.yml4. Geben Sie den Stacknamen ein. Es wird empfohlen, als Instanztyp „g5.2xlarge“ auszuwählen. Die Standardgröße des Datenträgers beträgt 100 GB. Wählen Sie den WebUI-Typ. Der Standardwert ist „auto“, was für „Stable Diffusion WebUI“ steht. Wählen Sie als WebUI-Version „0316“ und klicken Sie auf „Weiter“.5. Behalten Sie die Standardeinstellungen bei und klicken Sie auf „Weiter“.6. Bestätigen Sie die Konfiguration (behalten Sie die Standardeinstellung bei), aktivieren Sie „Ich bestätige …“, klicken Sie auf „Senden“ und warten Sie 15–20 Minuten, bis die Bereitstellung abgeschlossen ist.3.4.2 Verwenden der Stable Diffusion WebUI zur TextgenerierungBild 1. Warten Sie nach dem Erstellen des Stapels, bis die Ressourcen nacheinander gestartet werden (ca. 20 Minuten). Wenn der Stapelstatus „CREATE_COMPLETE“ anzeigt, klicken Sie auf „Ausgabe“. Klicken Sie auf die URL an der Position „Wert“, die dem „Schlüssel“ der „WebUI-URL“ entspricht.2. Rufen Sie die WebUI-Schnittstelle auf, geben Sie „Prompt“ ein und klicken Sie auf „Generieren“, um das Bild zu generieren.3.4.3 Verwenden der stabilen Diffusion-WebUIBenehmenZug(MikroMelodie So trainieren Sie Ihre eigenen Bilder mit der Stable Diffusion WebUI.

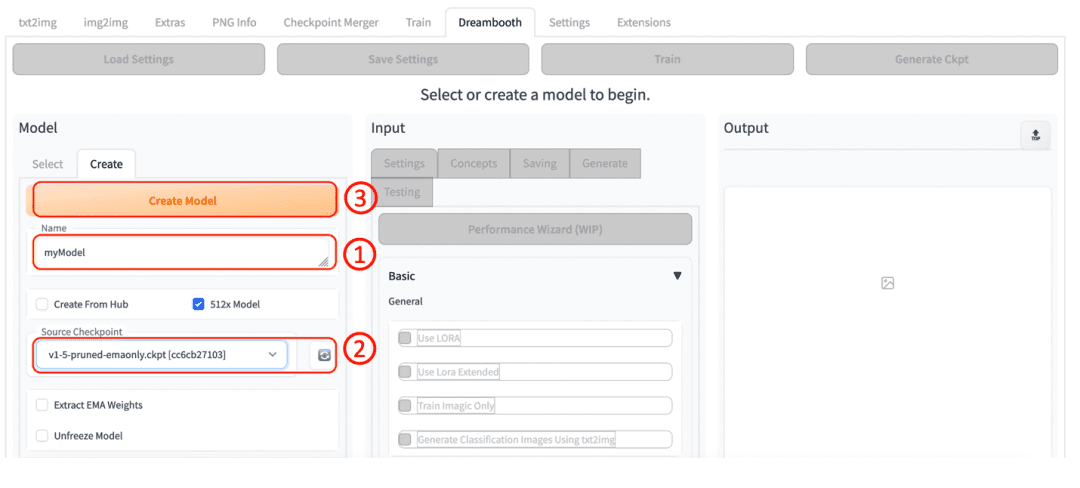

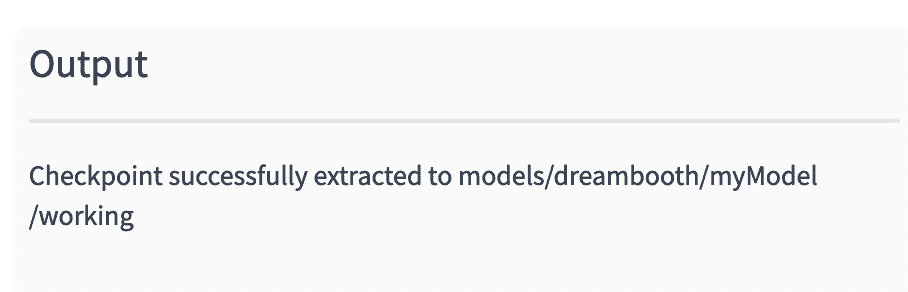

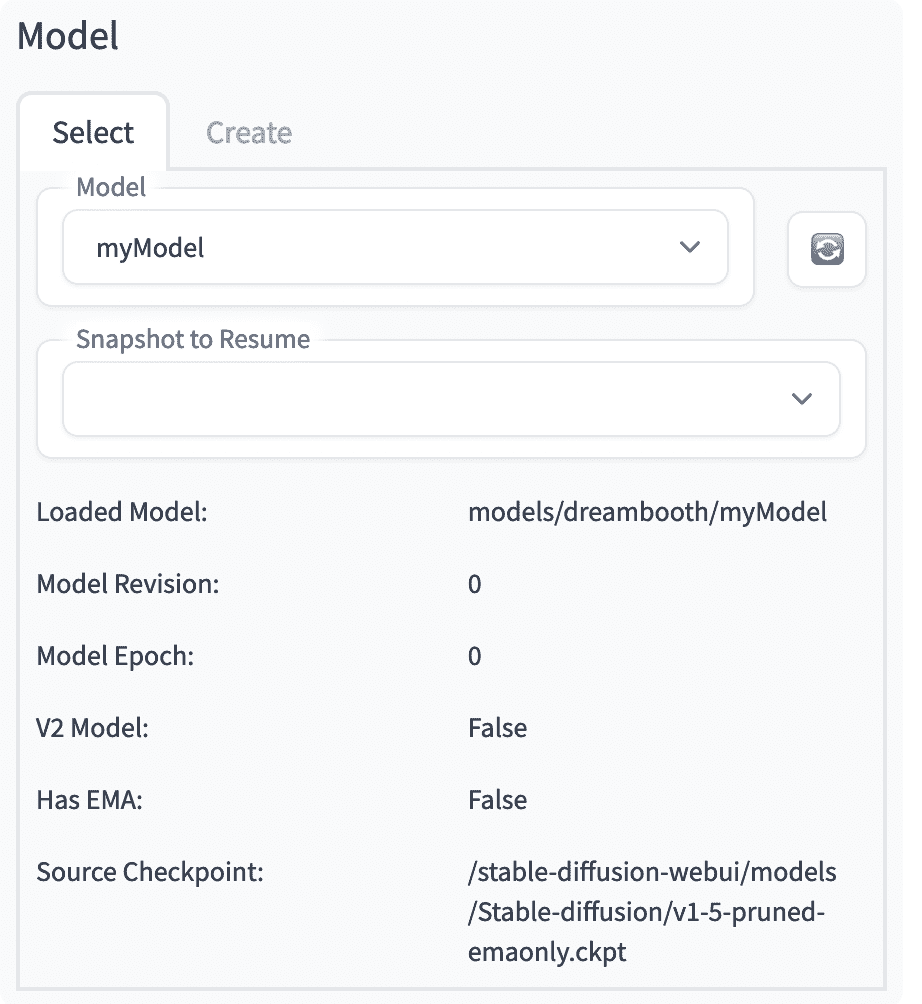

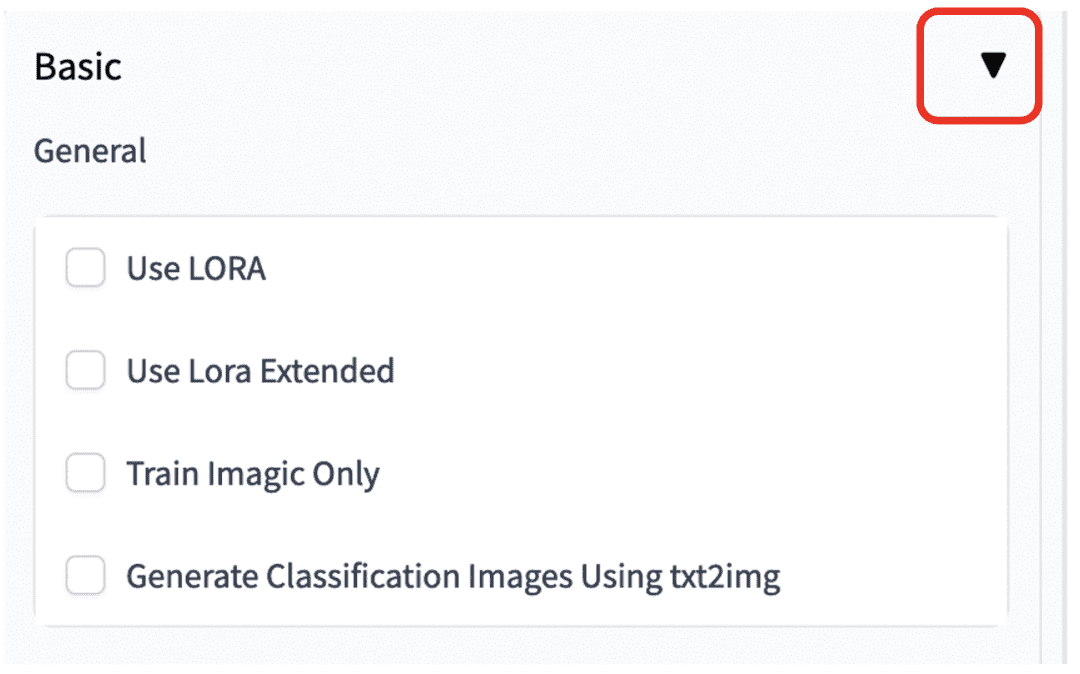

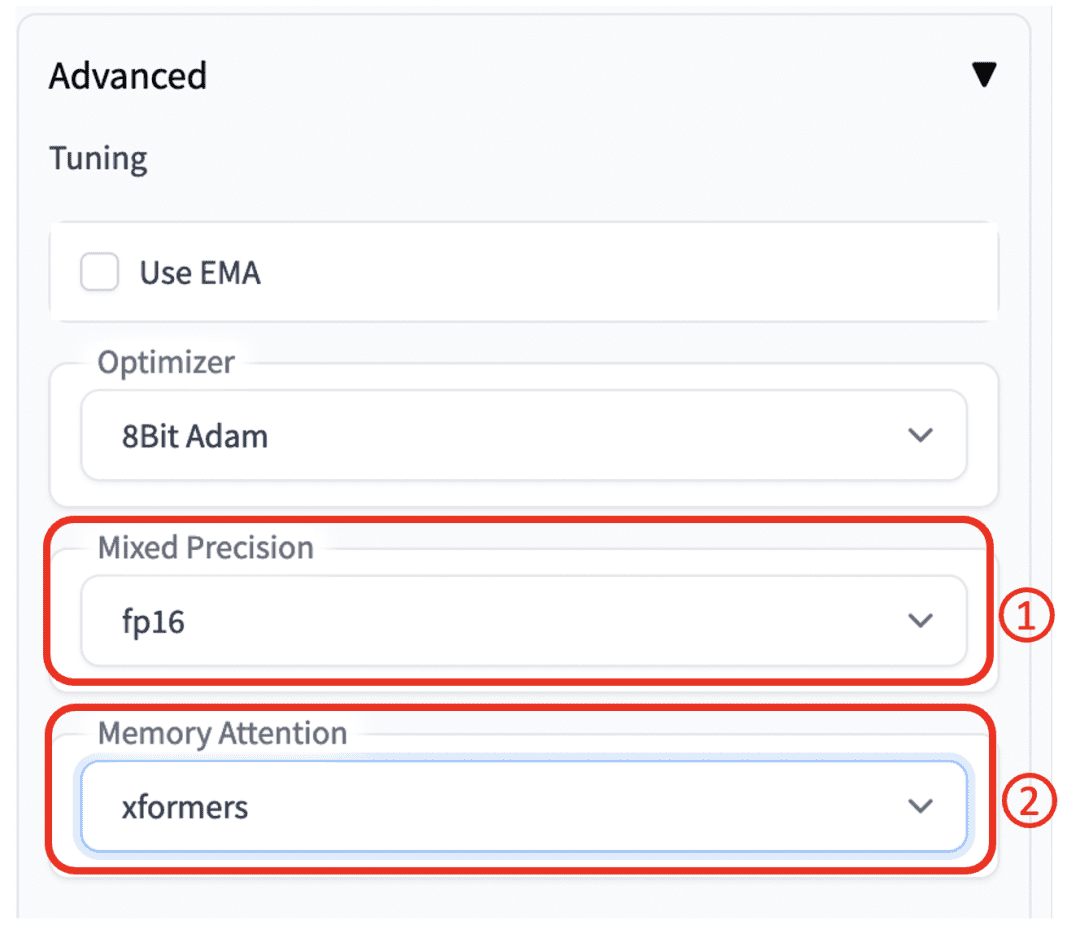

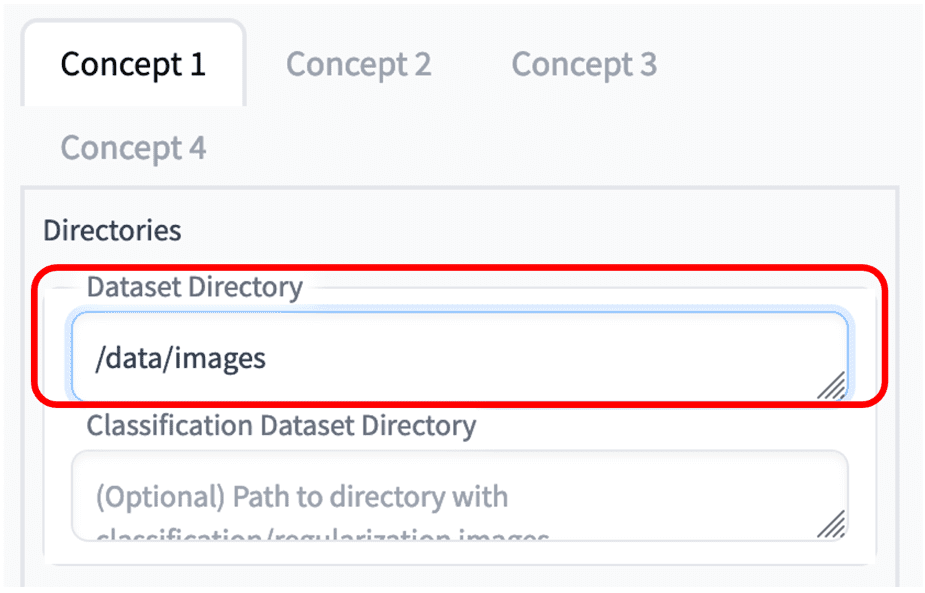

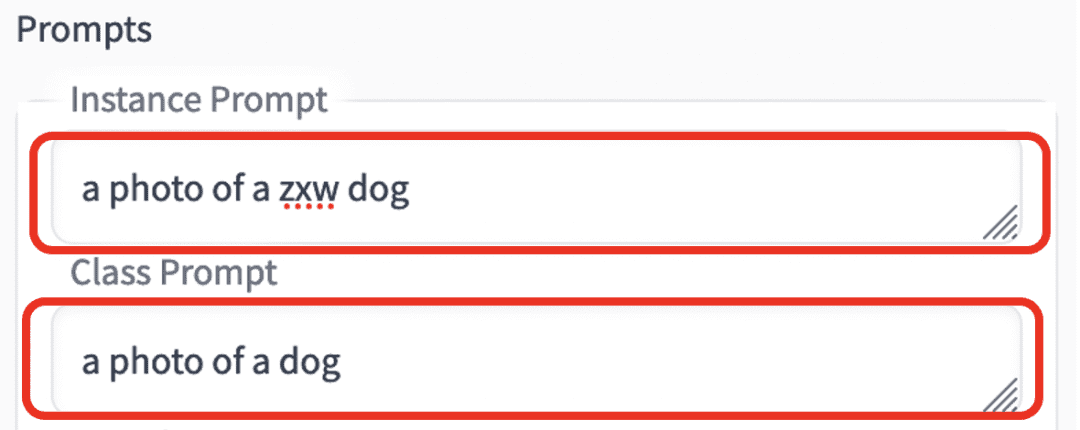

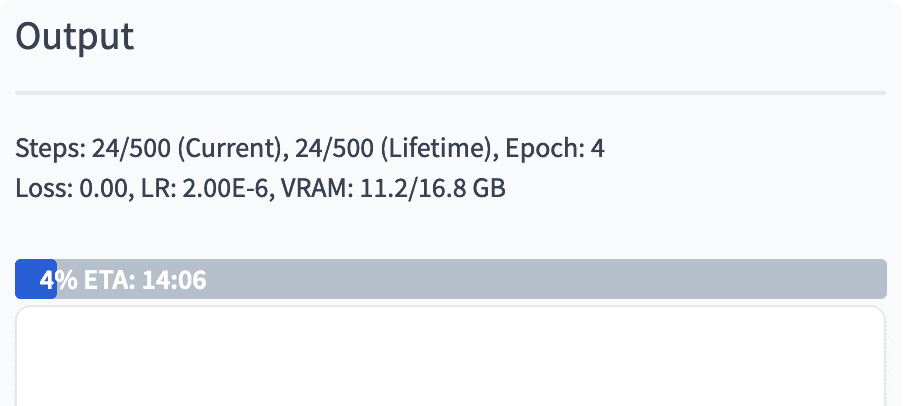

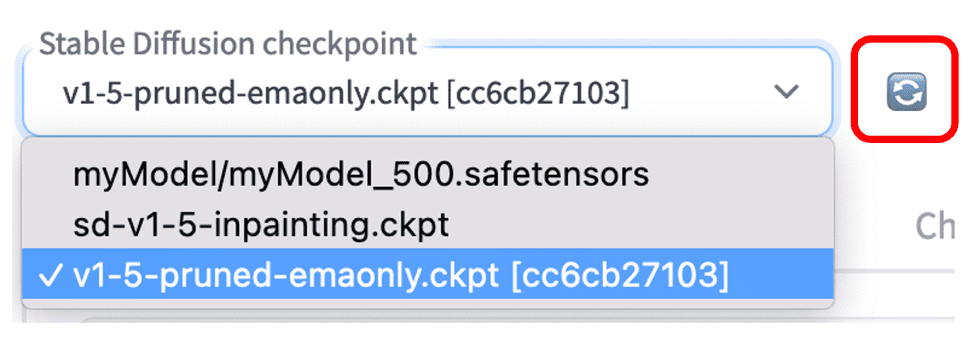

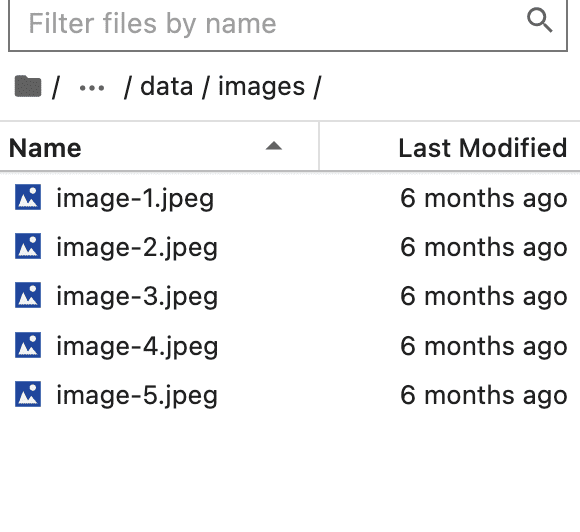

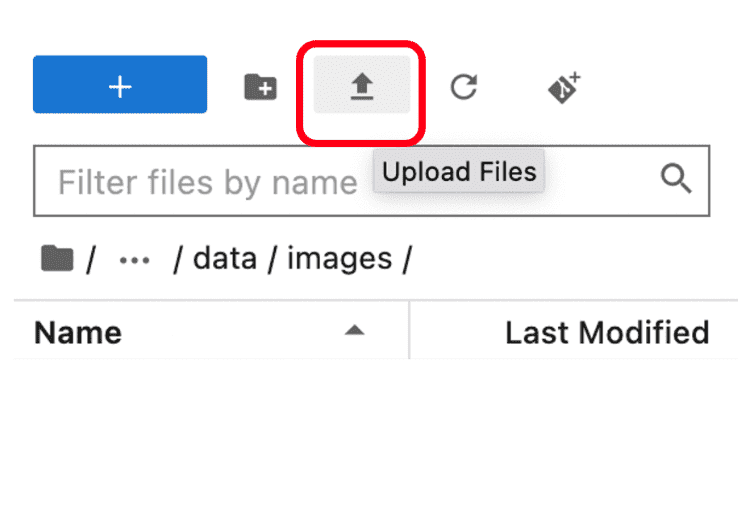

1. Erstellen Sie zunächst ein Modell und navigieren Sie zur DreamBooth-Seite.2. Nach erfolgreicher Erstellung, wie in der folgenden Abbildung dargestellt.3. Legen Sie die Trainingsparameter fest und navigieren Sie zur Auswahlseite, wie in der Abbildung gezeigt.4. Legen Sie auf der Eingabeseite die Einstellungen fest, behalten Sie die Standardparameter bei und klicken Sie auf den Pfeil rechts.5. Klicken Sie auf den Pfeil rechts neben „Advance“, um die Registerkarte zu erweitern. Wählen Sie „fp16“ unter „Mixed Precision“ und „xformers“ unter „Memory Attention“. Behalten Sie die anderen Optionen wie in der Abbildung unten gezeigt bei.6. Klicken Sie auf die Registerkarte „Konzepte“ und geben Sie das Verzeichnis mit den Beispielbildern im Dataset-Verzeichnis ein. Wir haben Beispielbilder bereits im Verzeichnis /data/images vorbereitet. Leser können auch eigene Bilddateien in diesem Verzeichnis ablegen.7. Scrollen Sie nach unten und geben Sie in der Instanzeingabeaufforderung „a photo of a zxw dog“ und in der Klasseneingabeaufforderung „a photo of dog“ ein. Behalten Sie die restlichen Standardwerte bei.8. Klicken Sie oben auf der Seite auf die Schaltfläche „Trainieren“.9. Beobachten Sie den Trainingsfortschritt auf der Registerkarte „Ausgabe“ auf der rechten Seite und warten Sie, bis das Training abgeschlossen ist.10. Klicken Sie nach Abschluss des Trainings auf die Schaltfläche „Aktualisieren“. Das neu trainierte Modell wird in der Modellliste angezeigt. Wählen Sie das neu trainierte Modell aus.11. Klicken Sie auf „txt2img“, um zur Vincent-Bildseite zu gelangen. Geben Sie „Prompt“ ein (beachten Sie, dass Sie das Präfix „zwx“ angeben müssen) und sehen Sie sich das Ergebnis an.12. So trainieren Sie mit Ihren eigenen Bildern. Klicken Sie in der Cloudfomation-Ausgabe auf den Link „NotebookURL“.13. Klicken Sie wie in der Abbildung unten gezeigt auf sd-webui, um den Ordner data/images/ aufzurufen. Klicken Sie mit der rechten Maustaste nacheinander auf die Dateien und löschen Sie sie.14. Klicken Sie auf Hochladen Klicken Sie auf die Schaltfläche „Dateien“, um Ihre eigenen Bilder als Trainingsdaten hochzuladen. Wiederholen Sie nach dem Hochladen die obigen Schritte, um den Trainingsprozess abzuschließen.

Dieser Artikel stellt kurz vor, wie Sie mit dem gehosteten Notebook-Dienst SageMaker Notebook die Stable Diffusion WebUI mit nur einem Klick bereitstellen und ganz einfach eine schnittstellenbasierte, schnelle Verifizierungsumgebung für KI-generierte Bilder erstellen. Die Lösung lässt sich mit wenigen Klicks automatisch bereitstellen. Dank des gehosteten Dienstes müssen Sie sich nicht um den Aufbau und Betrieb der zugrunde liegenden Infrastruktur kümmern und profitieren gleichzeitig von einer guten Open-Source-Projekterfahrung. Sie können auch Ihre eigenen Bilder verwenden, um das Modell zu optimieren und für individuelle AIGC-Anwendungen vorzubereiten.- https://docs.aws.amazon.com/sagemaker/latest/dg/nbi.html

- https://jupyter-contrib-nbextensions.readthedocs.io/en/latest/

- https://github.com/AbdBarho/stable-diffusion-webui-docker

- https://github.com/AUTOMATIC1111/stable-diffusion-webui

- https://github.com/invoke-ai/InvokeAI

Wenn Sie das praktische Experiment schnell ausprobieren möchten, scannen Sie den unten stehenden QR-Code, registrieren Sie ein Amazon Web Services-Konto, erhalten Sie kostenlose Cloud-Ressourcen im Wert von 200 $ und entdecken Sie den unendlichen Charme der KI-Malerei: