Hervorragende Software und praktische Tutorials

Schritt-für-Schritt-Anleitung zur Installation von io.net unter Windows und zum Anschließen neuer Geräte

io.net Cloud ist ein hochmodernes dezentrales Computernetzwerk, das Ingenieuren für maschinelles Lernen den Zugriff auf verteilte Cloud-Cluster zu einem Bruchteil der Kosten vergleichbarer zentralisierter Dienste ermöglicht.

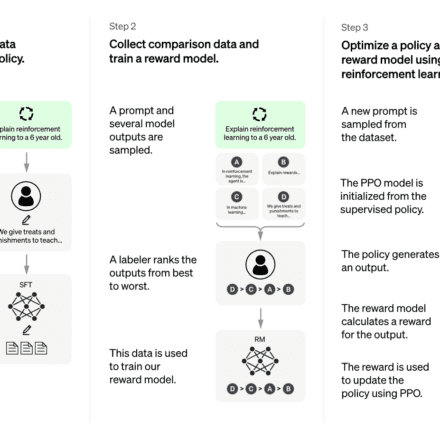

Moderne Machine-Learning-Modelle nutzen häufig die Vorteile paralleler und verteilter Rechenleistung. Es ist entscheidend, die Leistung mehrerer Kerne über mehrere Systeme hinweg zu nutzen, um die Leistung zu optimieren oder auf größere Datensätze und Modelle zu skalieren. Die Trainings- und Inferenzprozesse sind nicht nur einfache Aufgaben, die auf einem einzelnen Gerät ausgeführt werden, sondern erfordern oft ein koordiniertes Netzwerk zusammenarbeitender GPUs.

Da in öffentlichen Clouds mehr GPUs benötigt werden, ist die Beschaffung verteilter Rechenressourcen leider mit einigen Herausforderungen verbunden. Zu den wichtigsten davon zählen:

- Eingeschränkte Verfügbarkeit:Der Zugriff auf Hardware über Cloud-Dienste wie AWS, GCP oder Azure dauert oft Wochen und gängige GPU-Modelle sind oft nicht verfügbar.

- Schlechte Entscheidungen: Benutzer haben kaum Auswahlmöglichkeiten hinsichtlich GPU-Hardware, Standort, Sicherheitsstufe, Latenz und anderen Optionen.

- Hohe Kosten:Die Anschaffung guter GPUs ist teuer und Projekte können leicht Hunderttausende von Dollar pro Monat für Training und Inferenz ausgeben.

io.net löst dieses Problem durch die Aggregation von GPUs aus wenig genutzten Quellen wie unabhängigen Rechenzentren, Krypto-Minern und Krypto-Projekten wie Filecoin und Render. Diese Ressourcen werden im Decentralized Physical Infrastructure Network (DePIN) gebündelt und ermöglichen Ingenieuren den Zugriff auf enorme Rechenleistung in einem System, das zugänglich, anpassbar, kostengünstig und einfach zu implementieren ist.

io.net-Dokumentation:https://developers.io.net/docs/overview

Tutorial zur Installation von io.net und zum Anschließen eines neuen Geräts

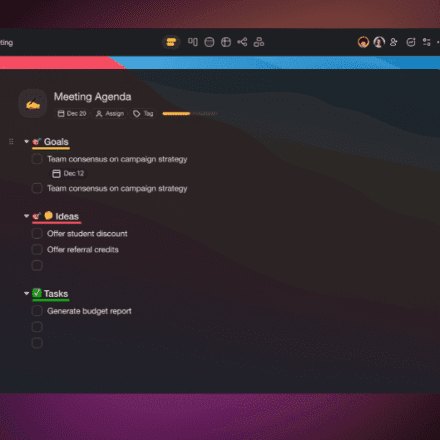

Gehen Sie zuerst zucloud.io.net Melden Sie sich mit Ihrer Google-E-Mail oder Ihrem X-Konto bei io.net an

1. Navigieren Sie im Dropdown-Menü zu WORKER

2. Schließen Sie ein neues Gerät an

Klicken Sie auf „Neues Gerät verbinden“

3. Wählen Sie einen Lieferanten

Wählen Sie den Anbieter aus, in den Sie Ihre Hardware gruppieren möchten

4. Benennen Sie Ihr Gerät

Geben Sie Ihrem Gerät einen eindeutigen Namen, idealerweise in einem Format ähnlich dem folgenden: Mein-Testgerät

5. Wählen Sie das Betriebssystem "OS"

Klicken Sie auf das Windows-Feld

6. Gerätetyp

Wenn Sie GPU Worker auswählen und Ihr Gerät keine GPU hat, schlägt die Einrichtung fehl

7. Docker- und Nvidia-Treiberinstallation

Befolgen Sie die Schritte in unserer Dokumentation zur Installation von Docker-, Cuda- und Nvidia-Treibern

8. Docker-Befehle ausführen

Führen Sie diesen Befehl im Terminal aus und stellen Sie sicher, dass Docker Desktop im Hintergrund ausgeführt wird

9. Warten Sie auf die Verbindung

Klicken Sie weiter auf „Aktualisieren“, während Sie darauf warten, dass neue Geräte eine Verbindung herstellen.

Docker-Installation unter Windows

Zuerst müssen Sie das virtualisierte BIOS aktivieren.

Um zu überprüfen, ob es aktiviert ist, gehen Sie zu „Task-Manager-Leistung“, dort wird es Ihnen hier angezeigt:

Wenn es nicht aktiviert ist, führen Sie die folgenden Schritte aus:

- Um die Virtualisierungstechnologie im BIOS oder UEFI-Setup zu aktivieren, müssen Sie während des Bootvorgangs auf das BIOS- oder UEFI-Konfigurationsmenü Ihres Computers zugreifen. Die genauen Schritte können je nach Hersteller und Modell Ihres Computers variieren. Hier sind die allgemeinen Schritte zur Aktivierung der Virtualisierung.

- Installieren Sie WSL 2, indem Sie PowerShell als Administrator öffnen. Suchen Sie dazu im Startmenü nach „PowerShell“, klicken Sie mit der rechten Maustaste auf „Windows PowerShell“ und wählen Sie „Als Administrator ausführen“.

- Führen Sie den folgenden Befehl aus, um die WSL-Funktionalität in Windows 10/11 zu aktivieren:

dism.exe /online /enable-feature /featurename:Microsoft-Windows-Subsystem-Linux /all /norestart

- Aktivieren Sie dann die Funktion „Virtual Machine Platform“ im selben PowerShell-Fenster, indem Sie den folgenden Befehl ausführen:

dism.exe /online /enable-feature /featurename:VirtualMachinePlatform /all /norestart

- Legen Sie dann WSL 2 als Standardversion fest (manchmal müssen Sie Ihren Computer möglicherweise neu starten):

wsl --set-default-version 2

Docker herunterladen:

Besuchen Sie die Docker-Website:https://www.docker.com/products/docker-desktop/ und klicken Sie auf „Download für Windows“:

Führen Sie den Installationsvorgang aus und starten Sie den Computer nach Abschluss neu:

Starten Sie den Docker-Desktop und wählen Sie wsl2 zur Integration in Docker aus:

Überprüfen Sie die Installation, indem Sie CMD öffnen und eingeben

docker --version

Sie erhalten dann folgende Ausgabe

Docker-Version 24.0.6, Build ed223bc

Das war’s. Docker ist installiert und bereit.

Nvidia-Treiberinstallation unter Windows

- Um zu überprüfen, ob Sie den richtigen Treiber haben, öffnen Sie eine Kommandozeile auf Ihrem Windows-PC (Windows-Taste + R, geben Sie cmd ein) und geben Sie Folgendes ein: nvidia-smi . Falls die folgende Fehlermeldung angezeigt wird:

C:\Benutzer>nvidia-smi „nvidia-smi“ wird nicht als interner oder externer Befehl, ausführbares Programm oder Batchdatei erkannt.

Dies bedeutet, dass die NVIDIA-Treiber nicht installiert sind. Gehen Sie folgendermaßen vor, um sie zu installieren:

- Besuchen Sie die Nvidia-Website:https://www.nvidia.com/download/index.aspxund geben Sie den Namen Ihrer GPU ein und klicken Sie auf Suchen:

- Klicken Sie auf die Schaltfläche „Herunterladen“, um den entsprechenden NVIDIA-Treiber für Ihre GPU und Windows-Version zu erhalten.

- Sobald der Download abgeschlossen ist, starten Sie die Installation, wählen Sie die erste Option aus und klicken Sie auf „Zustimmen und fortfahren“.

- Nach Abschluss der Installation müssen Sie Ihren Computer neu starten. Durch den Neustart wird sichergestellt, dass der neue NVIDIA-Treiber vollständig in Ihr System integriert wird.

- Öffnen Sie nach dem Neustart Ihres Computers eine Eingabeaufforderung (Windows-Taste + R, geben Sie cmd ein) und geben Sie den folgenden Befehl ein:

nvidia-smi

- Sie sollten ein Ergebnis wie das folgende sehen:

Das war’s. Sie haben die richtigen NVIDIA-Treiber installiert und können loslegen.

CUDA Toolkit herunterladen (optional)

- Besuchen Sie die Downloadseite des NVIDIA CUDA Toolkit:https://developer.nvidia.com/cuda-downloads

- Wählen Sie Ihr Betriebssystem (z. B. Windows) aus.

- Wählen Sie Ihre Architektur (normalerweise x86_64 für 64-Bit-Windows).

- Laden Sie das lokale EXE-Installationsprogramm herunter. Führen Sie nach dem Herunterladen das Installationsprogramm aus:

- Und folgen Sie dem Installationsvorgang.

- Überprüfen Sie anschließend den Installationsvorgang. Öffnen Sie eine Eingabeaufforderung (Windows-Taste + R, geben Sie cmd ein) und geben Sie den folgenden Befehl ein:

nvcc --version

- Sie sollten die folgende Antwort erhalten:

nvcc: NVIDIA (R) Cuda-Compilertreiber Copyright (c) 2005–2022 NVIDIA Corporation. Erstellt am Wed_Sep_21_10:41:10_Pacific_Daylight_Time_2022. Cuda-Kompilierungstools, Version 11.8, V11.8.89. Build cuda_11.8.r11.8/compiler.31833905_0

Das war's. Sie haben das CUDA Toolkit installiert und können loslegen.

Beachten Sie, dass wir jetzt einen 20 GB großen Container installieren, der alle für unsere ML-Anwendung benötigten Pakete enthält. Alles geschieht innerhalb des Containers, und nichts wird vom Container in das Dateisystem übertragen.

Handbuch zur Fehlerbehebung

Leitfaden zur Fehlerbehebung für GPU-fähige Docker-Plattformen

Überprüfen des Docker-Setups unter Linux und Windows

- Um zu überprüfen, ob Ihr Setup ordnungsgemäß funktioniert, führen Sie Folgendes aus:

docker run --gpus all nvidia/cuda:11.0.3-base-ubuntu18.04 nvidia-smi

- Die Ausgabe sollte ähnlich wie nvidia-smi sein.

- Dieser Befehl prüft, ob Docker Ihre GPU richtig nutzt.

Haltestellenplattform

Windows (mit PowerShell):

docker ps -a -q | FürJeden { docker rm $\_ }Unzuverlässige Betriebszeit unter Windows?

Um sicherzustellen, dass die DHCP-Lease-Zeit des Routers länger als 24 Stunden ist, rufen Sie den Gruppenrichtlinien-Editor im Windows-Betriebssystem auf. Aktivieren Sie die angegebenen Einstellungen in der folgenden Reihenfolge:

- Navigieren Sie im Gruppenrichtlinien-Editor zu „Computerkonfiguration“.

- Suchen Sie in der Computerkonfiguration nach dem Abschnitt „Administrative Vorlagen“.

- Navigieren Sie im Abschnitt „Administrative Vorlagen“ zu „System“.

- Wählen Sie im Systemmenü die Option „Energieverwaltung“ aus.

- Greifen Sie abschließend auf den Unterabschnitt „Ruhezustandseinstellungen“ in der Energieverwaltung zu.

- Aktivieren Sie im Untermenü „Ruhezustandseinstellungen“ die Optionen „Netzwerkverbindungen während verbundenem Standby (im Akkubetrieb) zulassen“ und „Netzwerkverbindungen während verbundenem Standby (an der Steckdose) zulassen“.

- Stellen Sie sicher, dass Sie diese Konfigurationen entsprechend anpassen, um die gewünschten Ergebnisse zu erzielen.

Welche Ports müssen in der Firewall freigegeben werden, damit die Plattform ordnungsgemäß funktioniert: (Linux und Windows)

TCP: 443 25061 5432 80

UDP: 80 443 41641 3478

Wie kann ich überprüfen, ob das Programm erfolgreich gestartet wurde?

Wenn Sie die folgenden Befehle auf Powershell (Windows) oder Terminal (Linux) ausführen, sollten immer 2 Docker-Container ausgeführt werden:

Docker PS

Wenn nach der Ausführung des Befehls docker run -d ... auf der Website kein Container oder nur ein Container ausgeführt wird:

Stoppen Sie die Plattform (siehe Befehlsanleitung oben) und starten Sie die Plattform erneut mit dem Website-Befehl

Wenn dies immer noch nicht funktioniert, wenden Sie sich bitte an unsere Discord-Community, um Hilfe zu erhalten:https://discord.com/invite/kqFzFK7fg2

Von io.net unterstützte Geräte

| Hersteller | GPU-Modell |

|---|---|

| NVIDIA | A10 |

| NVIDIA | A100 80G PCIe NVLink |

| NVIDIA | A100 80 GB PCIe |

| NVIDIA | A100-PCIE-40GB |

| NVIDIA | A100-SXM4-40GB |

| NVIDIA | A40 |

| NVIDIA | A40 PCIe |

| NVIDIA | A40-8Q |

| NVIDIA | GeForce RTX 3050 Laptop |

| NVIDIA | GeForce RTX 3050 Ti Laptop |

| NVIDIA | GeForce RTX 3060 |

| NVIDIA | GeForce RTX 3060 Laptop |

| NVIDIA | GeForce RTX 3060 Ti |

| NVIDIA | GeForce RTX 3070 |

| NVIDIA | GeForce RTX 3070 Laptop |

| NVIDIA | GeForce RTX 3070 Ti |

| NVIDIA | GeForce RTX 3070 Ti Laptop |

| NVIDIA | GeForce RTX 3080 |

| NVIDIA | GeForce RTX 3080 Laptop |

| NVIDIA | GeForce RTX 3080 Ti |

| NVIDIA | GeForce RTX 3080 Ti Laptop |

| NVIDIA | GeForce RTX 3090 |

| NVIDIA | GeForce RTX 3090 Ti |

| NVIDIA | GeForce RTX 4060 |

| NVIDIA | GeForce RTX 4060 Laptop |

| NVIDIA | GeForce RTX 4060 Ti |

| NVIDIA | GeForce RTX 4070 |

| NVIDIA | GeForce RTX 4070 Laptop |

| NVIDIA | GeForce RTX 4070 SUPER |

| NVIDIA | GeForce RTX 4070 Ti |

| NVIDIA | GeForce RTX 4070 Ti SUPER |

| NVIDIA | GeForce RTX 4080 |

| NVIDIA | GeForce RTX 4080 SUPER |

| NVIDIA | GeForce RTX 4090 |

| NVIDIA | GeForce RTX 4090 Laptop |

| NVIDIA | H100 80G PCIe |

| NVIDIA | H100 PCIe |

| NVIDIA | L40 |

| NVIDIA | Quadro RTX 4000 |

| NVIDIA | RTX 4000 SFF Ada-Generation |

| NVIDIA | RTX 5000 |

| NVIDIA | RTX 5000 Ada-Generation |

| NVIDIA | RTX 6000 Ada-Generation |

| NVIDIA | RTX 8000 |

| NVIDIA | RTX A4000 |

| NVIDIA | RTX A5000 |

| NVIDIA | RTX A6000 |

| NVIDIA | Tesla P100 PCIe |

| NVIDIA | Tesla T4 |

| NVIDIA | Tesla V100-SXM2-16GB |

| NVIDIA | Tesla V100-SXM2-32GB |

CPU

| Hersteller | CPU-Modell |

|---|---|

| Apfel | M1 Pro |

| Apfel | M1 |

| Apfel | M1 Max |

| Apfel | M2 |

| Apfel | M2 Max |

| Apfel | M2 Pro |

| Apfel | M3 |

| Apfel | M3 Max |

| Apfel | M3 Pro |

| AMD | QEMU Virtual CPU Version 2.5+ |