Hervorragende Software und praktische Tutorials

So verwenden Sie Grounded-SAM in Amazon SageMaker

So erstellen Sie schnell eine gehostete KI-Malvisualisierungsumgebung basierend auf SageMaker Notebook.

1. Neue Funktionen der Lösung: Unterstützung für ControlNet- und Image-Browser-Plug-Ins;

2. In der E-Commerce-/Werbebranche ist die neue Version dieser Lösung mit den neuesten visuellen Tools ausgestattet Grounded-SAM, generieren Sie steuerbaren Text und Bilder, um die Ausgabe von Marketingmaterialien zu beschleunigen;

3. Häufige Fragen und Antworten zu diesem Programm.

Wir empfehlen, die Lösung in der Region „us-east-1“ in der Region „USA Ost“ bereitzustellen und je nach Bedarf den Instanztyp der Serie „ml.g4“ oder „ml.g5“ auszuwählen.

Melden Sie sich für eine kostenlose Testversion von Amazon Web Services anAWS)Link zum Cloud-Dienst: https://aws.amazon.com/cn/free/

Teil I: Neue Funktionen

1 Erweiterungen und Plugins

1.1 ControlNet

ControlNet basiert auf Stabile Diffusion WebUI Ein von ControlNet eingeführtes Plug-in, das eine neue Steuerungsmethode für die Wenshengtu-Funktion einführt. Diese ermöglicht zusätzlich die Steuerung der Körperhaltung, Tiefenschärfe, Linienzeichnung usw. der Figur und ermöglicht eine stabilere Steuerung des Ausgabebildschirms. ControlNet trainiert Modelle für verschiedene Eingabetypen. Derzeit sind die folgenden acht Modelle öffentlich verfügbar: Canny, Depth, Hed, MLSD, Normal, OpenPose, Scribble und Segmentation. Die Modellbeschreibung finden Sie in der folgenden Tabelle.

| Vorverarbeitungsname | Entsprechendes Modell | Modellbeschreibung |

| schlau | control_canny | Kantenerkennung. Extrahieren Sie Strichzeichnungen aus dem Originalbild, um ein Bild mit derselben Komposition zu erstellen. |

| Tiefe | Kontrolltiefe | Tiefenerkennung: Erfassen Sie die Tiefe des Bildes und ermitteln Sie die Beziehung zwischen Vordergrund und Hintergrund des Bildes. |

| er | control_hed | Kantenerkennung, behält aber mehr Details bei, geeignet zum Neufärben und Stilisieren. |

| mlsd | Steuerung_mlsd | Die Liniensegmenterkennung ist bei der Erkennung von Personen äußerst schlecht, eignet sich jedoch sehr gut für die Architektur. |

| normal_map | Steuerung_normal | Generieren Sie Normal Maps basierend auf Bildern, sehr gut geeignet für CG-Modellierer. |

| offene Pose | control_openpose | Extrahieren Sie die Skelettposen der Figur. |

| openpose_hand | control_openpose | Extrahieren Sie Charakter + Handskelettpose. |

| kritzeln | control_openpose | Extrahieren Sie einen Schwarzweißentwurf. |

| gefälschtes Gekritzel | control_scribble | Extraktion im Graffiti-Stil (sehr leistungsfähiges Modell). |

| Segmentierung | Steuersegment | Semantische Segmentierung. |

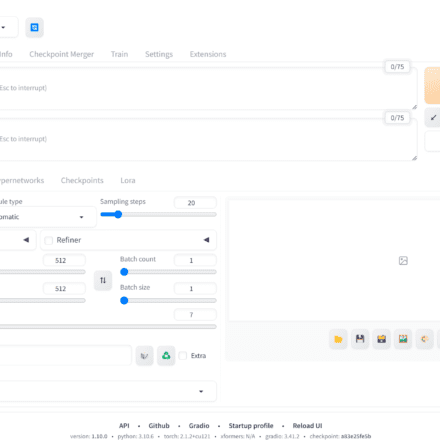

Die neueste Version dieser Lösung, WebUIVersion 0405, unterstützt standardmäßig das ControlNet-Plugin (siehe FAQ 1 in Teil 3 dieses Artikels). Folgen Sie einfach den unten stehenden Schritten, um das Modell herunterzuladen und das ControlNet-Plugin sofort zu nutzen.

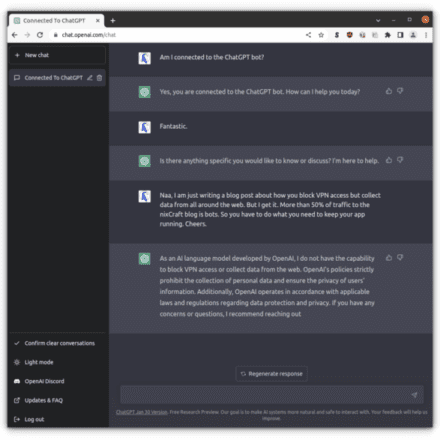

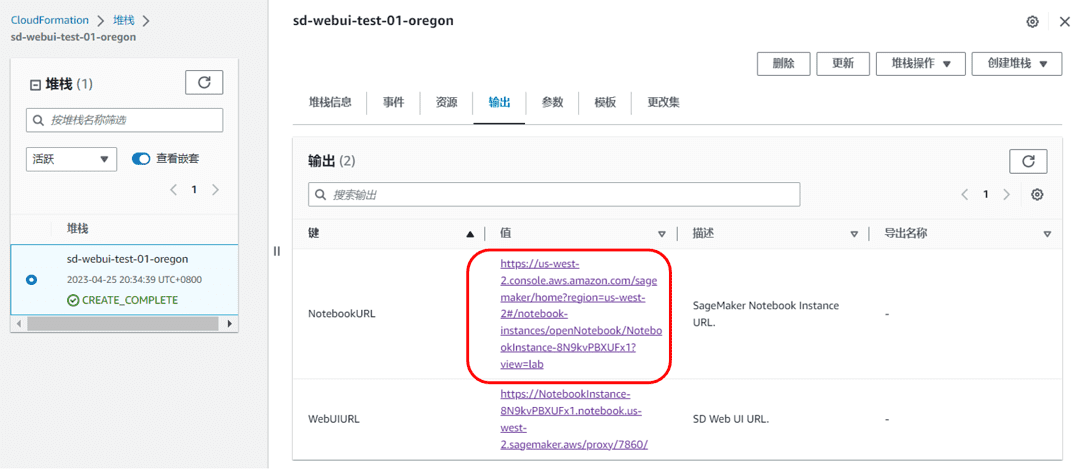

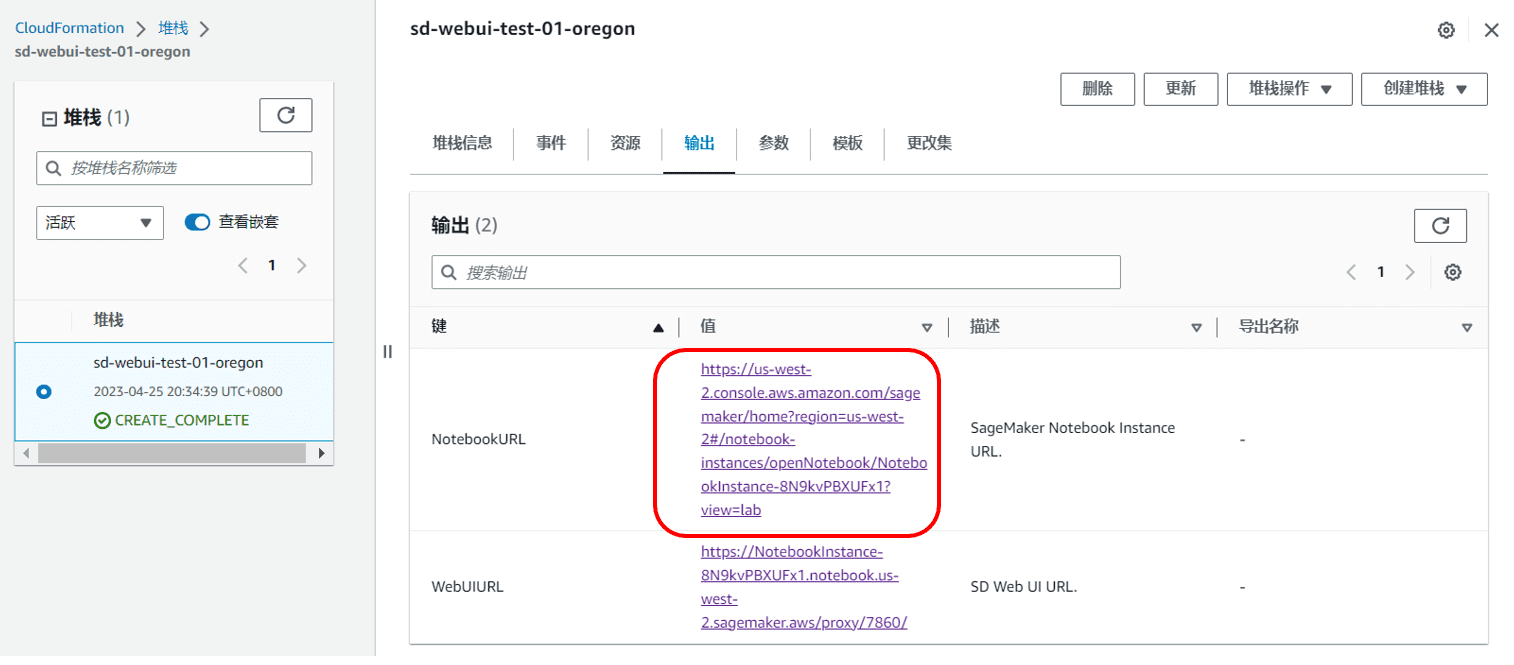

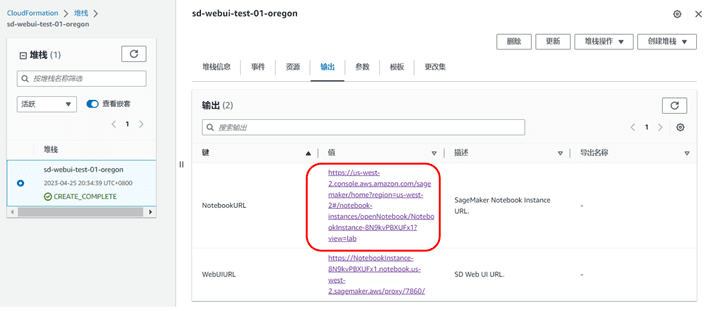

- In CloudFormation-Stack-Output (ReferenzVorheriger Blog 4.3 Schritt 12), suchen Sie den NotebookURL-Link und öffnen Sie die SageMaker Notebook-Instanz

|

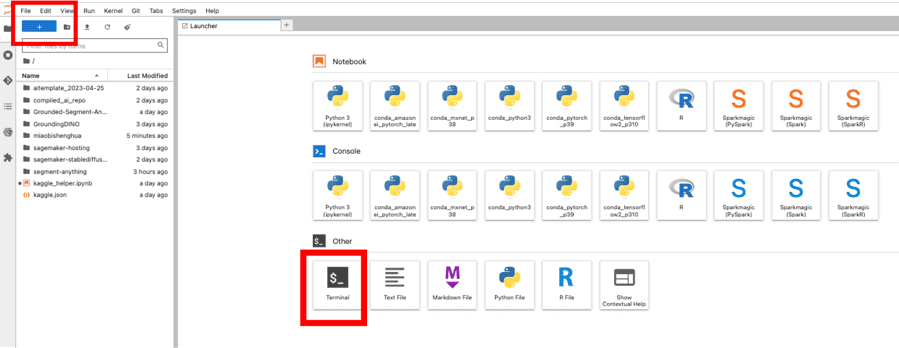

- Öffnen Sie ein Terminal und klicken Sie auf Datei->Neu->Terminal

- Geben Sie den folgenden Befehl ein, um den Download zu starten. Die Downloadzeit hängt vom Netzwerkstatus des Servers ab.

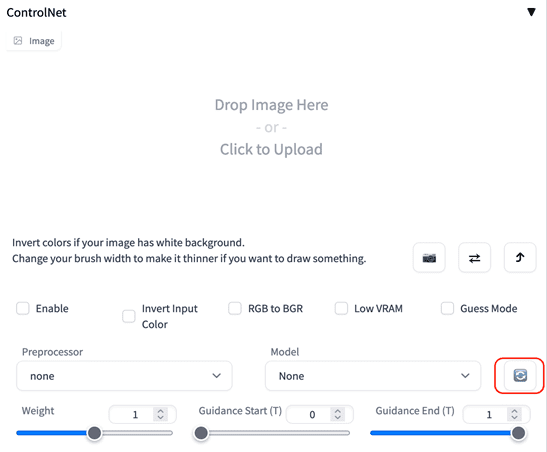

- Warten Sie, bis der Download abgeschlossen ist, kehren Sie zur Stable Diffusion-Web-UI-Oberfläche zurück und klicken Sie in ControlNet auf die Schaltfläche „Aktualisieren“, um den Download und die Installation des Modells abzuschließen.

|

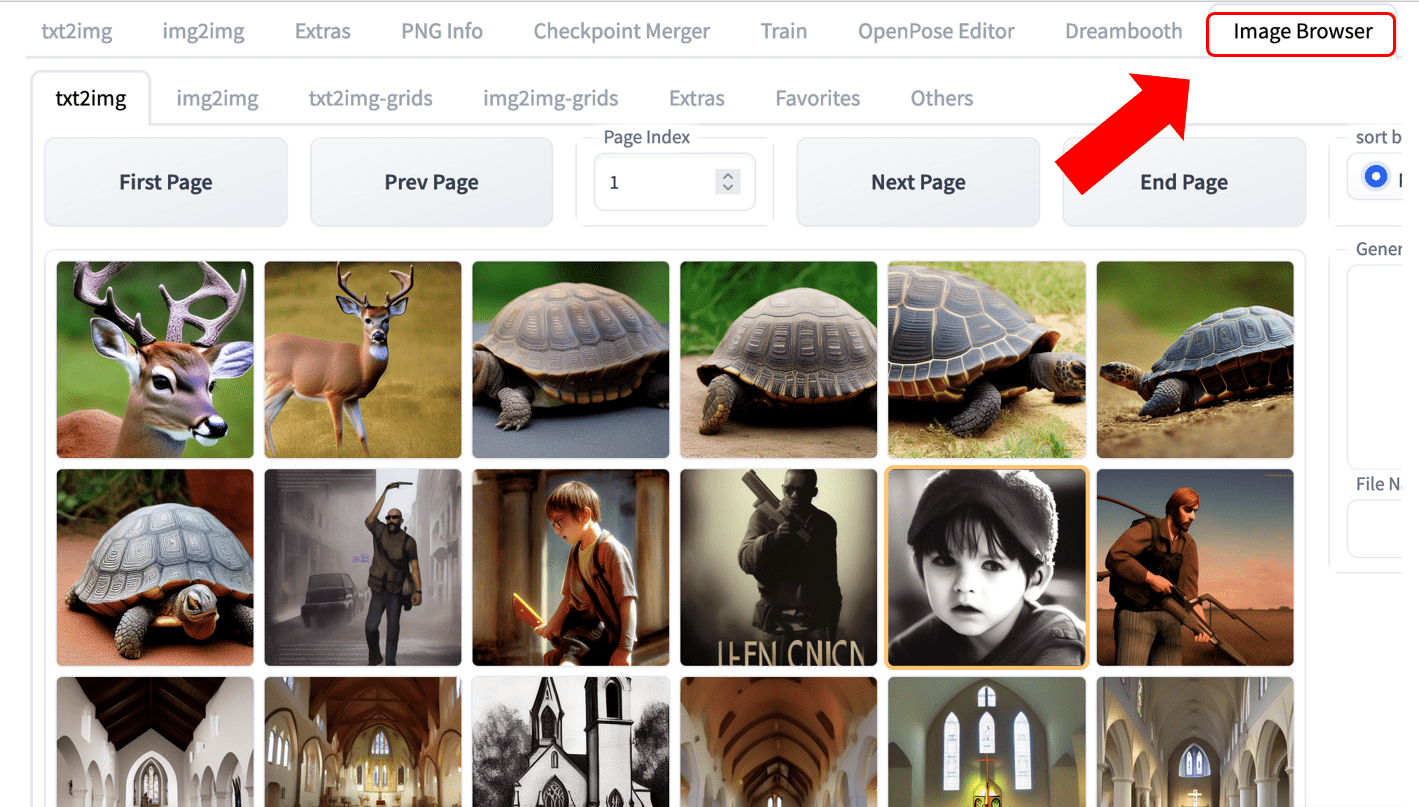

1.2 Bildbrowser

Neue Unterstützung für das Image Browser-Plugin. Sie können die generierten historischen Bilder einfach anzeigen, wie in der folgenden Abbildung gezeigt.

|

2 Regionale Unterstützung

Region USA West (Oregon) hinzugefügt

Teil 2: Kreative Generation für E-Commerce-Werbung

1 Hintergrund

Bei der Erstellung von E-Commerce-Bildmaterial besteht eine häufige Aufgabe darin, bestimmte Bildteile zu verändern. Früher mussten Designer hierfür professionelle Bildbearbeitungssoftware verwenden und viel Zeit investieren. Mit den aktuellen KI-Funktionen lässt sich diese Aufgabe jedoch einfacher und effizienter erledigen.

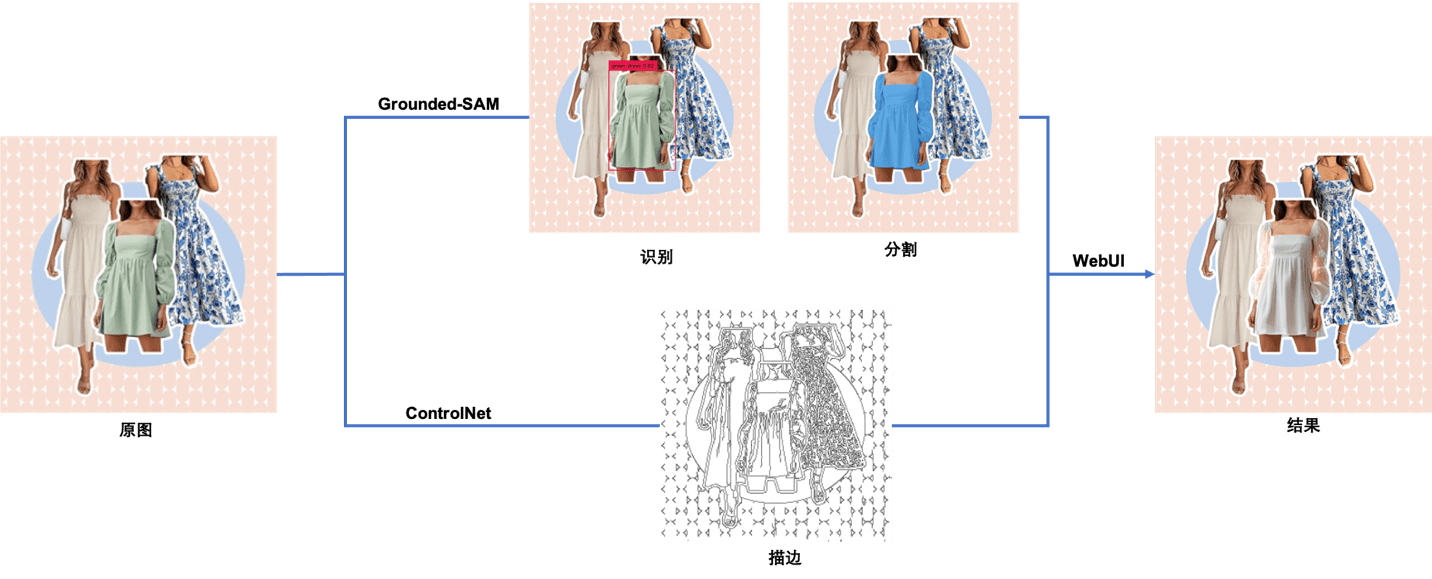

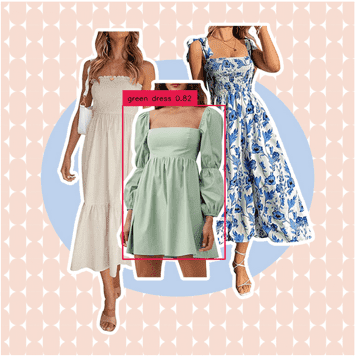

In diesem Artikel zeigen wir Ihnen, wie Sie mit Stable Diffusion WebUI und Grounded-SAM auf der neuen Version von Shenghuamiaobi den in der folgenden Abbildung gezeigten End-to-End-Bildbearbeitungseffekt erzielen, einschließlich 1. Kein CodeBildbearbeitung implementieren (Manuelle Maske), geeignet für Designer und Entwickler, die mit der Code-Entwicklung nicht vertraut sind, und 2. Exploit-CodeAutomatische Bildbearbeitung (Automatische Maske), geeignet für Entwickler und Enthusiasten, die sich für AIGC interessieren.

|

Das Originalbild stammt aus dem Internet

2. Verwendung des Lösungsmodells

In diesem Artikel verwenden wir die folgenden Modelle.

2.1 Realistische Vision

Realistische Vision Bezieht sich auf ein Modell, das realistische Bilder erzeugt. Es kann äußerst realistische Porträts von Menschen unterschiedlichen Alters, unterschiedlicher Herkunft und mit unterschiedlichem Kleidungsstil erstellen, die wie Fotos aussehen.

2.2 ControlNet

ControlNet Es handelt sich um ein vortrainiertes Modell basierend auf Stable Diffusion 1.5. In der Arbeit von Autor Lvmin Zhang wird erläutert, dass ControlNet ein groß angelegtes Diffusionsmodell ist, das vortrainiert und durch Eingabebedingungen gesteuert wird. Es kann die Kanten-, Tiefen- und Skelettmerkmale der menschlichen Körperhaltung im Eingabebild nutzen und in Kombination mit Textaufforderungen die Bildgenerierungsergebnisse in SD 1.5 präzise steuern. ControlNet verfügt über insgesamt acht Modelle. In diesem Artikel wird das Modell Control_canny verwendet.

2.3 Grounded-SAM

Geerdetes Segment – Alles(Grounded-SAM) basiert auf Erdung DINO(Detektor) und Segmentieren Sie alles Der von Model (Segmenter) erstellte multimodale Bildgenerierungs-Workflow ist ein beliebtes Open-Source-Projekt. Grounded-SAM kann direkt mit Stable Diffusion zur steuerbaren Text- und Bildgenerierung verwendet werden.

2.3.1 Erdung DINO

Erdung DINO: Ein Zero-Shot-Bilderkennungsmodell, das Objekte in einem Bild anhand von Textbeschreibungen erkennen und rechteckige Kästchen generieren kann.

2.3.2 Segment Anything-Modell (SAM)

Segmentieren Sie alles Modell (SAM): Ein hochwertiges Bildsegmentierungsmodell, das Bildsegmentierungen mithilfe von Hilfspunkten und Hilfsboxen als Eingabeaufforderungen durchführen kann. Sein Trainingsset umfasst mehr als eine Milliarde Masken und elf Millionen Bilder und ist damit der bislang größte Open-Source-Datensatz für Bildsegmentierung. Offizielle Stellen behaupten, dass SAM das allgemeine Konzept „was ein Objekt ist“ gelernt hat und daher Bildsegmentierungen ohne zusätzliches Training durchführen kann.

3. Codefreie Bildbearbeitung (manuelle Maskierung)

Die experimentellen Schritte sind wie folgt:

3.1 Leser können klickenHierLaden Sie die in diesem Experiment verwendeten Bilder herunter.

3.2 Suchen Sie in CloudFormation-Stack-Output den NotebookURL-Link und öffnen Sie die SageMaker-Notebook-Instanz.

|

3.3 Klicken Sie auf „Terminal“ und geben Sie nacheinander die folgenden Befehle ein, um das Modell Realistic Vision V1.3 herunterzuladen.

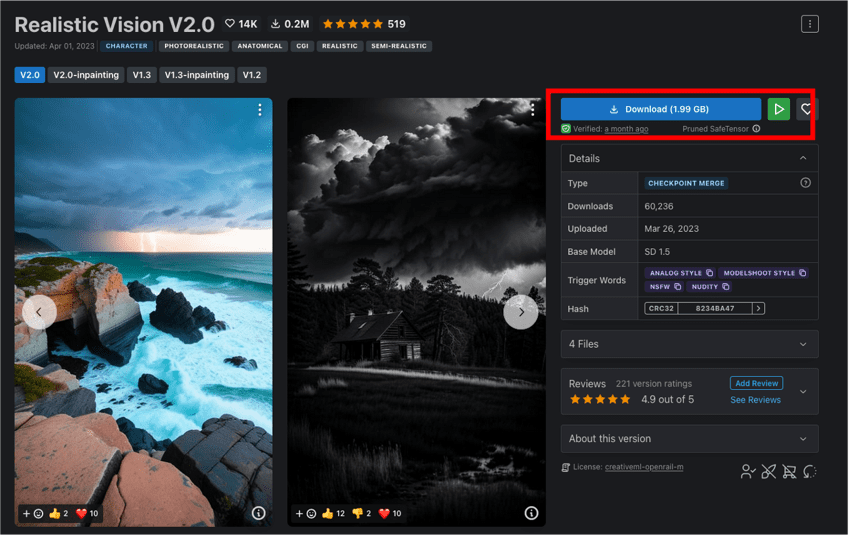

Im obigen Skript haben wir HuggingFace verwendet Realistische Vision V1.3 Modell. Sie können es auch direkt von der offiziellen CIVITAI-Website herunterladen Realistische Vision V2.0, die endgültigen Effekte der beiden sind sehr ähnlich.

|

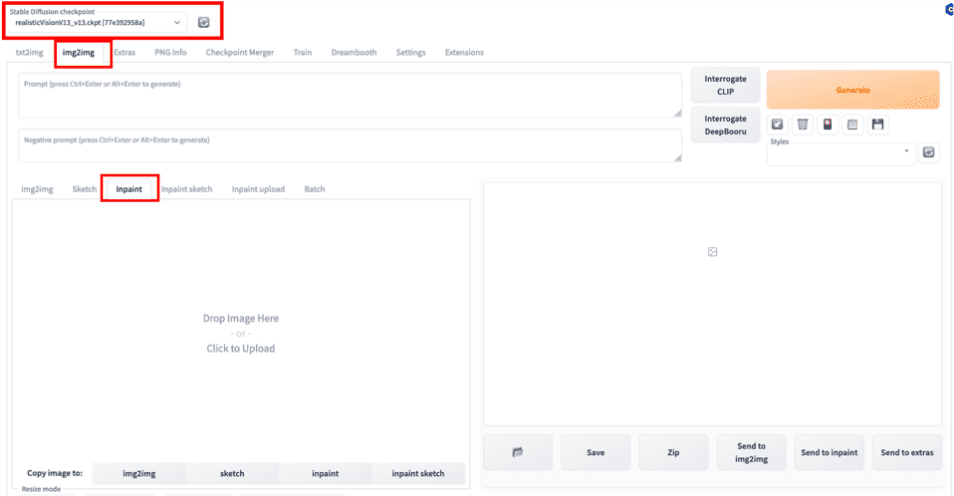

3.4 Wählen Sie in der WebUI das vorab trainierte Modell Realistic Vision V1.3, das wir gerade heruntergeladen haben, als Basismodell aus und wählen Sie die Inpaint-Funktion in img2img als unseren Aufgabentyp aus. Das sogenannte Inpaint ist eigentlich eine Unterkategorie der Bildgenerierungsaufgabe, d. h. die Bildvervollständigung durch Maske (Maske) oder die teilweise Bildgenerierung.

|

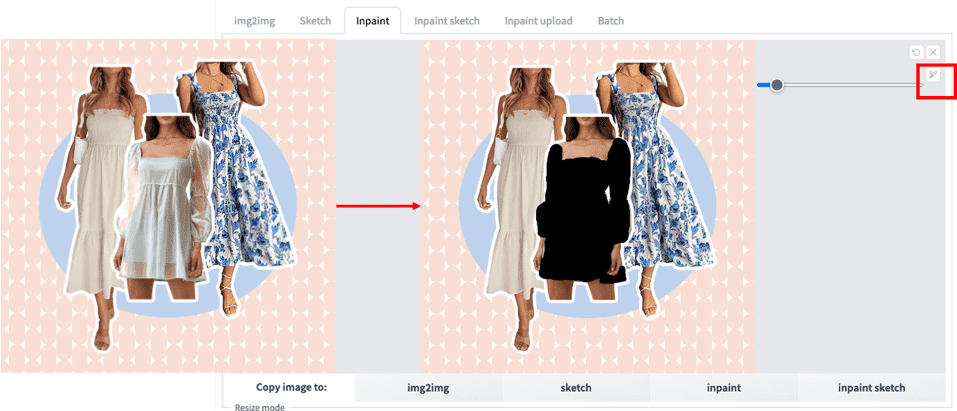

3.5 Laden Sie das Originalbild hoch und zeichnen Sie mit dem Pinsel manuell eine Maske des Bereichs, den Sie bearbeiten möchten.

|

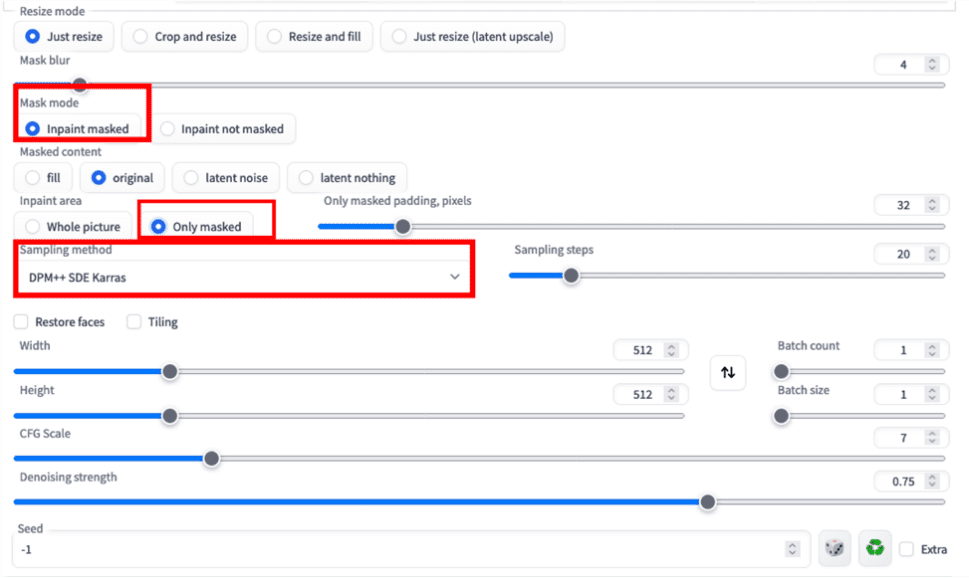

3.6 Konfigurieren Sie die Inpaint-bezogenen Parameter gemäß der folgenden Abbildung. Hier entscheiden wir uns, nur den Maskenteil auszufüllen.

|

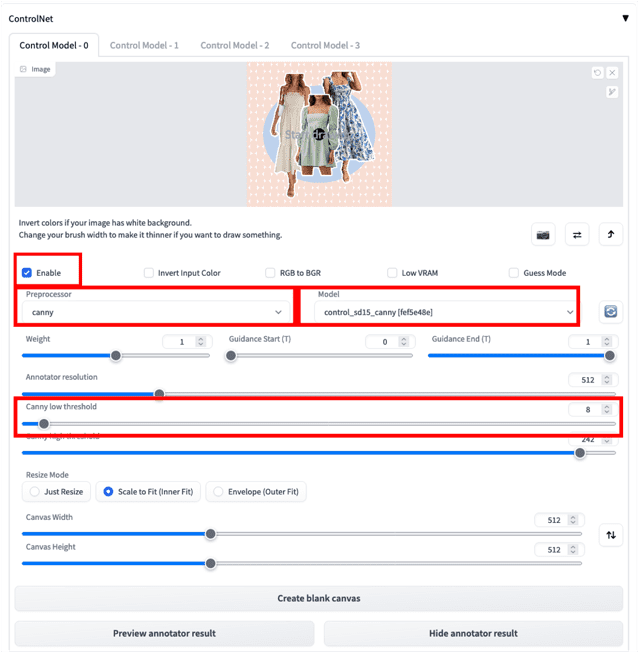

3.7 Laden Sie das Originalbild in ControlNet hoch und konfigurieren Sie die relevanten Parameter wie unten gezeigt. Die ControlNet-Funktion verbessert die Kontrolle über die endgültige Bildgenerierung. Hier wählen wir den Canny-Präprozessor und das entsprechende Canny-Modell zur Generierung des Strichbildes. Durch die Reduzierung des „Canny-Unterschwellenwerts“ können wir mehr Kantendetails im Originalbild erhalten, wie in der Abbildung gezeigt. Informationen zur Installation des ControlNet-Modells finden Sie in den FAQs. Erläuterungen zu Canny und anderen Modellen finden Sie in der Modellinterpretationstabelle im Abschnitt „ControlNet“.

|

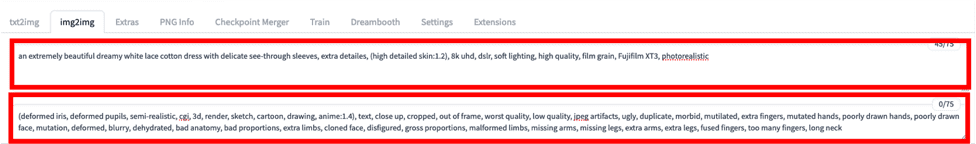

3.8 Geben Sie die Eingabewörter anhand der folgenden Vorlage ein und klicken Sie auf „Generieren“.

Prompt = ein extrem schönes, verträumtes weißes Spitzenbaumwollkleid mit zarten durchsichtigen Ärmeln, zusätzlichen Details (hochdetaillierte Haut: 1,2), 8k UHD, DSLR, sanfte Beleuchtung, hohe Qualität, Filmkörnung, Fujifilm XT3, fotorealistisch

Negative Eingabeaufforderung = (deformierte Iris, deformierte Pupillen, halbrealistisch, CGI, 3D, Rendern, Skizze, Cartoon, Zeichnung, Anime:1.4), Text, Nahaufnahme, abgeschnitten, außerhalb des Rahmens, schlechteste Qualität, niedrige Qualität, jpeg Artefakte, hässlich, Duplikat, morbide, verstümmelt, zusätzliche Finger, mutierte Hände, schlecht gezeichnete Hände, schlecht gezeichnetes Gesicht, Mutation, deformiert, verschwommen, dehydriert, schlechte Anatomie, schlechte Proportionen, zusätzliche Gliedmaßen, geklontes Gesicht, entstellt, krasse Proportionen, missgebildete Gliedmaßen, fehlende Arme, fehlende Beine, zusätzliche Arme, zusätzliche Beine, verschmolzene Finger, zu viele Finger, langer Hals

|

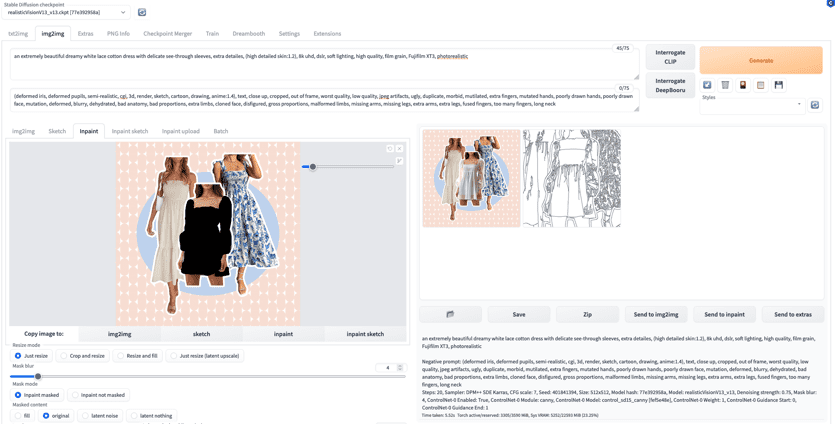

3.9 Nachdem wir auf die Generierung gewartet haben, können wir die folgenden Ergebnisse erhalten.

|

Zusammenfassung:Obwohl der oben beschriebene Vorgang einfach und leicht durchzuführen ist, wäre es sehr zeitaufwändig, die Maske jedes Mal manuell zu erstellen. Im Folgenden zeigen wir Ihnen, wie Sie Bilder per Code bearbeiten.

4 Vollautomatische Bildbearbeitung (automatische Maskierung)

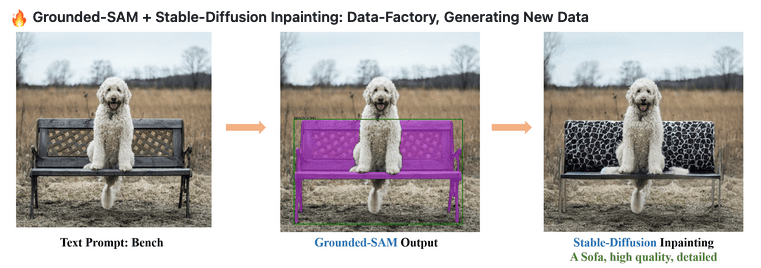

Durch die Kombination der beiden Schlüsselkomponenten Grounding DINO (Detektor) und Segment Anything Model (Segmentierer) wird Grounded-SAM zu einer äußerst leistungsstarken visuellen Anwendungskombination, die die semantische CV-Segmentierung durch Texteingaben durchführen kann. In Kombination mit Stable Diffusion bietet es zweifellos mehr Möglichkeiten für die Generierung multimodaler technischer Bilder. Die experimentellen Schritte sind wie folgt:

|

Bild von https://github.com/IDEA-Research/Grounded-Segment-Anything

4.1 Suchen Sie in CloudFormation-Stack-Output den NotebookURL-Link und öffnen Sie die SageMaker-Notebook-Instanz.

|

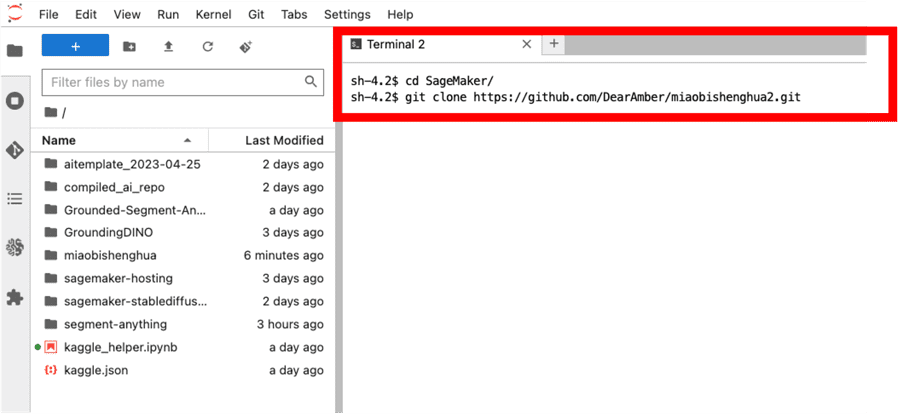

4.2 Klicken Sie auf „Terminal“ und geben Sie nacheinander die folgenden beiden Befehle ein, um den Code lokal zu klonen.

|

|

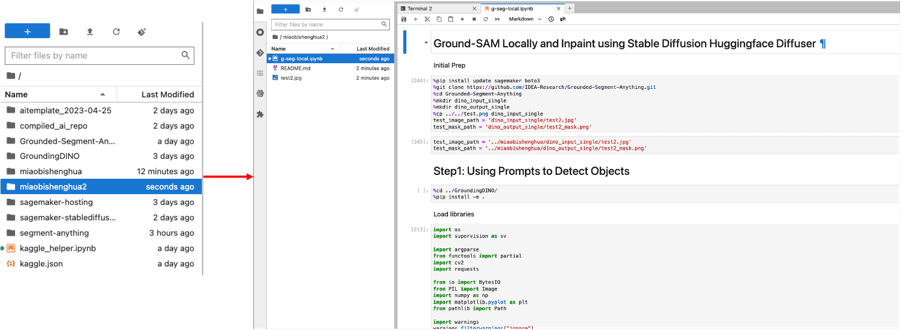

4.3 Wählen Sie im Pfad links „miaobishenghua2“ aus und doppelklicken Sie auf die Datei „g-seg-local.ipynb“. Wählen Sie gleichzeitig „conda_pytorch_p39“ als unsere Umgebung aus.

|

4.4 Führen Sie alle Codefragmente nacheinander aus. Der gesamte Prozess besteht aus drei Hauptteilen.

4.4.1 zeigt Ihnen, wie Sie Erdung DINO, generiert ein vorhergesagtes rechteckiges Feld anhand der Textbeschreibung. Beispiel: Wir möchten ein grünes Kleid auswählen. Geben wir daher „grünes Kleid“ als Eingabewort ein, erhalten wir das folgende Bild. Wir können außerdem den „Box-Schwellenwert“ anpassen, um die Erkennungssicherheit zu steuern, und den „Text-Schwellenwert“, um die Relevanz des Eingabeworts zu steuern und die Endergebnisse zu filtern (Details siehe Code). Das Ergebnis des rechteckigen Felds dient als zusätzliche Eingabeaufforderung für die folgende Segmentierungsaufgabe.

|

Wir können auch versuchen, das Eingabewort in „weißes Kleid mit blauem Muster“ zu ändern. Dann erhalten wir das folgende rechteckige Feld. Obwohl das Kleid ganz links ebenfalls weiß ist, wird es nicht ausgewählt, da es kein blaues Muster hat.

|

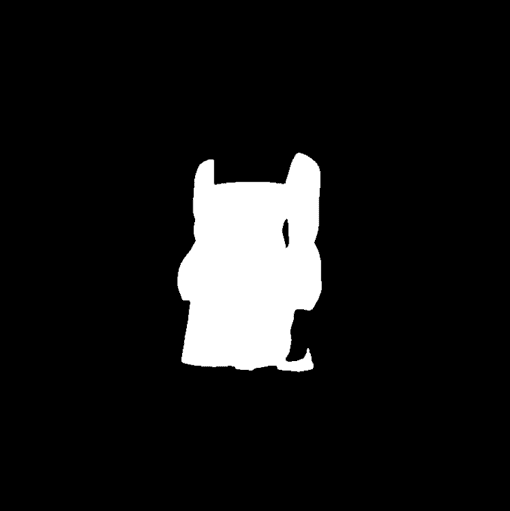

4.4.2 zeigt Ihnen, wie Sie Segmentieren Sie alles Generieren Sie eine Segmentierungsmaske basierend auf dem im vorherigen Schritt vorhergesagten Rechteck. Hier geben wir das vorhergesagte Rechteck als Hilfseingabe ein und begrenzen die Ausgabe auf nur eine Segmentierungsmaske durch „multimask_output=False“ (Details siehe Code). Das Ergebnis ist in der folgenden Abbildung dargestellt. Segment Anything selbst unterstützt auch einzelne und mehrere Punkte als Hilfseingaben, sodass wir schnell und automatisch Masken in Stapeln generieren können, wenn nur das Originalbild verfügbar ist.

|

|

4.4.3 Wir zeigen, wie Sie das Inpainting-Modell der stabilen Diffusion verwenden, um den Inhalt der obigen Maske zu ersetzen. Im Experiment verwendeten wir ml.g5.2xlarge-Instanzen. Bitte passen Sie dies entsprechend Ihrem Instanztyp an. os.environ["CUDA_VISIBLE_DEVICES"] = "0"Hier verwenden wir das Stable-Diffusion-2-Inpainting-Modell, um das folgende Bild zu generieren (Details siehe Code).

|

Zusammenfassung: Basierend auf den oben genannten Methoden können wir eine vollautomatische Bildbearbeitung und Materialgenerierung einfacher und effizienter erreichen. In realen Produktionsumgebungen benötigen wir oft eine komplexere Engineering-Architektur, um den gesamten Workflow weiter zu optimieren. Es ist zu beachten, dass die in diesem Teil des Codes verwendete stabile Diffusion von HuggingFace DiffusorenDa Teams in einem Unternehmen (Designer und technische Entwickler) enger zusammenarbeiten, empfiehlt sich die Verwendung der Stable Diffusion WebUI API zur Implementierung des Workflows der codierten Bildgenerierung und -ausgabe, um die Einheitlichkeit von Parametern und anderen Informationen zu gewährleisten. Dieses Lösungsbeispiel dient als Referenz zur schnellen Verifizierung vollautomatischer Workflows.

Teil 3 Häufig gestellte Fragen

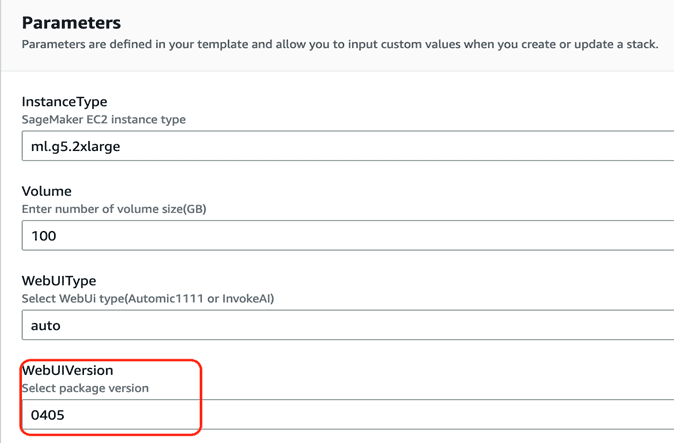

1 Wie aktualisiere ich auf die neueste Version des Schemas (0405)?

Installationsanweisungen finden Sie unter„Helles und brillantes Schreiben – Erstellen Sie schnell eine verwaltete, stabile Diffusion-AI-Malerei-Visualisierungsumgebung basierend auf SageMaker Notebook“Die Standard-WebUI-Version ist 0405. Derzeit wird die Aktualisierung in einer vorhandenen Umgebung nicht unterstützt und muss neu installiert werden.

|

2. Wie gehe ich bei der Bereitstellung der Lösung mit Servicelimitproblemen um?

Bevor Sie diese Lösung bereitstellen, überprüfen Sie bitte, ob das entsprechende Ressourcenkontingent des SageMaker Notebooks (z. B. ml.g4dn.2xlarge für die Nutzung von Notebook-Instanzen) im Servicekontingent der entsprechenden Region erhöht wurde. Die genauen Schritte finden Sie unterLink.

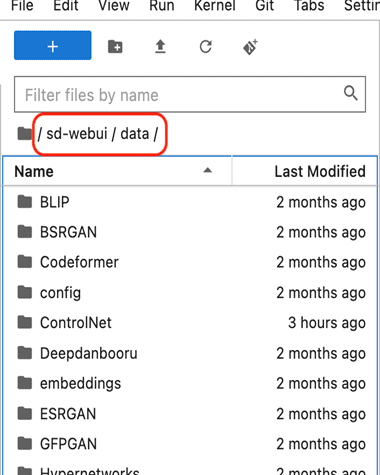

3 Wie verwende ich aus dem Internet heruntergeladene Modelle?

- existieren Wolke Seite „Formationsausgaben“ öffnen NotebookURL Entsprechender Link

- Suchen Sie in der linken Navigationsleiste das Verzeichnis sd-webui/data, wie unten gezeigt

|

- Für das Grundmodell der stabilen Diffusion platzieren Sie Stabile Diffusion Inhaltsverzeichnis

- Für das Lora-Modell platzieren Sie Lora Inhaltsverzeichnis

- Bei ControlNet-Modellen platzieren Sie ControlNet Inhaltsverzeichnis

- Vom Benutzer feinabgestimmte Modelle werden auch in Stabile Diffusion Inhaltsverzeichnis

4 Wie wechselt man zwischen „Automatisch“ und „InvokeAI“?

- Öffnen Sie auf der Seite „Cloud-Formationsausgaben“ NotebookURL Entsprechender Link

- Öffnen Sie ein Terminal und klicken Sie auf Datei->Neu->Terminal

- Geben Sie das folgende Verzeichnis ein

- Automatische WebUI starten

- Starten Sie Invoke WebUI

5 Informationen zur Versionsverwaltung

Wir behalten die letzten beiden Versionen des Plans: 0405 Und 0316.

Zusammenfassen

Dieser Artikel stellt die neuen Funktionen der vorherigen Blog-Lösungsreihe vor, darunter die neue Unterstützung für ControlNet- und Image-Browser-Plug-ins sowie die neue Unterstützung für US West 2 (Oregon). Außerdem werden die Methoden und Schritte zur Verwendung von Grounded-SAM zur Erstellung von Marketingmaterialien für die E-Commerce-Werbebranche auf Basis dieser Lösung und der zugehörigen SageMaker-Dienste beschrieben, darunter: 1. Codefreie Bildbearbeitung durch das Canny-Modell in ControlNet und die Inpaint-Funktion sowie 2. Verwendung von Grounded-SAM (Erdung DINO Und Segmentieren Sie alles) Verwenden Sie Code zum Bearbeiten von Bildern. Darüber hinaus werden wir in der Reihe „Blühendes und wunderbares Schreiben“ weitere Lösungen hinzufügen, die nah an Kundenszenarien liegen. Bei Fragen oder Wünschen stehen wir Ihnen gerne zur Verfügung.